NVIDIA RTX 4090 Founders Edition, análisis y opinión

La tarjeta gráfica más potente del mundo gaming ha pasado por nuestro banco de pruebas y hemos podido sacarle hasta el último megahercio. Tras dos semanas de benchmarks y videojuegos, este es nuestro análisis final sobre la RTX 4090 de NVIDIA. La bestia indomable.

Cuando NVIDIA presentó su nueva serie RTX 40 todo el mundo se fijó en la misma: la GeForce RTX 4090 de 24 GB de VRAM. Esta iba a ser la reina de la generación y, por eso mismo, la GPU de referencia. Absolutamente todo se mediría frente a la RTX 4090.

Junto a la RTX 4090, NVIDIA mostró las RTX 4080 de 12 y 16 GB de VRAM, pero la fama es caprichosa y la gente quería saber cómo rendía la tarjeta gráfica que tiene de precio oficial 1.959 euros (y eso el modelo Founders Edition, veremos qué número ponen el resto de montadores).

Hace dos años analizamos la RTX 3080, una tarjeta gráfica tope de gama que nos fascinó. Y lo brutal es que, al lado de esta, parece amateur tanto en tamaño como en potencia. La RTX 4090 viene a romper todos los esquemas, a convertirse en referencia y a ser la que encabece los benchmarks internacionales.

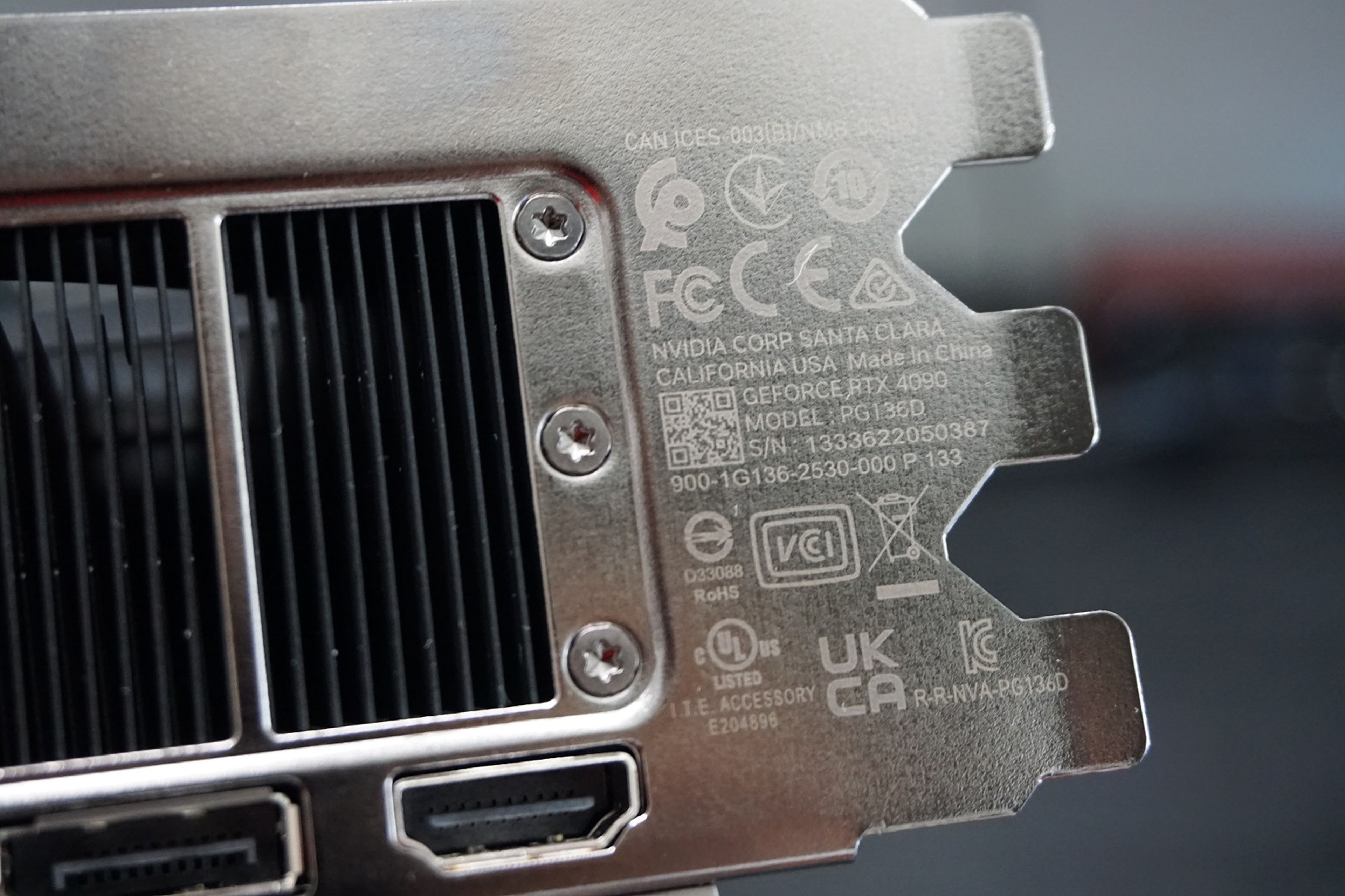

Pero del dicho al hecho hay un trecho. Así que nos pusimos manos a la obra, le pedimos a NVIDIA uno de sus modelos Founders Edition y conforme nos llegó a casa la enchufamos en nuestro ordenador de pruebas. Por eso mismo, comenzamos con las especificaciones técnicas de la GeForce RTX 4090:

| NVIDIA RTX 4090 Founders Edition | |

|---|---|

| Modelo | AD102-300-A1 |

| Núcleo | Ada Lovelace | 4 nm TSMC |

| Interfaz | PCIe 4.0 x 16 |

| Shading Units | CUDA Cores: 16.384 TMUs: 512 ROPs:192 SM Count: 128 Caché L1 128Kb por SM Tensor Cores: 512 RT Cores: 128 Caché total 96 Mbytes |

| Memoria | 24 GB GDDR6X 384 bits Ancho de banda: 1.018 GB/s |

| Frecuencias | Núcleo: 2.235 MHz | 2.520 MHz Boost Memorias: GDDR6X 1.325 MHz | 21,2Gbps efectivos |

| Tecnologías | DX 12 Ultimate | OpenGL 4.6 OpenCL 3.0 | Vulkan 1.3 CUDA 8.9 | Shader Model 6.6 |

| Conectores | 3 x DP 1.3a | 1 x HDMI 2.1a |

| Consumo | 450W máximo Fuente recomendada 850W 3 x 8 Pin PCIe 4 conectores recomendados |

| Dimensiones y peso | 33,6 x 14 x 6,1 cm | 2,18 kg |

| Precio | 1.959 euros |

Tras las especificaciones, nada como dejaros el vídeo del unboxing sobre estas líneas y el texto donde explicamos cómo es la tarjeta gráfica una vez la sacamos de la -gigantesca- caja en la que viene y la intentamos meter en nuestro ordenador. Cosa que no es fácil si tu torre no es generosa.

Por cierto, para esta review de la RTX 4090, hemos usado el siguiente ordenador:

| Ordenador de pruebas | |

|---|---|

| Placa | MSI Gaming Plus Z490 |

| Procesador | Intel Core i7-10700K (máx 4,7 GHz) |

| Memoria RAM | 32 GB DDR4 3.200 MHz |

| GPU | GeForce RTX 4090 Founders Edition 24 GB GDDR6X |

| SSD | SSD SATA (máx 550 MB/s) |

Es cierto que el procesador no nos sirve para buscar números récords (el Intel i7 de 10ª Gen nos hizo cuello de botella en alguna que otra prueba, pero es residual), pero sí que nos dio de sobra para hacernos una visión muy aproximada de todo lo que puede ofrecer la tarjeta en el día a día.

Análisis de la RTX 4090 por apartados:

- Comparativa: RTX 4090 vs 3080

- Rendimiento: la GPU más potente de la historia para mover de verdad el raytracing

- Consumo: todavía más alto que en la generación anterior

- Disipación: NVIDIA hace los mejores diseños (y los más elegantes)

- DLSS 3.0: la verdadera revolución del gaming

- Conclusión: no es el salto que esperábamos, pero lo será

RTX 4090 vs RTX 3080

Una review de una tarjeta gráfica no es nada si no se compara con su hermana pequeña. Es decir, nadie sabe cuan potente es una GPU si no la vemos enfrentada a la que fue su gemela de la pasada generación. En este caso, la vamos a comparar con la RTX 3080 que analizamos en 2020.

Para empezar, y como es tradición, vamos a poner cara a cara las dos tarjetas gráficas en algunos de los benchmarks más famosos del momento, tanto sintéticos como con juegos que tiran del raytracing más bestia que se puede encontrar en Steam.

| RTX 4090 a 1.440 px | RTX 3080 a 1.440 px | %mejora | |

|---|---|---|---|

| 3D Mark Time Spy | 27.560 total 33.060 vinculado a GPU 11.397 vinculado a CPU | 15.477 total 17.155 vinculado a GPU 11.332 vinculado a CPU | +78% +92,71% +0,5% |

| 3D Mark Raytracing | 135,63 fps | 47 fps | +239,15% |

| Boundary RTX | 107 fps | 70,1 fps | +52,63% |

| Bright Memory Infinite | 112 fps | 73 fps | +53,42% |

| Geenbench 5 Open CL | 305.925 puntos | 181.177 puntos | +68,85% |

Las pruebas las hemos ejecutado siempre en resolución de 1.440 px (conocido también como 2,5K) debido a que nuestro monitor de pruebas es un Viewsonic IPS de 165 Hz con G-Sync de resolución 2.560 x 1.440 px. Pero sirven para comprobar las brutales diferencias entre ambas gráficas.

Para entender las diferencias tan abismales entre ambas tarjetas, nada como poner a las dos cara a cara en términos de especificaciones técnicas, pero sin entrar demasiado en detalle, tan solo en las características diferenciales. Vamos a verlas:

| RTX 4090 | RTX 3080 | |

|---|---|---|

| Núcleo | Ada Lovelace AD102 | Ampere GA102-200 |

| CUDA Cores | 16.368 | 8.704 |

| Memoria | 24 GB | 10 | 12 GB |

| Tipo de memoria | GDDR6x | GDDR6x |

| Ancho de banda | 1.008 GB/s | 760 GB/s |

| Consumo | 450W | 330W |

Lo más llamativo es ver que tenemos el doble de CUDA Cores, el doble de memoria VRAM, un 60 % más de ancho de banda y unos 120 W más de consumo que viene siendo un 36% más de energía consumida. Sin duda, son cosas para tener muy en cuenta si nos ponemos a comparar.

Ahora verás que las diferencias en juegos son brutales.

La GPU más potente de la historia para mover de verdad el raytracing

Lo que quiere el gamer, el que de verdad va a soltar 2.000 euros en una tarjeta gráfica, es saber qué tal va la GPU en un ambiente real. Dícese: jugando a videojuegos. Porque, ¿si no de qué íbamos a ahorrar todo un año para hacernos con una? En ese sentido, los números marean.

Para hacer la comparación hemos ejecutado alguno de los juegos más demandantes del momento, todos ellos con raytracing, y los hemos puesto en la máxima calidad que nos permitía el juego. Por lo que todas las pruebas tienen un entorno igual: 1.440 px de resolución y calidad Ultracon raytracing incluido.

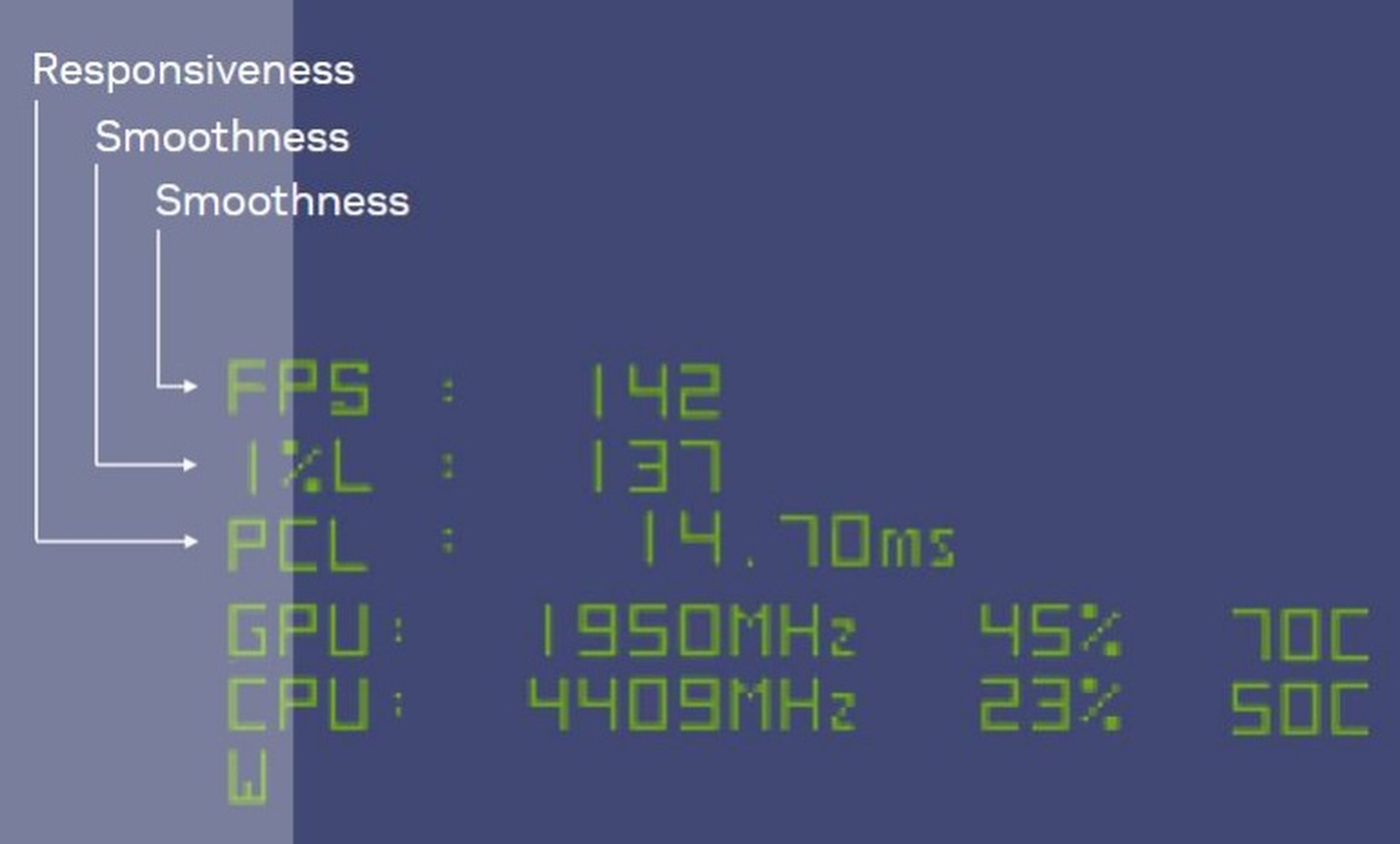

Por cierto, para hacer las mediciones hemos usado el programa que nos ha facilitado NVIDIA llamado FrameView, el cual hace mediciones exactas de un montón de parámetros mientras estamos jugando. Nosotros hemos hecho caso de tres conceptos: la media, el 1% Low y el PCL (latencia). De eso hablaremos más tarde.

Con el escenario claro, vamos a ver las diferencias con su hermana pequeña. Recordad en este punto de que las diferencias podrían ser aún mayores en otras pruebas debido al pequeño cuello de botella del Intel i7-10700K cuando sobrepasamos los 200 fps (que se dice pronto).

| FPS de media (Frameview) | RTX 4090: 1.440 px | Ultra | RTX 3080: 1.440px | Ultra | % mejora |

|---|---|---|---|

| Overwatch 2 | 451 (no raytracing) | 206,8 (no raytracing) | +118% |

| Doom Eternal | 309 | 306 | +0,9% |

| Battlefield 2042 | 116 | 89 | +30,77% |

| Spider-Man | 121 | 98 | +23,47% |

| Cyberpunk 2077 | 67 | 42 | +59,52% |

Estos números son sin meter nada del DLSS 3.0 del cual hablaremos más tarde. Si no que estamos viendo a la gráfica mover en nativo una resolución 2,5K junto a calidades en Ultra y el raytracing puesto al más alto nivel. La mejora es más que evidente.

Si extrapolamos y tocamos un par de detalles técnicos se puede conseguir sin problema el 4K y 60 FPS en Ultra y con raytracing puesto. Y ahora de verdad, nada de rascadas. Pero NVIDIA no está en esta guerra porque cuenta con el DLSS 3.0 que va a revolucionar el sector con su gigantesco salto en rendimiento.

Para quienes piensen que estos números no son todo lo alto que deberían, recordad que en las consolas de nueva generación -con muchísima optimización detrás- los juegos llegan a 4K y 30 FPS con el raytracing puesto a cambio de bajar las calidades gráficas entre bajo / medio. La mejora es abismal.

Y para quien dude, una vez quitamos el raytracing los números se disparan a lo bestia. El Overwatch 2 alcanza picos de 580 fps, el Battlefield 2042 unas medias de 124 fps, en Cyberpunk alcanzamos los 156 fps de media... Son tasas tan altas que muchos monitores no pueden manejarlas.

Por último, recordad que estamos con una tarjeta gráfica con drivers recién salidos del horno y con muchísimo camino por recorrer. De aquí a un año de parches y actualizaciones la tarjeta estará rindiendo muchísimo más que ahora (las GPUs suelen ganar un 5 /15 % de rendimiento a lo largo de su vida útil).

Un consumo todavía más alto que en la generación anterior

Este es el gran punto negativo de la tarjeta. Consume más que ninguna GPU de NVIDIA a lo largo de su historia. La compañía asegura una potencia de hasta 450 W que nosotros hemos podido comprobar en varias ocasiones, tanto pasando benchmarks como jugando.

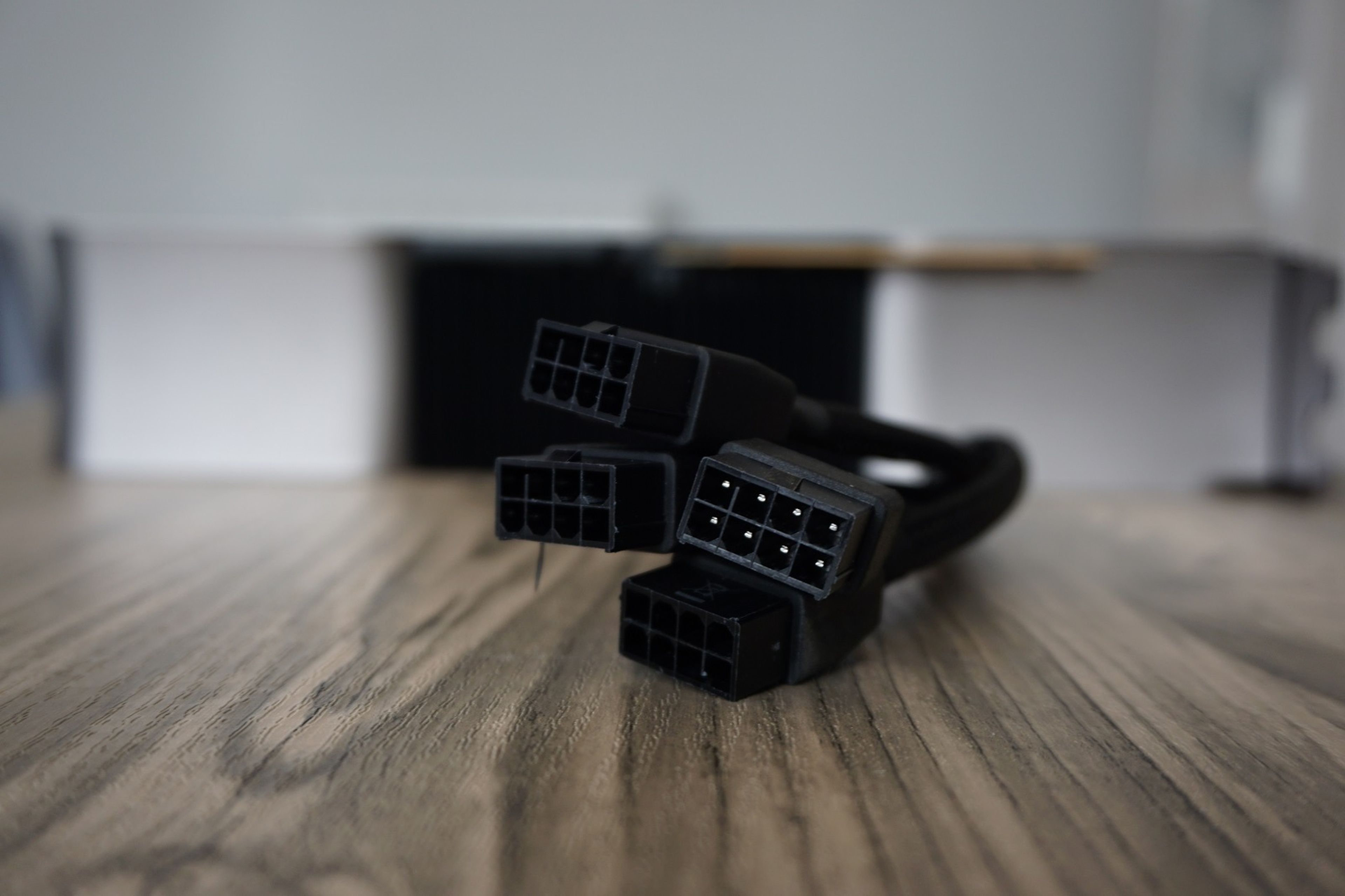

Para poder dar la energía suficiente que pide la RTX 4090 Founders Edition, NVIDIA ha vuelto a confiar en su nuevo puerto de 12 pines que, si bien queda estético, nos hace tener que usar el adaptador que nos trae la caja.

NVIDIA explica que, en ese alargador de 4 puertos, solo debemos enchufar 3 de 8 pines PCIe para usarla con normalidad, y que si vamos a hacer overclock sí debemos enchufar el cuarto puerto. En nuestro caso le hemos puesto los cuatro, por si acaso.

A su vez, NVIDIA explica que la GeForce RTX 4090 Founders Edition también puede aceptar un solo cable PCIe Gen 5 de 16 pines (12VHPWR) de 450 W o superior desde una fuente de alimentación compatible (las ATX 3.0).

En los tiempos que corren y llevando un chip fabricado en 4 nm de TSMC, esperábamos que la gráfica hubiese conseguido bajar consumos. 450 W en pleno 2022 es un disparate, por el derroche energético y porel precio de la factura de la luz. Una hora de Cyberpunk 2077 nos va a salir tan cara como tener puesto el aire acondicionado en verano.

Para que nos hagamos una idea, con un medidor de pared que nos daba el consumo en tiempo real, todo nuestro PC consumía unos 580 W a plena carga, jugando. Si a tu equipo le pones una CPU más potente que la nuestra no será raro ver consumos de 620 / 650 W. De ahí que aconseje NVIDIA que la fuente de alimentación no sea menor a 850 W.

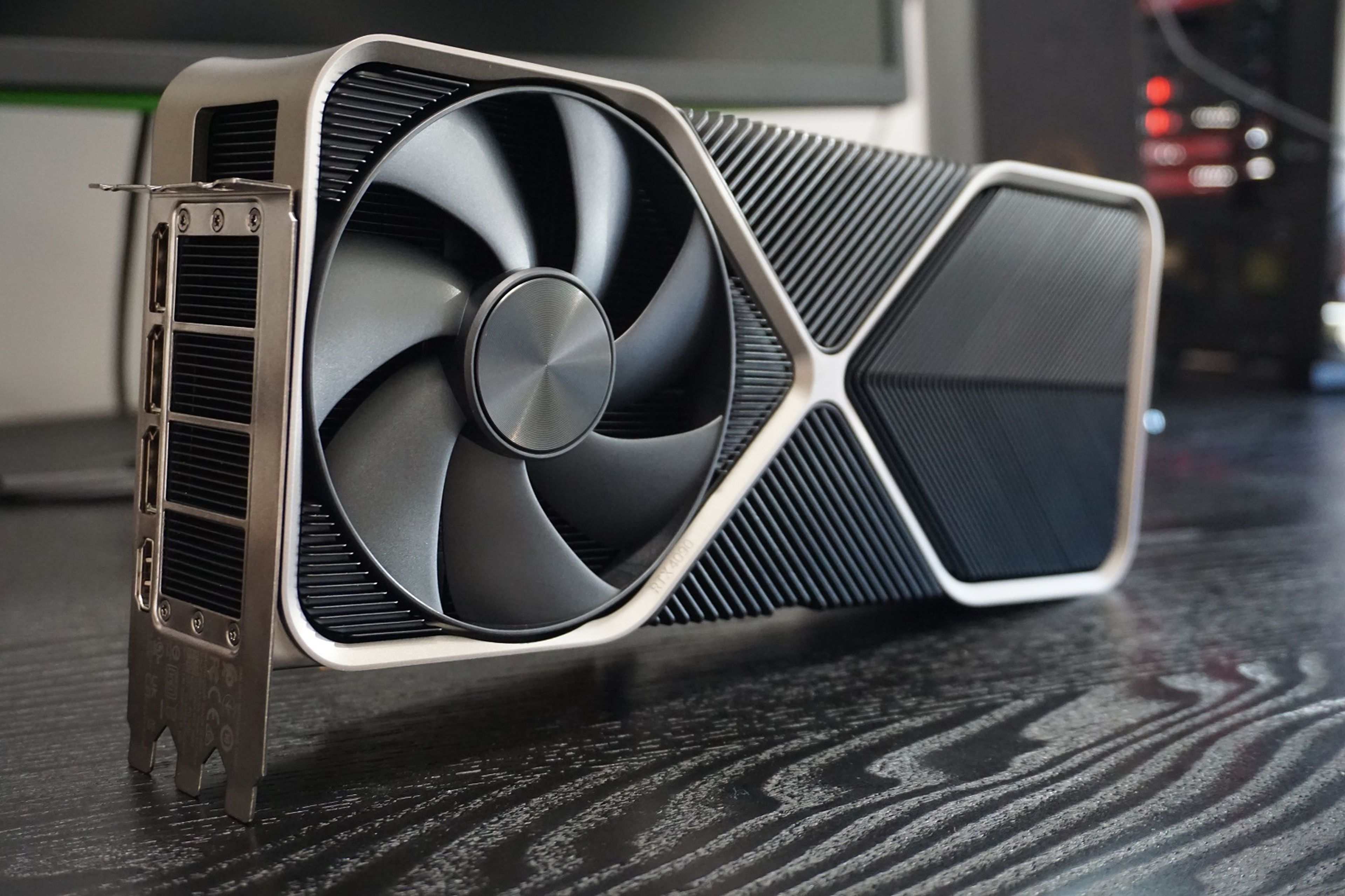

NVIDIA hace los mejores diseños (y los más elegantes)

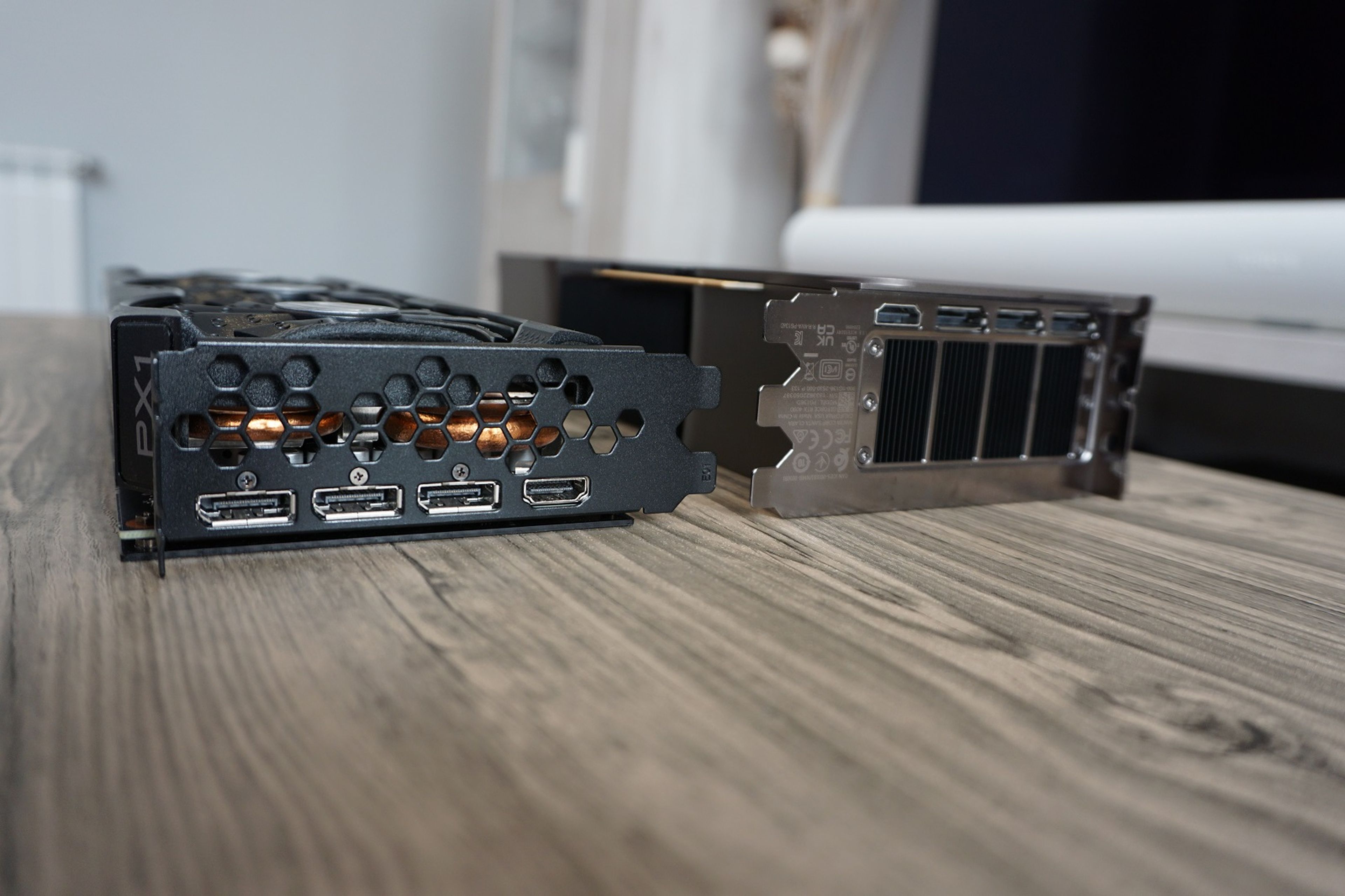

Aquí no hay duda. Mientras el resto del mercado lanza diseños llamativos, agresivos, llenos de luces y ángulos imposibles en tamaños que no son operativos, NVIDIA opta por la sencillez y la elegancia, con un resultado que es, sencillamente, impresionante.

Si bien la RTX 4090 Founders Edition es mucho más grande que la RTX 3080 Founders Edition, los primeros modelos custom que han empezado a anunciarse ganan en tamaño a la propuesta de NVIDIA. Es un poco como las películas de monstruos: siempre hay uno que es más grande que el anterior.

Como ya vimos con la RTX 3080, la compañía verde ha optado por un sistema híbrido que arroja unos resultados muy buenos. La GPU es un gran disipador de aluminio de enormes dimensiones que lleva en cada cara un gigantesco ventilador.

Uno se encarga de meter aire fresco directamente al disipador mientras que el otro es el encargado de expulsarlo fuera de la torre a través de una cámara de vapor. Como tiene tres slots de ancho, la gráfica consigue mantener a raya las altas temperaturas: hay cobre y aluminio para dar y regalar.

| Temperatura máxima | RTX 4090 Founders Edition | RTX 3080 Founders Edition | Diferencia |

|---|---|---|---|

| Overwatch 2 | 67º | 80º | -13 ºC |

| Doom Eternal | 59º | 79º | -20 ºC |

| Battlefield 2042 | 55º | 79º | -24 ºC |

| Spider-Man | 56º | N.D. | N.D. |

| Cyberpunk 2077 | 61º | N.D. | N.D. |

La temperatura máxima que hemos podido medir han sido 67º en plena carga de benchmark (con 3D Mark) y jugando a Overwatch 2 donde nos íbamos a los 500 fps y a los 430 W de consumo. Y ni así conseguimos que subiera a 70º. Lo que es un milagro por parte de los ingenieros de NVIDIA.

Pesando 2,18 kg y con un largo que llega a los 31 cm te aconsejamos que lleves mucho cuidado al manipularla, ya que podría irse al suelo en cuanto te flaqueen las manos. Sin duda, es incómoda de instalar y montar, como gran punto negativo.

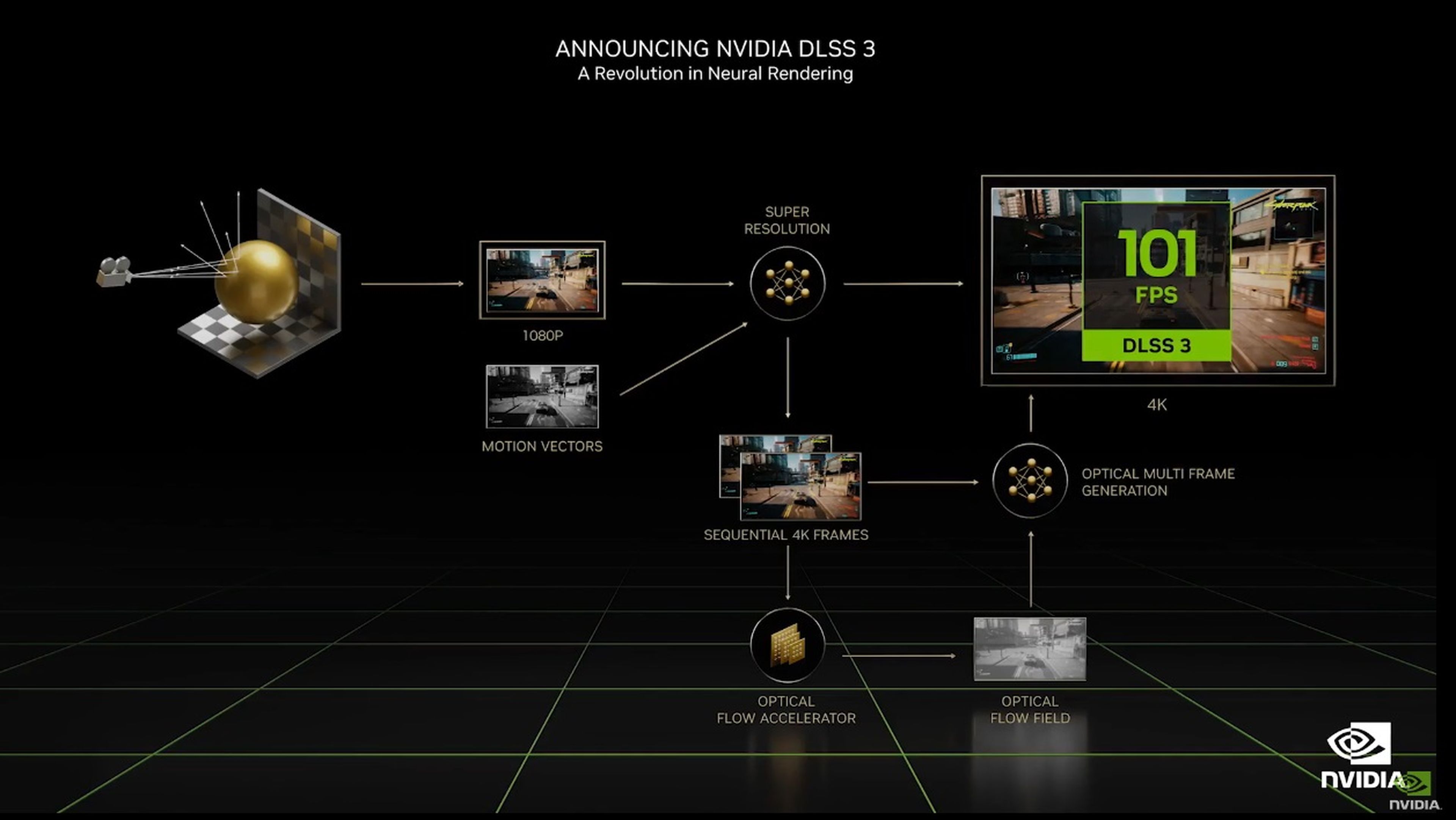

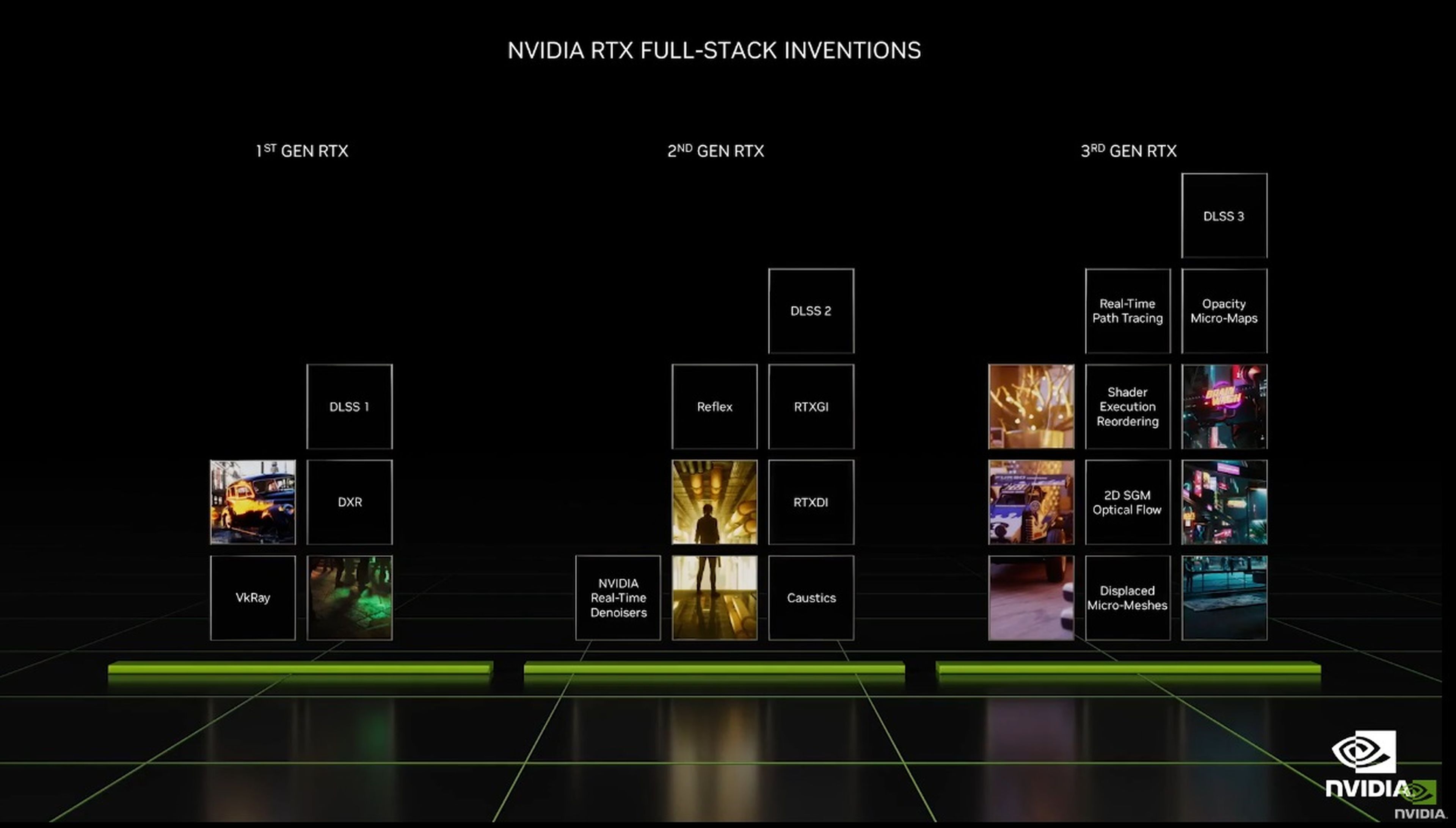

La verdadera revolución del gaming se llama DLSS 3.0

Aquí nos arremangamos porque toca hablar de la arquitectura de la gráfica, de su tecnología y de la promesa que puede cambiarlo todo: el DLSS 3.0. Pero empezamos por el principio, que somos muy ordenados aquí.

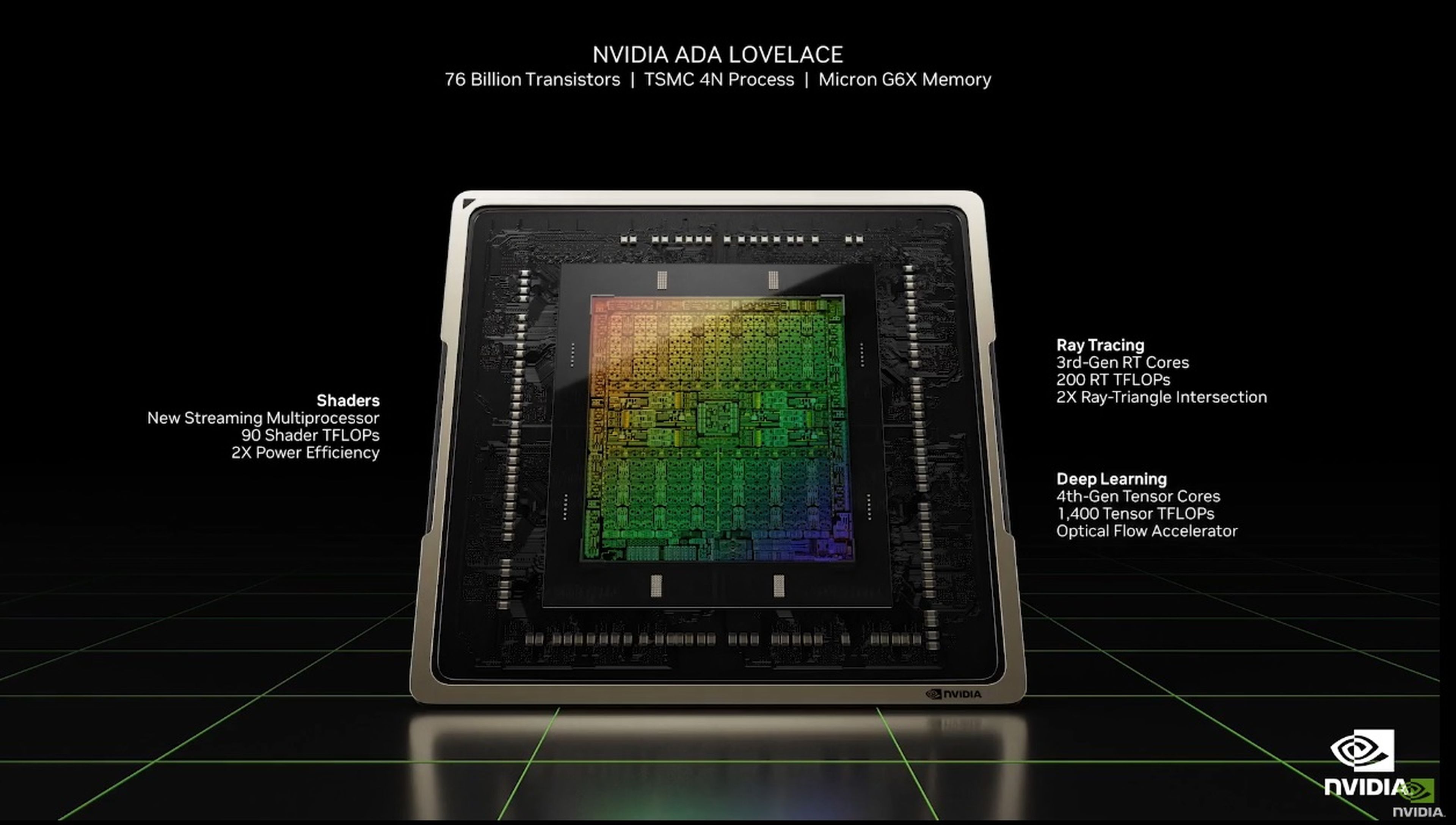

En el corazón de la GeForce RTX 4090 se encuentra el gigantesco silicio AD102. Construido en un proceso de fabricación de silicio de 4 nm, este chip mide 608 mm² de superficie y contiene 76.300 millones de transistores. El chip más avanzado de NVIDIA en su historia.

El AD102 cuenta con una interfaz de PCI-Express 4.0 x16 y una interfaz de memoria GDDR6X de 384 bits. El motor Gigathread, como ya vimos en las filtraciones, actúa como componente principal de asignación de recursos del silicio.

El chip cuenta con el doble de motores de hardware de codificación de medios que Ampere, la arquitectura de las RTX 3000, incluida la codificación/decodificación AV1 acelerada por hardware. Los múltiples aceleradores permiten transcodificar varios flujos de vídeo (genial para los creadores de contenido).

Los principales componentes de renderización de gráficos del AD102 son los GPC (grupos de procesamiento de gráficos). Hay 12 de ellos, frente a los 7 de Ampere. Cada GPC comparte un motor de rasterización y backends de renderizado con seis TPC (clusters de procesamiento de texturas).

Cada TPC contiene dos SM (multiprocesadores de flujo), la maquinaria indivisible de procesamiento de números de la GPU NVIDIA. En el SM es donde NVIDIA realiza la máxima innovación arquitectónica y de dónde saca el gran rendimiento que se espera.

Cada SM contiene un núcleo RT de tercera generación, una caché L1 de 128 KB y cuatro TMU, entre cuatro clusters que contienen cada uno 16 núcleos CUDA FP32, 16 núcleos CUDA, 4 unidades de carga/almacenamiento, una diminuta caché L0; un archivo de registros y el importantísimo núcleo tensor de cuarta generación.

Por tanto, cada SM contiene un total de 128 núcleos CUDA, 4 núcleos Tensor y un núcleo RT. Hay 12 SM por GPC, es decir, 1.536 núcleos CUDA, 48 núcleos Tensor y 12 núcleos RT por GPC. Todo esto suman: 18.432 núcleos CUDA, 576 núcleos Tensor y 144 núcleos RT.

Y la gigantesca cantidad de datos que te acabamos de dar se traduce en: rendimiento brutal codificando vídeo, ejecutando videojuegos, calculando los trazados de los rayos en tiempo real para la iluminación y el poder ejecutar los juegos a muy baja resolución para ganar rendimiento y reescalar la imagen a 4K a base una inteligencia artificial.

Sí, este punto final es el DLSS 3.0. Lo primero es decir que DLSS significa Deep Learning Super Sampling. Es decir, aprendizaje profundo del reescalado. Lo que hace, de forma resumida, es ejecutar los juegos a muy baja resolución (540 px ó 720 px) y luego recrea la imagen a 4K.

Al hacer esto, la tarjeta gráfica puede crear muchos más fotogramas por segundo y el juego se mueve mucho más fluido. La teoría es fácil, lo difícil es la práctica. ¿Es posible crear una imagen tan limpia y pura en 4K si hemos tenido reescalarla desde los 540 px? NVIDIA lo está consiguiendo.

Ahora mismo vamos por la tercera generación de DLSS y el proceso cada vez es más complejo, lo que da mejores resultados, mientras consiguen que el camino sea más eficiente, por lo que se pueden conseguir mayores beneficios en términos de fps.

NVIDIA asegura que DLSS 3.0 puede alcanzar hasta un x4 los números de DLSS 1.0. Y nosotros lo hemos puesto a prueba en algunos benchmarks y videojuegos que ya tienen DLSS 3.0.

Para ello, eso sí, hemos tenido que recurrir a betas que nos han facilitado desde la compañía americana, así que podemos asegurar que es tecnología muy verde todavía.

Por cierto, todos los datos han sido medidos con FrameView, la nueva herramienta de NVIDIA.

| RTX 4090 | No DLSS | DLSS (modo rendimiento) | % Mejora con DLSS |

|---|---|---|---|

| 3D Mark DLSS (4K - Performance) | 56,83 fps | 188,45 fps (DLSS 3.0) | +231,6% |

| Doom Eternal | 309 fps | 351 fps | +13,59% |

| Battlefield 2042 | 116 fps | 161 fps | +38,79% |

| Spider-Man | 121 fps | 149 fps | +23,14% |

| Cyberpunk 2077 | 67 fps | 177 fps (DLSS 3.0) | +164,18% |

| Lyra | 152 fps | 181 fps (DLSS 3.0) | +19,07% |

| Boundary RTX | 107 fps | 203 fps | +89,72% |

Como se puede observar, las diferencias en algunos programas son descomunales. Hablamos de una mejora x3 en 3D Mark DLSS: de 56 fps a unos casi 190 fps. Esta prueba usa DLSS 3.0 y es de las que nos ha facilitado NVIDIA por ser una funcionalidad cerrada por el momento.

En cuanto a Cyberpunk 2077, donde también tuvimos que acceder a una Build preparada que sí llevaba DLSS 3.0 volvemos a ser enorme diferencia. Si lo otro era un benchmark sintético, ahora hablamos de un videojuego y hemos pasado de 67 fps a unos impresionantes 177 fps. Es una locura.

¿Más ejemplos? Los otros juegos que hemos podido probar han sido F1 22 y Microsoft Flight Simulator. El simulador de Fórmula 1 de EA logra también unas cifras de rendimiento espectaculares jugando en 4K con DLSS 3.

Así, con DLSS 3 en modo rendimiento, F1 22 a 4K alcanza los 228 fps, mientras que sin estas mejoras a 4K, con Ray Tracing, alcanza los 93,8 fps. Es decir, más de el doble de fps ganados.

El último juego al que hemos tenido acceso con mejoras para la nueva RTX 4090 ha sido Microsoft Flight Simulator, el aclamado simulador de vuelo, en el que por supuesto también hemos cargado los datos de satélite para que muestre el mayor nivel de detalle posible.

Con todo al máximo, jugando a 4K y con DLSS 3 activado, Microsoft Flight Simulator ha alcanzado una media de 136 fps y una latencia de 43,7 ms. Sin las mejoras activadas, el rendimiento baja hasta los 63,8 fps de media y un tiempo de latencia de 41,8 ms.

El resto de los programas y videojuegos que hemos probado llevaban DLSS, pero no especificaban qué versión, por lo que podemos estar ante versiones 1.0 o 2.0 y de ahí la menor mejora (no os olvidéis del cuello de botella, en el caso de Doom Eternal es evidente).

Lo importante es quedarse con los datos del Cyberpunk 2077, ya que es un juego con el que han trabajado conjuntamente NVIDIA y CD Projekt Red, consiguiendo unos resultados muy prometedores.

De aquí a unos años podríamos tener una gran mayoría de juegos funcionando con DLSS 3.0 y ese sería un salto brutal para todos. La única forma real de alcanzar el 8K en videojuegos sin morir en el intento.

En cuanto al FrameView, esta herramienta permite medir el consumo y el rendimiento de la gráfica en tiempo real gracias a las API que incorpora. Dicha información se almacena y se relaciona con la potencia de la gráfica.

Según la compañía FrameView ofrece un “mayor grado de precisión que muchas otras herramientas y métodos, lo que la convierte en la aplicación ideal para la evaluación comparativa”. Dicha información aparece en dos columnas.

El primer valor son los fps reales que vemos (luego hace una media muy fiable de toda la prueba), el segundo valor es el 1% de los fps de valor más bajo (es decir, los picos más bajos), y por último mide la latencia que hay entre la señal y la pantalla (este último valor a veces da error, cosas de la herramienta de NVIDIA).

Durante todas las pruebas hemos tenido el FrameView abierto para comprobar que los datos que nos iban dando los benchmarks y los juegos eran reales, ya que el DLSS 3.0 puede dar fallos con las herramientas tradicionales de medición, o eso aseguran desde NVIDIA.

No es el salto que esperábamos, pero lo será

¿Acaso no es la GeForce RTX 4090 una tarjeta que destroza a cualquiera? Sí, de eso no hay duda. Entonces ¿por qué decís que no es lo que esperabais? Muy sencillo: queríamos un salto de arquitectura que nos diera potencia junto a eficiencia.

La RTX 4090 consume 450 W y ese no puede ser el camino de la informática, como parece ser que va a ser. Intel ha anunciado que sus nuevos procesadores llegaran a los 200 W, AMD ha anunciado una subida del 70 % en el consumo de sus Ryzen 7000... y mientras la informática bajando nanómetros.

Nosotros esperábamos que con el cambio de litografía a los 4 nm de TSMC, NVIDIA conseguiría bajar los vatios de consumo de sus topes de gama y, a la vez, mejorar en rendimiento. Pero no ha sido así. Hemos vuelto a subir un escalón energético y ya van...

El titular del apartado, por si te lo preguntas, no es porque no sea potente. No hemos visto nada igual. Si no porque es una tarjeta que va a ganar muchísimo con el tiempo. De aquí a uno o dos años, con muchos más juegos con DLSS 3.0 y con drivers mucho más actualizados, la 4090 puede ser una GPU para toda una década de gaming.

Quitando esto, lo que es innegable es que la RTX 4090 es la tarjeta gráfica más potente que hayamos analizado nunca. Jamás hemos tenido una potencia similar en nuestro ordenador: absolutamente nada puede con ella y eso es impresionante.

La tarjeta está bien construida, es silenciosa, gestiona de maravilla el calor, es bonita y rinde como una máquina celestial para cualquier gamer.

Por todo esto, si lo que buscas es tener la mejor GPU del mundo en tu ordenador sin importar el coste, la RTX 4090 Founders Edition es tu tarjeta, no existe otra igual.

Y no lo decimos solo nosotros, nuestros compañeros de Hobbyconsolas la han puesto a prueba con los últimos juegos del mercado más tiempo que nosotros y coinciden en que NVIDIA está haciendo muy bien las cosas.

Nuestra valoración

Lo mejor

- La GPU más potente

- Diseño discreto

- DLSS 3

- Muy buena refrigeración

Lo peor

- Demasiado grande

- Consumo muy elevado

- Tecnologías aún verdes

- Precio

Otros artículos interesantes:

Descubre más sobre Chema Carvajal, autor/a de este artículo.

Conoce cómo trabajamos en Computerhoy.