¿Qué es la Ley de Inteligencia Artificial de la Unión Europea?

En abril de 2021 la Comisión Europea presentó su propuesta de Reglamento del Parlamento Europeo y del Consejo por el que se establecen normas comunes para la inteligencia artificial, también conocida como Ley de IA de la Unión Europea.

Las nuevas tecnologías que se están presenciando en las últimas décadas tienen un claro protagonista: la inteligencia artificial. Y parece que se está haciendo palpable, más que nunca, la necesidad de que esta sea regulada y se desarrolle desde ya bajo una normativa.

Parece haber un acuerdo generalizado de que el crecimiento de la IA se está acelerando y podría salirse de control. Aunque los desarrollos de esta sin duda merecen toda la atención, también es necesario tener cuidado de que esta euforia no acabe volviéndose en contra.

Aquí se encuentra la necesidad de equilibrar derechos fundamentales como la privacidad de los datos y que todos los usuarios tengan acceso a sus beneficios con el objetivo de evitar que miles de empresas se lancen sin reparo a innovar en IA, dando lugar a herramientas o sistemas fallidos.

En abril de 2021, la Comisión Europea publicó su propuesta de 108 páginas para regular la inteligencia artificial (IA), describiéndola como un intento de garantizar un "mercado interno que funcione bien para los sistemas de inteligencia artificial" que se base en "los valores y principios de la UE".

Este es el primer gran intento de Europa para regular una necesaria tecnología que potencialmente puede tener grandes repercusiones globales. Sin embargo, tras varios años y algún que otro primer paso, parece que está costando que salga a flote.

- ¿Qué es la Ley de Inteligencia Artificial de la UE?

- La Unión Europea determina 4 tipos de IA para su legislación

- ¿Cuándo entrará en vigor?

¿Qué es la Ley de Inteligencia Artificial de la UE?

La legislación propuesta, la Ley de Inteligencia Artificial, se enfoca principalmente en fortalecer las reglas sobre la calidad de los datos, la transparencia, la supervisión humana y la responsabilidad. También tiene como objetivo abordar cuestiones éticas y desafíos de implementación en varios sectores que van desde la atención médica y la educación hasta las finanzas y la energía.

La ley propuesta también tiene como objetivo establecer una Junta Europea de Inteligencia Artificial, que supervisaría la implementación de la regulación y garantizaría una aplicación uniforme en toda la UE.

"La IA existido durante décadas, pero ha alcanzado nuevas capacidades impulsadas por el poder de la computación", dijo Thierry Breton, Comisionado de Mercado Interior de la UE, en un comunicado. La Ley de Inteligencia Artificial tiene como objetivo "fortalecer la posición de Europa como un centro global de excelencia en IA desde el laboratorio hasta el mercado, garantizar que la IA en Europa respete nuestros valores y reglas, y aprovechar el potencial de la IA para uso industrial".

Las propuestas argumentan que aquellos que infrinjan la Ley de IA enfrentan multas de hasta 30 millones de euros o el 6% de las ganancias globales, lo que sea mayor. Para una empresa como Microsoft, que respalda al creador de ChatGPT, OpenAI, podría significar una multa de más de 10.000 millones de dólares si se descubre que viola las reglas.

La Unión Europea determina 4 tipos de IA para su legislación

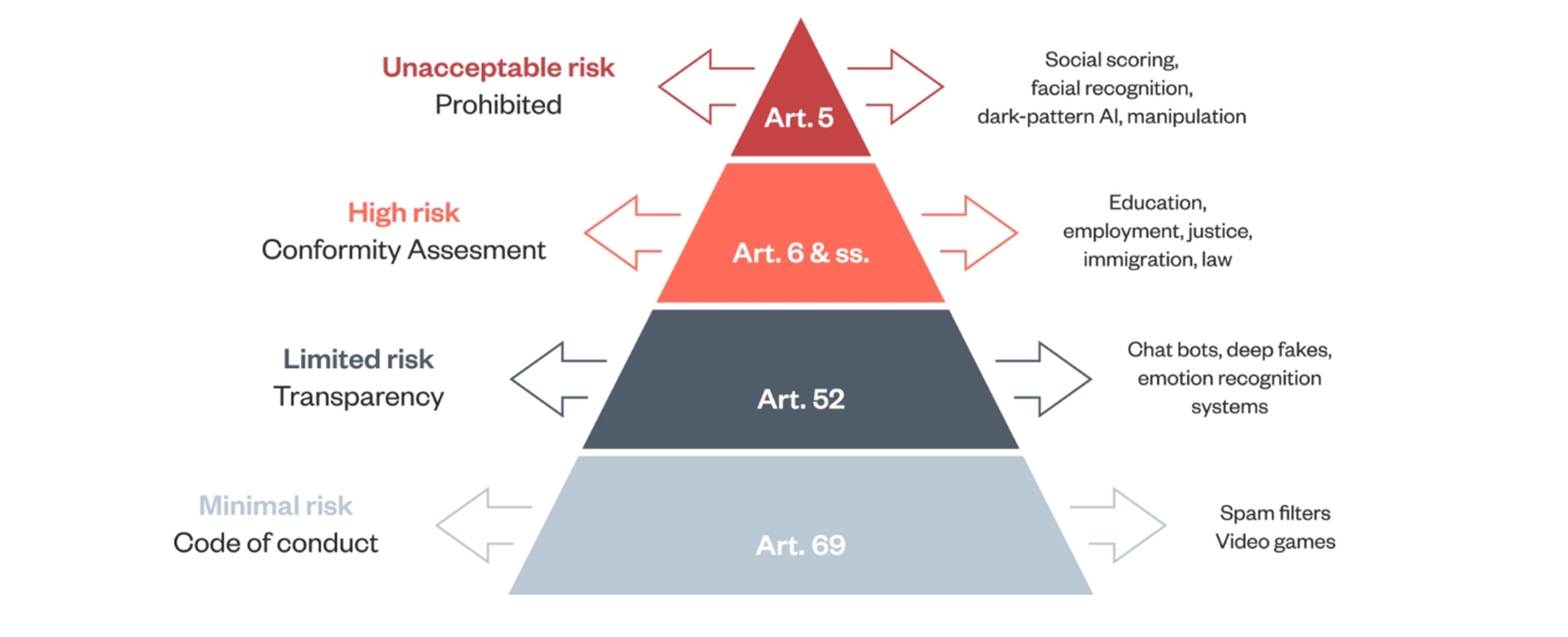

La piedra angular de la Ley de IA es un sistema de clasificación que determina el nivel de riesgo que una tecnología de IA podría representar para la salud y la seguridad o los derechos fundamentales de una persona. El marco incluye cuatro niveles de riesgo: inaceptable, alto, limitado y mínimo.

1. Riesgo inaceptable

Se trata de aplicaciones de IA prohibidas consideradas inaceptables por atentar contra los valores de la UE , por ejemplo, al violar los derechos fundamentales. Aquí se incluye:

- Técnicas subliminales: IA "que utiliza técnicas subliminales… para distorsionar materialmente el comportamiento de una persona de una manera que cause o pueda causar… daño físico o psicológico" .

- Manipulación: un sistema de IA que explota cualquier vulnerabilidad de un grupo específico de personas debido a su edad o discapacidad, por ejemplo, para en pocas palabras causar daño.

- Puntuación social: un sistema de crédito de comportamiento social creado o utilizado por una autoridad pública para evaluar o clasificar la "confiabilidad" de las personas.

- Biometría: sistemas de identificación biométrica remota en tiempo real en espacios públicos utilizados por las fuerzas del orden.

2. Alto riesgo

Los sistemas de IA de alto riesgo estarán bajo un control detallado, pero no se consideran tan peligrosos como para prohibirlos. Éstas incluyen una lista exhaustiva de 8 sistemas de IA de alto riesgo, que incluye:

- Infraestructuras críticas —por ejemplo, transporte—, que podrían poner en riesgo la vida y la salud de los ciudadanos.

- Sistemas de identificación biométrica.

- Formación educativa y profesional, que puede determinar el acceso a la educación y el curso profesional de la vida de una persona —por ejemplo la calificación automatizada de exámenes).

- Empleo, gestión de trabajadores y acceso al autoempleo —por ejemplo, software de selección de CV y contratación automatizada—.

- Servicios públicos y privados esenciales —por ejemplo, sistemas automatizados de prestaciones sociales, sistemas de calificación de créditos por parte de los bancos—.

- Sistemas de cumplimiento de la ley que pueden interferir con los derechos fundamentales de las personas —por ejemplo puntuación de riesgo automatizada para establecer una fianza u otra al detenido—.

- Gestión de la migración y el control de fronteras —verificación de la autenticidad de los documentos de viaje, tramitación de visados—.

- Administración de justicia y procesos democráticos —asistencia en sentencias automatizadas—.

3. Riesgo limitado

Aquí se encontrarían 3 sistemas de IA. El objetivo con estos es proporcionar transparencia, como el etiquetado o la divulgación de que el contenido ha sido manipulado. Los sistemas son:

- Chatbots

- Sistemas de reconocimiento de emociones y categorización biométrica

- Sistemas que generan contenido deepfake o sintético

4. Riesgo mínimo

Estas aplicaciones ya están ampliamente implementadas y constituyen la mayoría de los sistemas de inteligencia artificial con los que interactuamos hoy.

El riesgo mínimo incluye aplicaciones como filtros de spam o videojuegos habilitados para IA. La Comisión propone que estos se regulen principalmente mediante códigos de conducta voluntarios.

¿Cuándo entrará en vigor?

Si bien la industria espera que la Ley se apruebe este año, no hay una fecha límite concreta. La ley está siendo discutida por los parlamentarios y, una vez que lleguen a un terreno común, habrá un diálogo a 3 bandas entre los representantes del Parlamento Europeo, el Consejo de la Unión Europea y la Comisión Europea.

Una vez finalizados los términos, habría un período de gracia de alrededor de dos años para permitir que las partes afectadas cumplan con las regulaciones.

Redactora de Tecnología

Redactora de Tecnología, especializada en inteligencia artificial y ciberseguridad.

Otros artículos interesantes:

Conoce cómo trabajamos en Computerhoy.