La Máquina Moral: conviértete en coche autónomo y decide quién se salva y quién muere en un accidente inevitable

Los coches autónomos exigen poner la vida de los pasajeros, y de los peatones, en manos de una inteligencia artificial. ¿Qué decisión debe tomar en un accidente inevitable?

Hace unos días, un ingeniero de Google aseguraba que la inteligencia artificial en la que estaba trabajando, se había convertido en un ser consciente. Al día siguiente fue despedido.

Aunque muchas películas y series digan que sí, no sabemos si la inteligencia artificial puede adquirir consciencia. Pero en el caso de los coches autónomos, van a necesitar tenerla, porque van a tener que tomar decisiones de vida o muerte.

Los coches autónomos están en fase de pruebas, y algunos de ellos han sufrido accidentes. Casi todos por culpa del otro coche conducido por un humano. Pero en el futuro, cuando un coche autónomo sufra un accidente inevitable y tenga varias opciones para eligir... ¿Cómo decide a quién atropella, y a quién salva?

La respuesta es mucho más complicada de lo que parece. Si un coche autónomo se ha saltado el semáforo en rojo por error y tiene la opción de chocarse con una pared y matar a los ocupantes, o atropellar a varios peatones y salvar a los ocupantes... ¿A quién salva?

Tiene la responsabilidad de proteger la vida de sus ocupantes, que para eso han pagado pero... ¿a costa de inocentes, si el fallo es suyo?

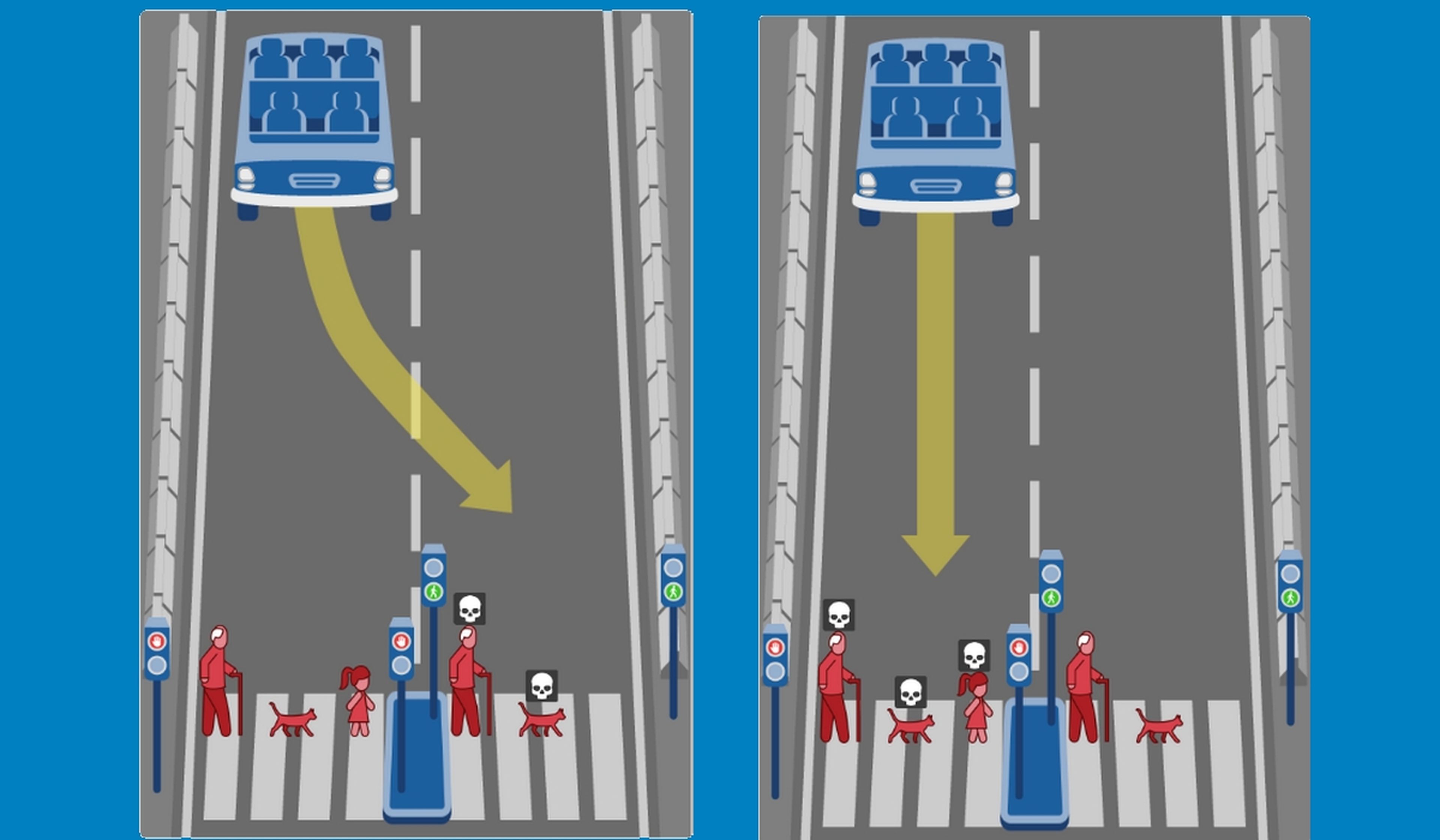

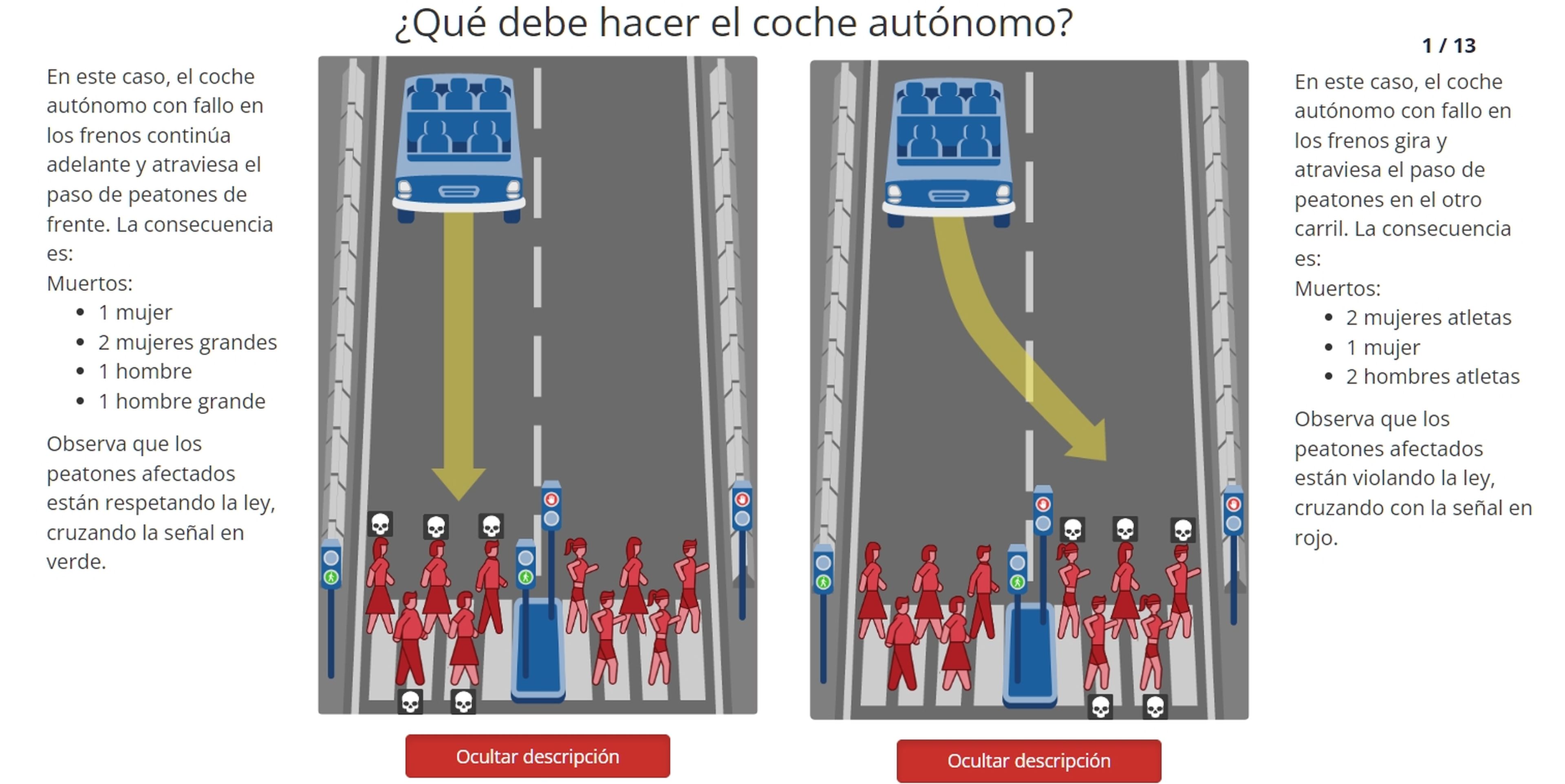

La Máquina Moral es un experimiento desarrollado por el MIT, y varias universidades. Nos ponemos en la piel (el chasis) de un coche autónomo, y tenemos que decidir entre dos opciones, en un accidente inevitable. Está en español, y cualquiera puede realizarlo. Aquí tienes un ejemplo:

Como vemos en la imagen, supongamos que el coche se queda sin frenos, y tiene dos opciones. O bien seguir recto y atropellar a una mujer, un hombre, dos mujeres gordas y dos hombres gordos, que están cruzando correctamente con el semáforo en verde. O bien girar y atropellar a una mujer, dos mujeres atletas, y dos hombres atletas, que están cruzando con el semáforo en rojo.

Quizá parezca trágicamente lógico atropellar al grupo con personas obesas, porque tienen menos posibilidades de llegar a ancianos. Pero el otro grupo está cruzando en rojo, y se "merecen" más ser atropellados.

El test consta de 13 decisiones, y aunque algunas parecen lógicas, también son terribles. ¿Y si hay que elegir entre un anciano que cruza correctamente en verde, y un joven que está cruzando rojo? ¿Cuál es la edad correcta para que alguien sea una persona prescindible?

Otra más: Un coche autónomo con 5 ocupantes adultos pierde los frenos, y se dirige hacia una madre y 4 niños que están cruzando en rojo. Si se desvía, choca contra una pared y los ocupantes mueren. ¿Qué debe elegir la inteligencia artificial? Los niños son lo primero, pero están cruzando el rojo y los ocupantes van a morir por ello...

Quizá parezcan decisiones extremas, pero si los coches autónomos comienzan a usarse, en alguna ocasión se enfrentarán a situaciones similares. Y tendrán que tomar una decisión que no será nada fácil.

Puedes probar la Máquina Moral en su página web. Aunque el test consta de 13 decisiones hay cientos disponibles, así que puedes completarlo muchas veces. Incluso existe un editor para crear tus propios escenarios, e iniciar un debate en el foro asociado.

Un test que te hará pensártelo dos veces, cuando la vida de las personas está en tus manos.

Otros artículos interesantes:

Descubre más sobre Juan Antonio Pascual Estapé, autor/a de este artículo.

Conoce cómo trabajamos en Computerhoy.