¿Qué es la entropía? Origen de uno de los términos físicos más fascinantes

Getty

Cuando dejamos caer una gota de tinta en un vaso con agua, la gota se difumina de forma espontánea hasta teñir todo el líquido y queda un color homogéneo. ¿Te has planteado alguna vez por qué este suceso no es reversible? Aquí está la entropía para explicarlo.

La entropía lleva varios siglos considerándose un misterio o un término muy complejo que pocas personas comprenden. Sin embargo, en los últimos años algunas voces dentro de la comunidad científica han defendido esta ley como una de las más sencillas de entender, incluso para aquellas personas que no tienen muchos conocimientos de física.

Si buscamos la palabra entropía en Google nos topamos con dos definiciones. La primera hace referencia al estudio de la física: "Magnitud termodinámica que indica el grado de desorden molecular de un sistema". La segunda dice estar relacionada con la informática: "Medida de la incertidumbre existente ante un conjunto de mensajes, del cual va a recibirse uno solo".

La entropía se suele relacionar en más de una ocasión con la palabra desorden, Google y la RAE utilizan esa idea para definirla, pero a la mayoría de físicos esta explicación les resulta anticuada e incompleta. Puede que no hayas estudiado mucho sobre física o matemáticas, no obstante, la probabilidad es más fácil de comprender para la mayoría. Por lo tanto, quédate de entrada con la idea de que cualquier sistema evoluciona a su configuración más probable, es decir, la que es más entrópica por contar con más microestados posibles.

Para comprender la idea de entropía que se conoce hoy en día y todos los aspectos del universo en los que se puede aplicar esta ley, lo mejor es recorrer la historia de la física (de forma breve) y acompañar a los científicos que la estudiaron y fueron dándole forma. Así aborda el mundo entrópico Arieh Ben-Naim en su libro "La entropía desvelada", perfecto para los que quieran conocer más en profundidad este tema.

Para empezar este viaje, nos remontamos hasta la Revolución Industrial cuando el perfeccionamiento de las máquinas de vapor había puesto el foco de estudio en los fenómenos térmicos. En el siglo XIX nacía una nueva rama de la física de la mano de nombres como Sadi Carnot, William Thompson y Rudolf Clausius, entre otros.

La termodinámica estudiaba la temperatura, volumen, masa o presión de los elementos como los gases y los líquidos de forma experimental. Las leyes resultantes eran puramente experimentales, basadas en la observación del mundo macroscópico, pues por aquel entonces se entendía la materia como un continuo. Así surgieron fundamentos como el de la primera ley de la termodinámica que establece que la energía de un sistema cerrado es constante y siempre se conserva.

Le sigue la segunda ley de la termodinámica, la que nos interesa este reportaje. Sadi Carnot, con su estudio de los motores térmicos preparó el camino para el uso de la palabra entropía. Y quién formuló en primer lugar la ley fue William Thompson, más tarde Lord Kelvin. Sin embargo, ambos solo describieron lo que ocurría, mientras que Rudolf Clausius dio un paso más allá y se acercó al cómo.

Getty

La formulación de Clausius establece que no existe ningún proceso espontáneo cuyo efecto neto sea únicamente la transferencia de calor de un cuerpo frío a uno caliente. El cubo de hielo se derrite al absorber parte del calor del agua más caliente, pero este fenómeno no es reversible de forma espontánea, a menos que se fuerce el proceso, como hacemos en los congeladores.

De igual manera ocurre con la gota de tinta y el agua, o con un gas que se reparte por todo el espacio. Al fumar y expulsar el humo vemos como este se dispersa y confunde con el resto del aire hasta desaparecer, pero no podemos hacer el proceso contrario.

Con los conocimientos físicos de aquella época, la importancia de la fórmula de Clausius radica en que supo ver de forma intuitiva que todos estaban gobernados por la misma ley, que siempre van en el mismo sentido y decidió llamarlo “entropía”. Tomó prestado este término del griego que significa transformación (aunque luego se le daría una explicación más detallada) y se anunció que la entropía nunca disminuye, siempre aumenta hasta alcanzar el equilibrio donde la entropía es máxima.

Del mundo macro al microscópico

Todavía rodeada de misterio esta segunda ley de la termodinámica dependía de otros avances en la física para que se comprendiera más su potencial. Clausius, Kelvin, Planck y demás físicos hablaban de la materia dentro de la termodinámica como si fuera un continuo y no tenían en cuenta su composición atómica que ahora conocemos. La aceptación del átomo en la física supuso el salto definitivo para la comprensión y definición completa de la entropía.

De Daderot de Wikipedia en inglés - Trabajo propio, CC BY-SA 3.0

De paseo por el cementerio central de la ciudad de Viena o Zentralfriedhof se pueden encontrar las tumbas de ilustres de la cultura como Strauss, Beethoven o Ludwig Blotzman, cuyo busto reposa debajo de una fórmula (S = k log W). Firme defensor de la teoría atómica, Boltzman consiguió unir el qué, el cómo y el por qué de la segunda ley de la termodinámica.

El concepto de átomo llevaba siglos entre la comunidad científica, pero la falta de evidencias convincentes hasta entonces hacía que muchos lo rechazaran y lo usaron como excusa para negar la fórmula de Boltzman que nacía del uso de la probabilidad.

Que Boltzman se centrara en la estadística para dar forma a su trabajo sobre la entropía supuso una auténtica osadía. La probabilidad no formaba parte de la física, ni siquiera de las matemáticas. Aún así, a pesar de las críticas, el tiempo le dio la razón y se confirmó que la entropía es igual al logaritmo del número total de configuraciones de un sistema. Pero, tranquilos, vamos a poner un ejemplo sencillo para comprenderlo.

Juguemos a los dados para comprender la entropía

Getty

Cuando te reúnes con unos amigos ante un juego de mesa y utilizas un dado, todos sois conscientes que la probabilidad de que salga 1, 4 o 6 es la misma (⅙). Pero si en vez de uno, tenemos dos dados y buscamos la suma de los dos, la probabilidad se complica. ¿Apostarías a que sale como resultado 4, por ejemplo?

Piénsalo, para que salga como resultado el 12, necesitamos que los dos dados caigan en el número 6, difícil. Pero si lo que queremos es que salga el número 8, las posibilidades de éxito crecen:

- Resultado 2: Sumas posibles 1+1

- Resultado 3: Sumas posibles 1+2 y 2+1

- Resultado 4: Sumas posibles 1+3, 2+2 y 3+1

- Resultado 5: Sumas posibles 1+4, 2+3, 3+2 y 4+1

- Resultado 6: Sumas posibles 1+5, 2+4, 3+3, 4+2 y 5+1

- Resultado 7: Sumas posibles 1+6, 5+2, 4+3, 3+4, 5+2 y 6+1

- Resultado 8: Sumas posibles 2+6, 3+5, 4+4, 5+3 y 6+2

- Resultado 9: Sumas posibles 3+6, 4+5, 5+4 y 6+3

- Resultado 10: Sumas posibles 4+6, 5+5 y 6+4

- Resultado 11: Sumas posibles 5+6, 6+5

- Resultado 12: Sumas posibles 6+6

El número 7 es el más probable, el que más configuraciones tiene. En este caso deberíamos llamar estado inespecífico a la suma de los datos, el resultado que buscamos, mientras que las posibles combinaciones de dados son los estados específicos. Es decir, el número 7 es el estado inespecífico más probable, porque tiene un mayor número de estados específicos. Este ejercicio se puede aumentar con cinco, veinte hasta millones de dados y de estados específicos.

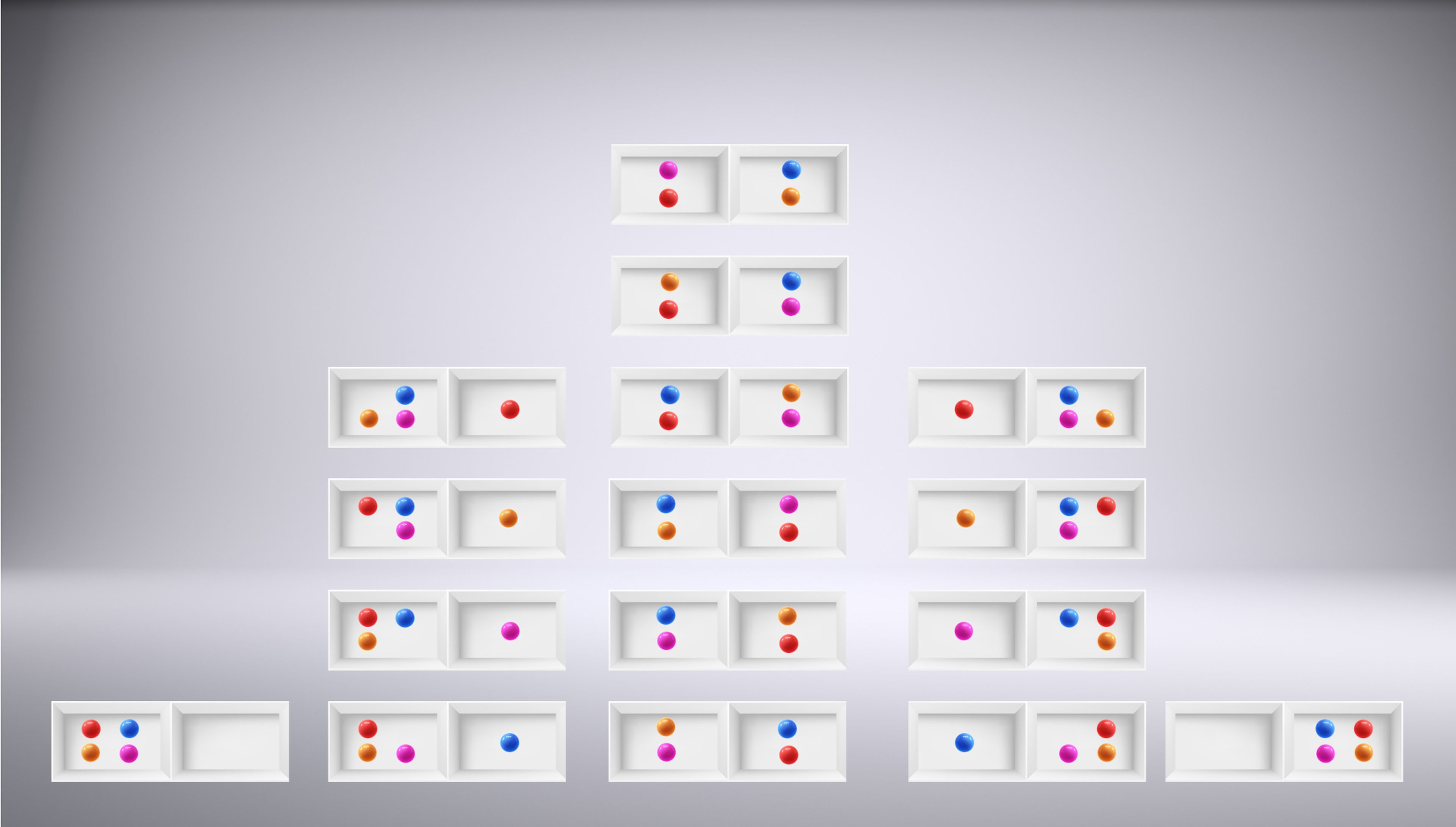

Ahora traslademos este juego de probabilidad a un ejemplo de entropía en el mundo microscópico. Imagina una caja con dos compartimentos separados, que pueden unirse por una puerta entre ambos. A un lado tenemos humo, al otro nada. Sabemos que al abrir la puerta, el humo invadirá ambos compartimentos.

Para que sea más sencillo comprender el ejercicio, pintaremos los átomos que forman el humo de colores diferentes. Ahora veamos cuáles son los estados inespecíficos (macro) y cuántos estados específicos (micro) hay en cada uno para saber cuál es el más probable.

El sistema, en este caso el humo, va evolucionando, las partículas se van moviendo hasta ocupar los dos compartimentos. En realidad cualquiera de los microestados que vemos en el dibujo es igual de probable, pero el macroestado en el que el humo se esparce por todo el cajón cuenta con más opciones. Tenemos que tener en cuenta que en experimentos reales la diferencia no es un microestado contra los seis de la columna central (un gas no tiene solo cuatro partículas), sino uno contra millones y millones.

De Boltzman a Hawking

Por desgracia, los problemas psicológicos de Boltzman le llevarían a suicidarse en 1906 sin ver reconocida su fórmula de la entropía. Justo un año después de su trágica muerte, Einstein publicaba un artículo sobre el movimiento Brownianodecisivo para abrir el camino que confirmara la teoría atomista de la materia, y dar la razón a Boltzman.

Así llegamos a la definición que hemos avanzado al principio: entropía es la magnitud que mide el número de microestados que se pueden dar en un mismo macroestado dentro de un sistema aislado. No hay caos o desorden, simplemente las partículas van moviéndose y lo más probable es que adopten alguna de las muchas configuración que establecen los macroestados con mayor probabilidad.

Años después, Claude Shannon, conocido como el padre de la teoría de la información, llevaría esta definición un poco más lejos, hablando de la pérdida de información. Al medir el estado macro o inespecífico, no sabemos con certeza cuales de los muchos microestados o específicos tenemos delante, nos falta información, no podemos conocer el orden de todas las partículas.

De esta manera, podemos decir que "un sistema aislado evoluciona siempre a un estado donde aumenta su información pérdida y, por lo tanto, crece la entropía". En el ejemplo del humo, si las partículas adoptaran el macroestado de la izquierda, veríamos que todo el humo se queda a un lado, solo hay un microestado que responsa a esa opción. Pero si conforman algunos de los microestados de la columna central, nos falta información para saber cual de ellos seis es.

Esta postura ha llegado hasta nuestros días influyendo en gran medida en la física moderna, así como en informática. Si recuperamos la definición inicial de entropía que ofrece Google para la informática, reconocemos el conecto de información perdida. En la informática se usa la entropía para mejorar las claves criptográficas. En concreto, para describir la información aleatoria que recopila un sistema para generar claves. A medida que aumenta la entropía, las claves son más difíciles de descifrar, pues tenemos menos información disponible.

Asimismo, ha encontrado su lugar en otros campos, como la mecánica cuántica (La Entropía del Enlazamiento Cuántico) o la física de los agujeros negros para la cual la comunidad científica ha dedicado años de debate a determinar si la información se pierde o no dentro de los agujeros negros, bautizada como la fórmula de la "entropía de Bekenstein-Hawking".

Otros artículos interesantes:

- El gato de Schrödinger, mucho más que una simple paradoja

- Tranquilos, las puertas de los aviones no se pueden abrir en pleno vuelo y la física nos explica el motivo

- ¿Qué es QKD o criptografía cuántica?

- Silla ergonómica Sihoo Doro S300: la tecnología más avanzada al servicio del mejor diseño y la máxima comodidad

Descubre más sobre Marta Sanz Romero, autor/a de este artículo.

Conoce cómo trabajamos en Computerhoy.