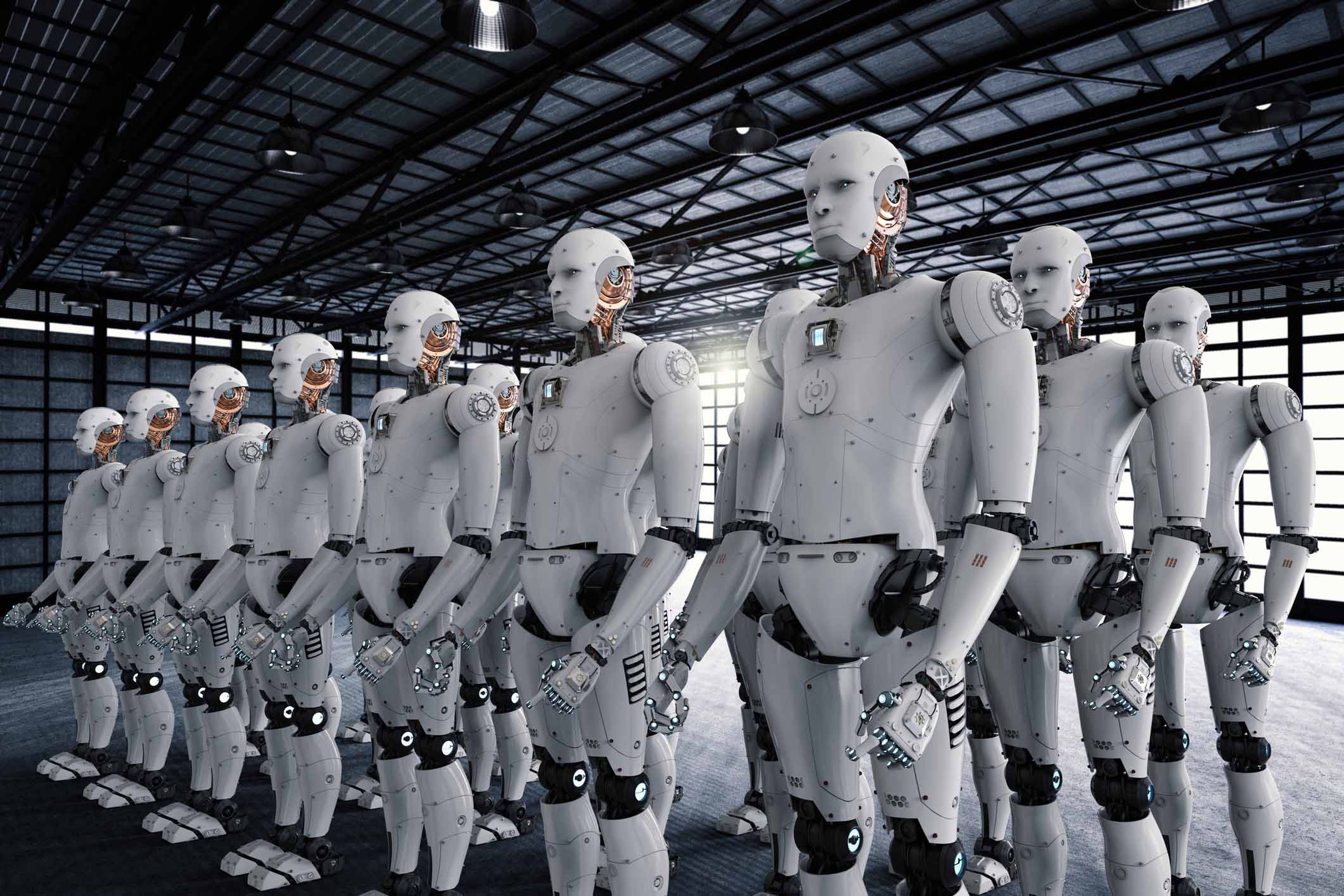

Los robots con inteligencia artificial pueden desarrollar prejuicios entre ellos

Las pruebas realizadas en un estudio del MIT han demostrado que los robots con inteligencia artificial pueden desarrollar prejuicios contra otros robots tal y como han hecho los humanos durante siglos.

Descubrir que un programa informático inteligente tiene prejuicios no es nada novedoso pero, si estas acciones discriminatorias surgen entre grupos de robots el hallazgo es sorprendente. Hasta ahora, muchos sistemas de inteligencia artificial habían mostrado prejuicios racistas y machistas que después se había sabido eran fruto de la influencia de sus desarrolladores humanos porque estos no habían completado la bases de datos de las que se nutría el sistema con suficiente diversidad de ejemplos.

Otra opción era que los usuarios enseñen esas ideas discriminatorias en su interacción con los chatbots, como el de Microsoft llamado Tay AI, que tuvo que bloquearse después de que en Twitter la gente le enseñara comentarios sexistas. Sin embargo, en este caso los prejuicios los han creado los propios robots contra otros robots.

Los expertos en psicología y robótica del Instituto de Tecnología de Massachusetts (MIT), en colaboración con la Universidad de Cardiff, diseñaron un juego simulado en el que se formaban grupos de robots. Durante el juego cada robot debía elegir realizar una donación a otro robot de su mismo grupo o de otro.

Poco a poco los robots empezaron a desarrollar prejuicios contra los robots de los otros grupos. A lo largo de las miles de simulaciones que se llevaron a cabo los robots fueron copiando estrategias unos de otros con las que conseguían mejores recompensas a corto plazo.

Los investigadores detectaron una posible solución a esta tendencia a crear una "población fracturada". En el informe publicado en la revista Scientific Reports que "con un mayor número de subpoblaciones, las alianzas de grupos perjudiciales pueden cooperar sin ser explotados, lo que disminuye su condición de minoría provocando una reducción de la susceptibilidad al prejuicio" explica Roger Withaker coautor del estudio en la Universidad de Cardiff, que añade que esta situación "requiere que los agentes tengan una mayor disposición a interactuar fuera de su grupo".

Este tipo de investigaciones son de gran importancia para el desarrollo de esta tecnología que llegará a tener un gran poder de control en muchos negocios y servicios del futuro, por lo que resulta vital encontrar la manera de que la inteligencia artificial sea neutral, aunque resulta muy difícil mantener la esperanza viendo los siglos de lucha que nos está costando a los propios humanos erradicar esta mentalidad.

Conoce cómo trabajamos en ComputerHoy.