¿Qué es la IA explicable o XAI y cómo pondrá fin al gran problema de esta tecnología?

Teniendo en cuenta lo rápido que avanza la inteligencia artificial, existe un concepto con nombre IA explicable que está ganando cada vez mayor fuerza y todo se centra en la transparencia.

Ya no hay duda de que la inteligencia artificial está cambiando el mundo, impactando en todo tipo de industrias y aspectos de la vida. Desde la atención sanitaria hasta ahora la forma de interactuar con los móviles, los modelos de IA son cada vez más avanzados, dejando a todos con la boca abierta.

Sin embargo, aquí hay un gran problema y es que esta complejidad no viene sola y existe una gran falta de comprensión sobre cómo estos modelos toman decisiones. Esto se conoce como el problema de la "caja negra" de la IA, como si de un avión se tratase.

En este contexto hace referencia a una herramienta o modelo, como puede ser GPT-4 de OpenAI, cuyo funcionamiento interno no es transparente o comprensible para aquellos que están fuera, es decir, los usuarios o expertos que no han participado en su desarrollo.

Tú, como usuario, simplemente lo usas en ChatGPT, como es este caso, pero realmente desconoces cómo funciona, por qué es capaz de crear una imagen o hacerte un resumen muy preciso y precisamente por este motivo entra en juego la inteligencia artificial explicable, también conocida como XAI.

- ¿Qué es la IA explicable o XAI?

- La IA explicable se basa en cuatro principios

- ¿Cómo funciona realmente?

- La IA cada vez está más regulada y necesita una gran responsabilidad por parte de las empresas

¿Qué es la IA explicable o XAI?

La inteligencia artificial explicable, IA explicable, es un conjunto de técnicas y métodos que permiten entender cómo y por qué un modelo de IA toma ciertas decisiones. Su objetivo es hacer que las decisiones de la IA sean transparentes y comprensibles para los usuarios.

Imagina que usas un sistema de IA o un chatbot para obtener una aprobación de crédito en un banco. El modelo analiza tus datos, como tus ingresos, historial, crediticio, etc. y decide si aprobar o rechazar tu solicitud.

Con la IA explicable, no solo recibes la decisión de aprobado o rechazado, sino también una explicación clara de por qué se tomó esa decisión. Por ejemplo, "Tu crédito fue aprobado porque tienes un ingreso mensual estable y un historial de pagos puntuales". Esto permite a los usuarios entender las razones detrás de las decisiones de la IA y confiar más en el sistema.

En pocas palabras y como ves, la IA explicable trata de responder a la pregunta: "¿Por qué la IA tomó esta decisión?". Volviendo a ChatGPT, que seguramente sea más conocido para muchos, aunque obtienes respuestas muy útiles, no sabes exactamente cómo funciona o por qué responde de esa forma.

La IA explicable aquí intervendría para desglosar ese proceso y darte una explicación clara. Por ejemplo, si preguntas cómo se crea un resumen, la IA explicable podría mostrarte qué datos y algoritmos se usaron y cómo se procesaron para llegar a la respuesta.

La IA explicable se basa en cuatro principios

El Instituto Nacional de Estándares y Tecnología (NIST) ha definido cuatro principios clave para la IA explicable:

- Explicación: los sistemas de IA deben poder explicar sus resultados y dar evidencia de respaldo.

- Significativo: las explicaciones deben ser comprensibles y relevantes para los usuarios.

- Precisión en la explicación: estas deben explicar correctamente el proceso y el razonamiento detrás de las decisiones del modelo.

- Límites del conocimiento: deben operar dentro de sus límites de conocimiento y manifestar estos límites para evitar engaños y que al final los usuarios confíen en ella.

¿Cómo funciona realmente?

Existen dos enfoques principales para la IA explicable: los modelos autointerpretables y las explicaciones post-hoc.

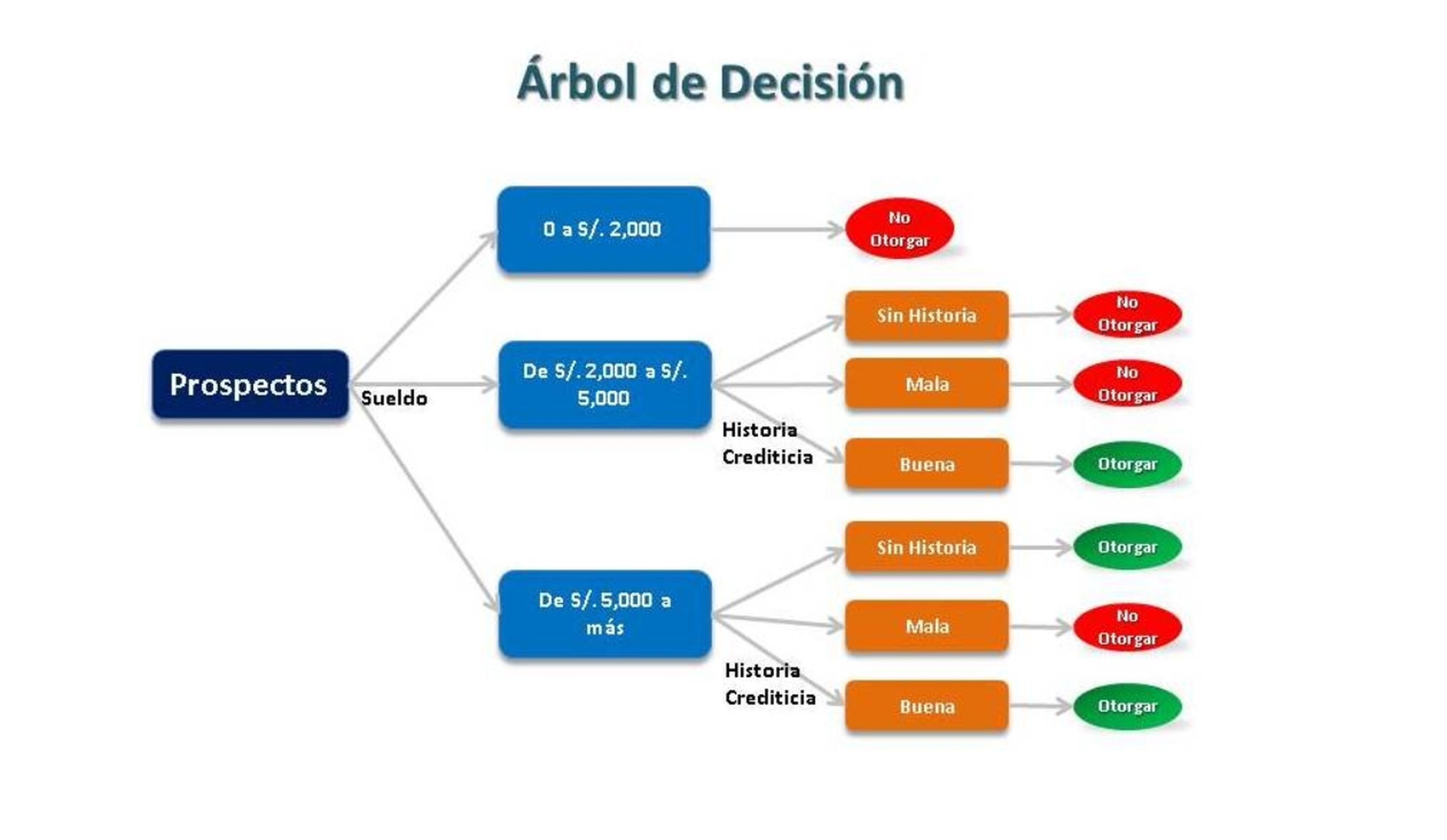

1. Modelos autointerpretables: estos modelos son, en sí mismos, explicaciones. Ejemplos comunes incluyen los árboles de decisión y los modelos de regresión, que pueden ser leídos e interpretados directamente por humanos. En estos casos, la estructura del modelo da una visión clara de cómo se toman las decisiones.

En los árboles de decisión, cada rama representa una decisión basada en una característica del dato de entrada, y cada hoja del árbol es una predicción o resultado final. En los modelos de regresión se habla básicamente de una línea que indica como paso contribuye a la decisión final.

2. Explicaciones Post-Hoc: aquí se pueden encontrar hasta tres diferentes tipos.

- LIME: simplifica un modelo muy complicado alrededor de una predicción específica para mostrar qué características fueron importantes para esa decisión.

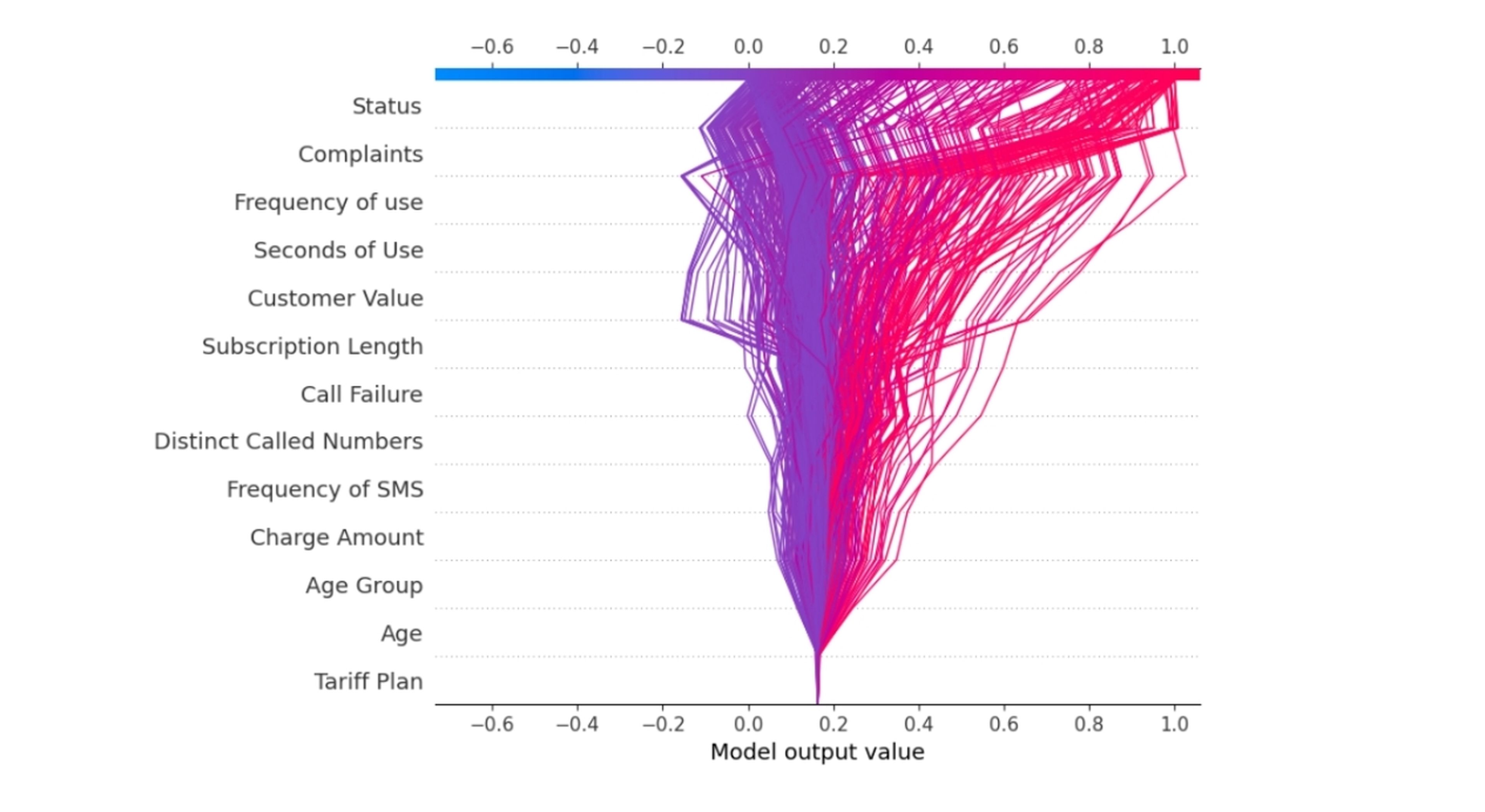

- SHAP: asigna un valor a cada característica para que veas cuánto influyó en la decisión final, usando una base matemática.

- Análisis de sensibilidad: muestra qué entradas son claves al ver cómo pequeños cambios en los datos de entrada afectan la salida del modelo.

Por ejemplo, volviendo al tema de la aprobación de un crédito del banco, LIME te muestra que el historial crediticio y los ingresos altos fueron la clave para aprobar tu solicitud. SHAP te indicaría cuánto contribuyó cada característica a la decisión, como que tu historial crediticio fue de un 60%, los ingresos un 30% y la edad un 10%.

datacamp.com

La IA cada vez está más regulada y necesita una gran responsabilidad por parte de las empresas

La inteligencia artificial al final se está regulando cada vez más debido a cómo está impactando en diversos aspectos de la vida. Estas regulaciones, al menos en un principio, buscan asegurar que la IA se utilice de manera transparente, ética y justa.

Sin ir más lejos, en la Unión Europea, en el Reglamento General de Protección de Datos (GDPR) se habla de estos temas, pero es cierto que la propuesta de Ley de Inteligencia Artificial ya busca directamente regular la IA según el riesgo.

Aquí se encuentra la necesidad de equilibrar derechos fundamentales como la privacidad de los datos y que todos los usuarios tengan acceso a sus beneficios con el objetivo de evitar que miles de empresas se lancen sin reparo a innovar en IA, dando lugar a herramientas o sistemas fallidos.

Por otro lado, en Estados Unidos, el presidente Joe Biden y su administración crearon una Declaración de Derechos de la IA, que incluye directrices para proteger los datos personales y limitar la vigilancia, entre otras cosas. Y la Comisión Federal de Comercio ha estado monitoreando cómo las empresas recopilan datos y utilizan algoritmos de inteligencia artificial.

De cara al futuro, la IA explicable podría ayudar a evitar cualquier riesgo legal, de cumplimiento y de seguridad con un modelo de IA en particular.

Conoce cómo trabajamos en ComputerHoy.

Etiquetas: Inteligencia artificial, Vídeo, Software, Qué es