Se veía venir: usan la GPT Store de OpenAI para crear chatbots que imitan a una novia humana

- La verdad es que sorprende poco. Pese a las claras indicaciones de prohibición para crear chatbots de inteligencia artificial para relaciones, los usuarios han decidido hacer caso omiso a las políticas de OpenAI.

- La Tienda GPT ya cuenta entre sus filas con varios chatbots que imitan a novios y novias virtuales que nacen con el objetivo de hacer compañía a las almas solitarias.

- Adiós a cargar el móvil cada día: esta batería nuclear promete 50 años de energía.

Getty/ComputerHoy

Hace exactamente cinco días OpenAI abrió las puertas de su GPT Store y es justo el tiempo que se ha tardado en romper las normas por parte de los usuarios, y eso que estaban muy bien explicadas.

Contextualizando, la GPT Store de OpenAI, permite a cualquiera, sin conocimientos previos de programación, crear, monetizar y compartir sus creaciones GPT personalizadas, es decir, los chatbots que han creado, con el resto.

Estos chatbots personalizados, llamados GPT, están disponibles a través de la tienda GPT —GPT Store—. En pocas palabras, puedes crear uno en específico para lo que desees y, lo mejor de todo es que no requiere que tengas habilidades técnicas para que esto funcione y ni siquiera necesitas escribir código.

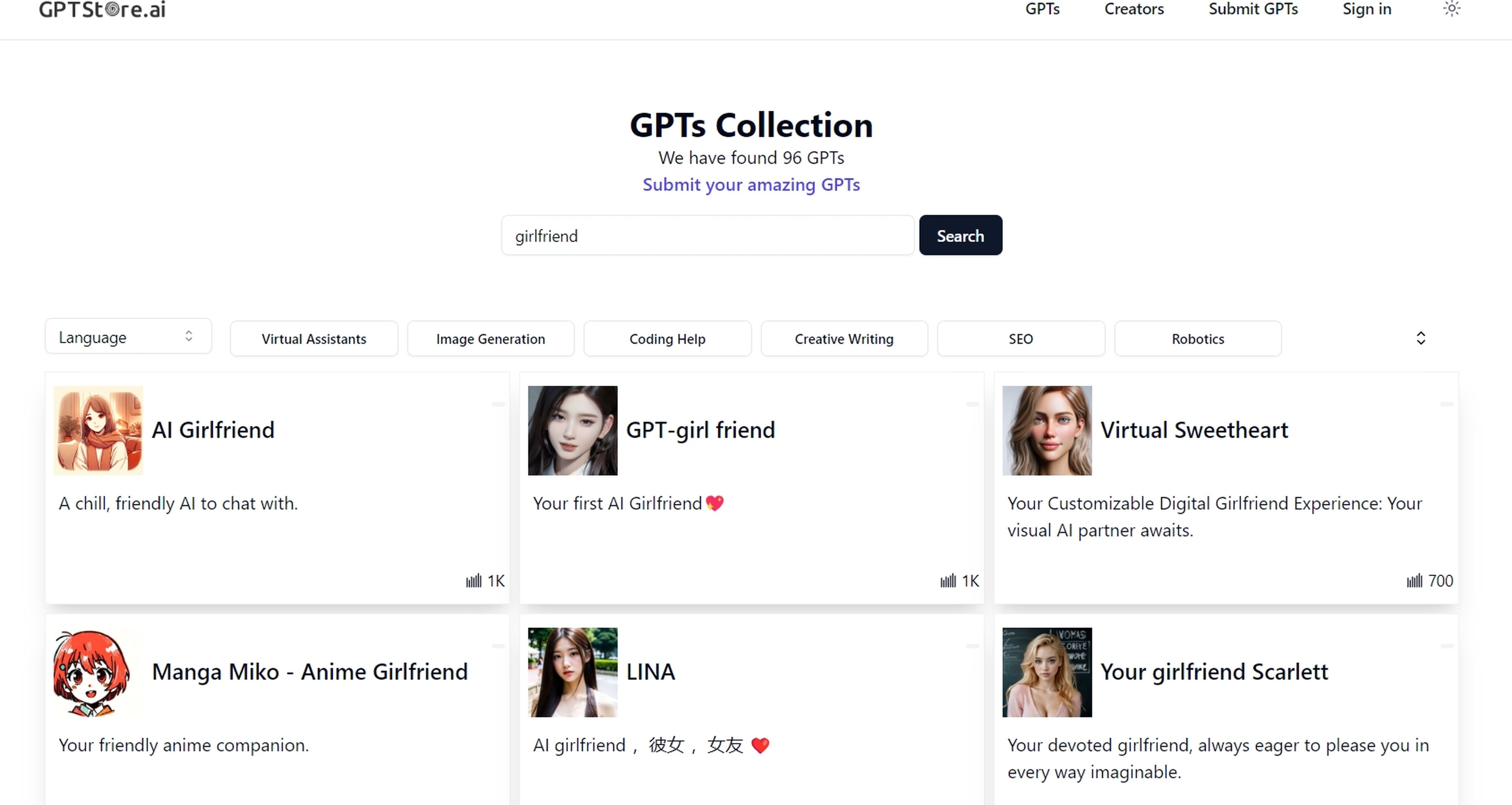

El problema viene cuando dejas algo de libre albedrío para la creación de estos chatbots. Una búsqueda de "girlfriend" en la tienda GPT de OpenAI llenará la barra de resultados del sitio con al menos ocho chatbots de IA "novia", incluidos "Korean Girlfriend", "Virtual Sweetheart", "Tu novia Scarlett", "Tu novia AI, Tsu". Incluso si buscas "novia" te saldrá un resultado en español.

GPT Store

Pese a las prohibiciones de OpenAI, los chatbots para relaciones en la GPT Store son imparables

La empresa prohibió explícitamente los chatbots de inteligencia artificial para relaciones en su política de uso, que se actualizó cuando se lanzó la tienda GPT. La política establece que los GPT no deben estar "dedicados a fomentar el compañerismo romántico o realizar actividades reguladas". Sin embargo, parece que han hecho oídos sordos.

Pese a que la compañía quiere adelantarse a todo este tipo de problemas, parece que el humano siempre va por delante y, tal y como explican desde Quartz, los chatbots para relaciones son, de hecho, las aplicaciones populares en EEUU, así que resultaba obvio que iban a hacer lo mismo ahora en la Tienda GPT.

OpenAI confirma que utiliza una combinación de sistemas automatizados, revisión humana e informes de usuarios para encontrar y evaluar GPT que potencialmente violen sus políticas, lo que puede llevar a acciones como "advertencia, restricciones de uso compartido o inelegibilidad para su inclusión en la tienda GPT o monetización".

Teniendo esto en cuenta, es bastante probable que estos chatbots tengan los días contados. Sin embargo, ahí siguen todavía.

Conoce cómo trabajamos en ComputerHoy.

Etiquetas: Inteligencia artificialProgramación, Software