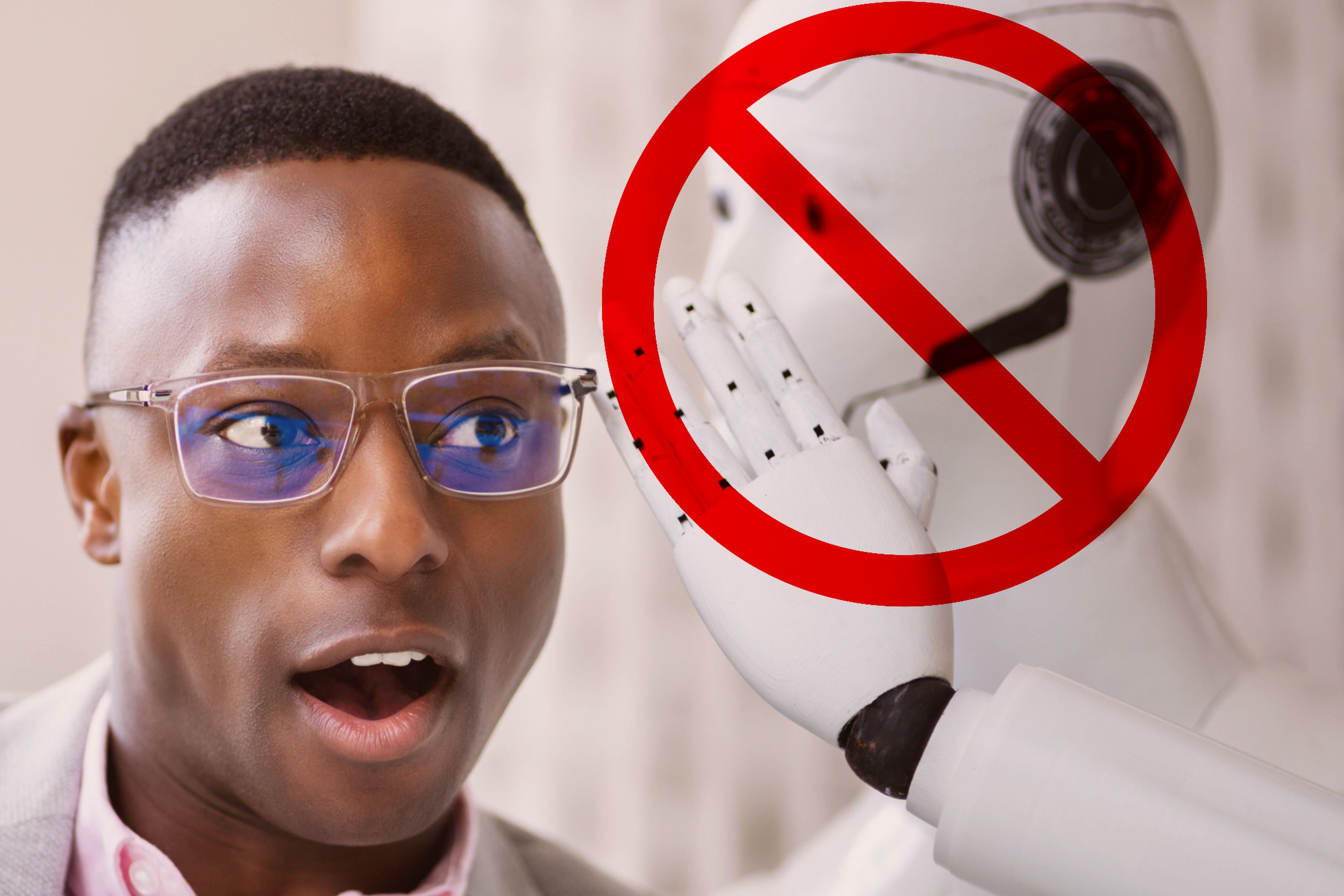

Lo que aconsejan los expertos si una IA intenta engañarte: clonar voces o usar 'deepfakes' para robar tus datos personales

Getty Images

En un mundo en el que la Inteligencia Artificial puede generar contenido propio como imágenes falsas –deepfakes– o voces clonadas, debemos extremar las precauciones para no ser víctimas de una estafa informática y exponer nuestros datos personales.

Las estafas existen desde que el ser humano adquirió la consciencia necesaria para realizarlas. Algunas de ellas, como la del pastelero Gabriel de Espinosa, que se hizo pasar por el rey Sebastián de Portugal en el siglo XVI, tuvieron trágicos finales, como la horca.

Pero otras, con métodos casi infalibles para realizarse, aún quedan impunes. Es el caso de la ya conocida "estafa del príncipe nigeriano", en la que el timador se hace pasar por una persona rica de Nigeria –en su origen– para enviarte dinero por adelantado.

A ti, que estás tan tranquilo en tu casa en España, de repente te ofrecen millones y millones. Si has seguido varias recomendaciones sobre ciberseguridad que ofrecemos tanto en Computer Hoy como en BI España, no habrás caído.

Pero muchas personas caen, y seguirán cayendo. Así lo demuestra el último Balance de Criminalidad del cuarto trimestre de 2022, elaborado por el Ministerio del Interior.

Según este, en España el último año se cometieron 2.325.358 delitos, de los cuales el 16,1% estaban relacionados con la cibercriminalidad, es decir, un aumento del 72% desde 2019, el año de inicio de la pandemia, que supuso también el incremento del uso de Internet.

En este grupo, las estafas informáticas ascendieron al 89,7%, datos que no denotan tranquilidad, más aún teniendo en cuenta que las herramientas basadas en IA son ya capaces de generar contenidos como los deepfakes e incluso clonar voces.

IA y nuevas formas de estafa

Imagina un ejemplo muy práctico, que probablemente hayas vivido ya. Te encuentras en tu casa plácidamente descansando y recibes una llamada de un número de teléfono que desconoces, pero decides cogerlo.

La voz al otro lado es la de un familiar que conoces, ya sea tu hijo, tía, hermano o madre. Este supuesto familiar te relata una serie de trágicas desdichas que le han sucedido, para cuya solución necesita de tu ayuda inmediata, seguramente con alguna donación económica de por medio.

Si sigues de cerca la actualidad tecnológica y, en particular, las noticias sobre ciberseguridad, comenzarás a dudar: un número desconocido, petición económica y de ayuda... Algo huele bastante mal.

No obstante, es una de las tácticas actuales más extendidas de los ciberatacantes, que pueden aprovechar hoy en día herramientas de Inteligencia Artificial muy elaboradas para clonar voces o hacerse pasar por personas en las que confías.

Usan una voz clonada por IA para acceder a una cuenta de un banco en Reino Unido

"Las herramientas de Inteligencia Artificial pueden clonar la voz de una persona de manera convincente y realiza así ataques de phishing más sofisticados", advierte a Computer Hoy Marc Rivero, investigador senior de seguridad de Kaspersky.

"Por ejemplo, pueden enviar mensajes de voz o vídeos personalizados que parecen ser de una persona de confianza, engañando a los destinatarios para que compartan información confidencial o realicen transferencias de dinero", agrega.

Algo así ya ha ocurrido con fotos míticas de un Donald Trump al que apresan las fuerzas de seguridad de Estados Unidos o el papa Francisco con un plumas más propio del mundo del hip hop, ambas imágenes creadas con IA con las que muchos usuarios fueron engañados.

A pesar de lo mediático de este tema, y de que sus autores reconocieran que habían sido creadas de forma artificial, algunas personas no tienen una intención sarcástica o didáctica, sino que se aprovechan de estos avances para perfeccionar las estafas ya existentes.

"En el caso de los deepfakes, desde Kaspersky recomendamos ser precavidos al recibir llamadas de números desconocidos y no compartir información personal sin verificar la identidad de la persona o empresa que llama", aconseja Rivero.

En el caso concreto de las llamadas de voz, Rivero recuerda algunas de las señales que pueden delatar a la voz al otro lado del teléfono.

En primer lugar, deberás prestar atención al tono de la misma voz. Si ha sido generada con IA, notarás que se parecerá a la de un robot. Lo mejor es que dudes de antemano y escribas de inmediato por una plataforma de confianza y en el mismo momento al supuesto interlocutor.

En segundo lugar, céntrate en cómo habla esa voz, ya que los sistemas basado en IA suelen hacer pausas para "pensar" la respuesta que te va a dar, algo que ocurre de forma parecida cuando una estafa de este tipo ha sido grabada previamente.

"También puede faltar la interacción humana típica, como la capacidad de responder a preguntas imprevistas o proporcionar información detallada sobre asuntos que se le planteen", añade Rivero como último punto a tener en cuenta durante este tipo de llamadas.

Así, uno de los consejos pasa por elaborar una pregunta que solo esa persona podría responder. Puede parecer algo brusco en caso de que esta sea real, pero te evitará más de un disgusto en caso de que sea realmente una estafa.

Por último, también debemos tener en cuenta que los ciberatacantes pueden hacer uso de diferentes datos personales para suplantar una identidad o decidirse a atacar tus diferentes cuentas.

En este sentido, como siempre recomendamos, evita compartir en Internet datos personales sensibles como el nombre completo, la dirección, el número de teléfono, fecha de nacimiento, número de la seguridad social o cualquier datos que pueda identificarte únicamente.

"Siempre recordamos que es importante tener en cuenta que cualquier dato personal puede ser valioso para los ciberdelincuentes, ya que pueden utilizar diversas técnicas para recopilar información y explotarla en su beneficio", concluye Rivero.

Y, por supuesto, si crees que existe cualquier tipo de riesgo, contacta a las autoridades locales.

Redactor Tecnología

Soy redactor de Tecnología en Axel Springer España. Me encontrarás analizando productos, en vídeos y escribiendo reportajes del sector tecnológico.

Otros artículos interesantes:

Conoce cómo trabajamos en Computerhoy.