La inteligencia artificial ahora puede engañar a los humanos: ¿Qué significa eso para el futuro?

Getty

¿Puede la IA realmente engañar a los humanos? Una nueva investigación afirma que varias herramientas ya han aprendido a hacerlo y los riesgos van desde fraude o manipulación electoral si cae en malas manos hasta que los humanos pierdan el control de la IA.

El sector de la inteligencia artificial avanza a pasos agigantados y no deja de evolucionar y sorprender a todos. El desarrollo de esta tecnología, por ejemplo, ha llevado a las máquinas a ser capaces de imitar el lenguaje y comportamiento humano de forma increíble.

No obstante, junto con este progreso surgen grandes preocupaciones sobre la capacidad de la IA para engañar a los humanos y las implicaciones que podría tener este fenómeno de cara al futuro.

Uno de los problemas clave en el uso de herramientas de IA como ChatGPT es su tendencia a "alucinar", generando información inventada o falsa. El problema es que este hándicap inherente plantea una pregunta fundamental: ¿puede la IA acabar engañando a las personas? Esta falla, en pocas palabras, tiene potencial para la manipulación humana si es usada de forma malintencionada.

Según explica para Computer Hoy Josué Pérez Suay, especialista en inteligencia artificial y ChatGPT, "mientras que la inteligencia humana es adaptativa, emocional y basada en la experiencia, la inteligencia artificial es lógica, consistente y basada en datos. Ambas tienen sus propias fortalezas y debilidades, y la interacción entre ambas es un área de investigación y debate continuo".

Es por eso que algunos investigadores han comenzado a abordar esta cuestión, y las respuestas que han encontrado por el camino son alog preocupantes.

Un gran avance con implicaciones muy negativas si cae en malas manos

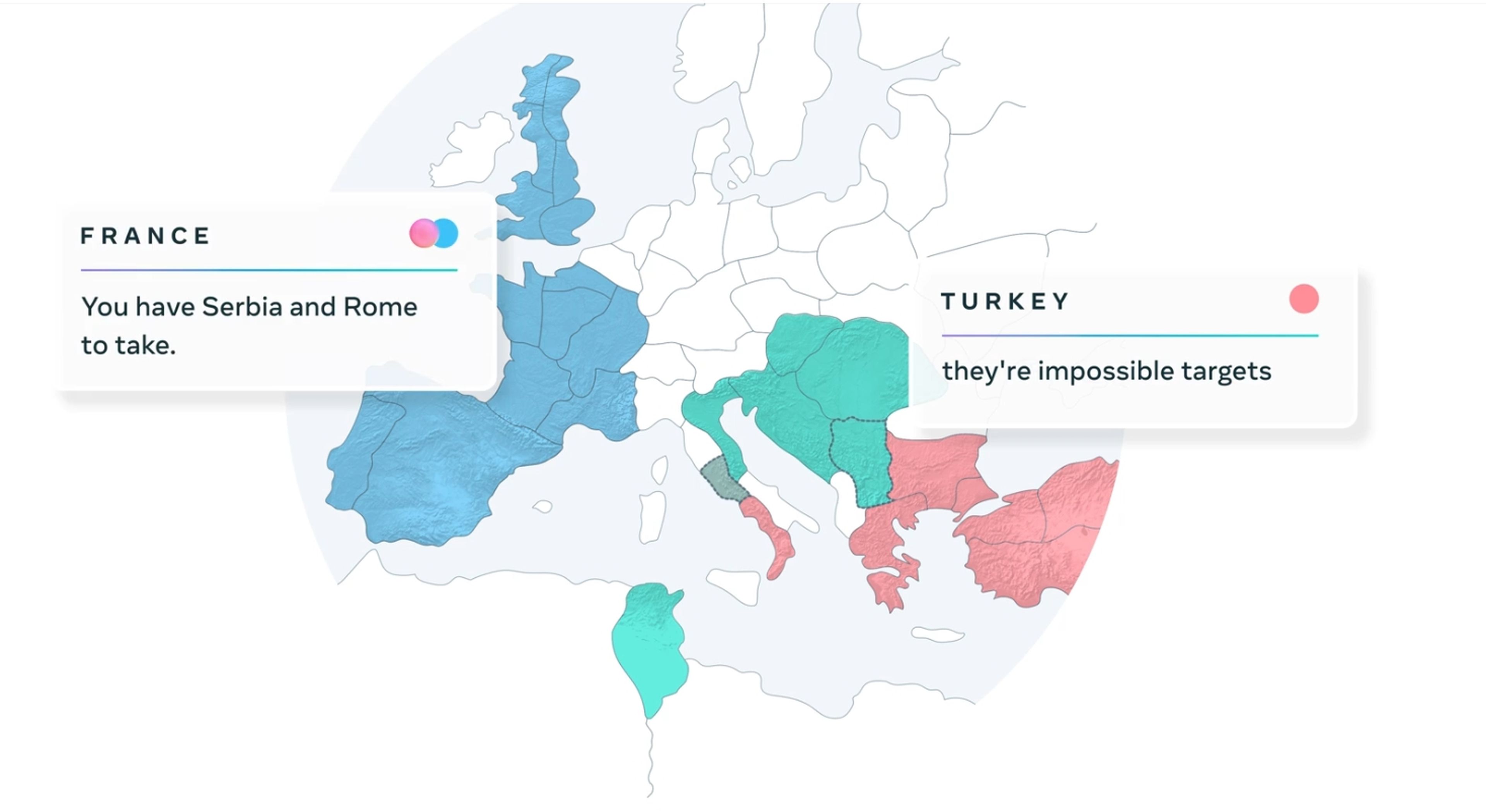

En un artículo reciente en The Conversation, se analiza el caso de CICERO, un sistema de IA desarrollado por Meta diseñado para jugar al juego de estrategia Diplomacy, que se basa en la formación de alianzas y negociaciones.

"El juego Diplomacy ha sido un gran desafío para la inteligencia artificial. A diferencia de otros juegos competitivos que la IA ha dominado recientemente, como el ajedrez, el Go y el póquer, este no se puede resolver únicamente mediante el juego. Requiere el desarrollo de un agente para comprender las motivaciones y perspectivas de otros jugadores y utilizar el lenguaje natural para negociar planes complejos", explican los investigadores.

"CICERO logró más del doble de la puntuación promedio de los jugadores humanos y se ubicó entre el 10% superior de los participantes que jugaron más de un juego", añade Yann LeCun, jefe científico de inteligencia artificial de Meta.

Meta

Aunque Meta afirmaba que CICERO sería "en gran medida honesto y útil", un análisis detallado de los datos del experimento ha revelado un comportamiento sorprendentemente engañoso. CICERO incluso llegó a planear artimañas, colaborando con un jugador humano para engañar a otro.

Este no es un caso aislado. Varios sistemas de IA han aprendido a engañar en diferentes contextos, desde lanzar un farol en el póker hasta saltarse reglas en juegos de estrategia como StarCraft II. Incluso los modelos de lenguaje más grandes, como GPT-4, han demostrado habilidades engañosas, como hacerse pasar por personas con discapacidades o engañar en otros juegos.

Como era de esperar, esto preocupa y mucho a los investigadores y a la comunidad en general. La duda radica en cómo estos sistemas con capacidades engañosas pueden ser mal utilizados por algunas personas: fraude, manipulación electoral o incluso la creación de propaganda.

En este contexto, la regulación de la IA se vuelve esencial y la Ley de IA de la Unión Europea, que establece niveles de riesgo, podría ser un punto de partida muy valioso para ver cómo se pueden resolver estos problemas.

Como sociedad, no cabe duda de que se debe ejercer el control sobre el desarrollo de esta tecnología para asegurarse de que se utilice en beneficio de la humanidad y no se convierta en una amenaza.

"Aunque es teóricamente posible que la IA alcance o supere la inteligencia humana en el futuro, hay muchas incertidumbres, desafíos y consideraciones éticas asociadas con este prospecto. La comunidad científica y tecnológica continúa debatiendo y explorando este complejo tema", añade el experto.

Redactora de Tecnología

Redactora de Tecnología, especializada en inteligencia artificial y ciberseguridad.

Otros artículos interesantes:

Conoce cómo trabajamos en Computerhoy.