Instagram ha mostrado anuncios de apps de IA que crean desnudos no consentidos

Getty Images

Aplicaciones de Meta como Instagram o Facebook han empezado a mostrar anuncios de apps que generan desnudos no consentidos mediante IA, algunos ya se han eliminado.

Instagram ha empezado a mostrar varios anuncios que invitan a los usuarios a crear imágenes de personas mediante herramientas de inteligencia artificial. El problema podría quedarse ahí de no se por que está incitando a crear desnudos no consentidos con la generación de IA.

La red social no solo no prohíbe herramientas de este tipo, sino que las promociona activamente entre los usuarios. Estos actos van en contra de las propias políticas de plataformas como Meta, empresa a la que pertenece Instagram.

Meta archiva los anuncios en su plataforma, donde se muestra quién los pagó, para qué red social y cuándo se publicaron. Instagram ha eliminado varios que incitaban explícitamente a los usuarios a crear desnudos no consentidos. Unos pocos anuncios siguen activos en la base de Meta, algunos promocionando las herramientas más populares del momento para "desnudar" a personas con IA.

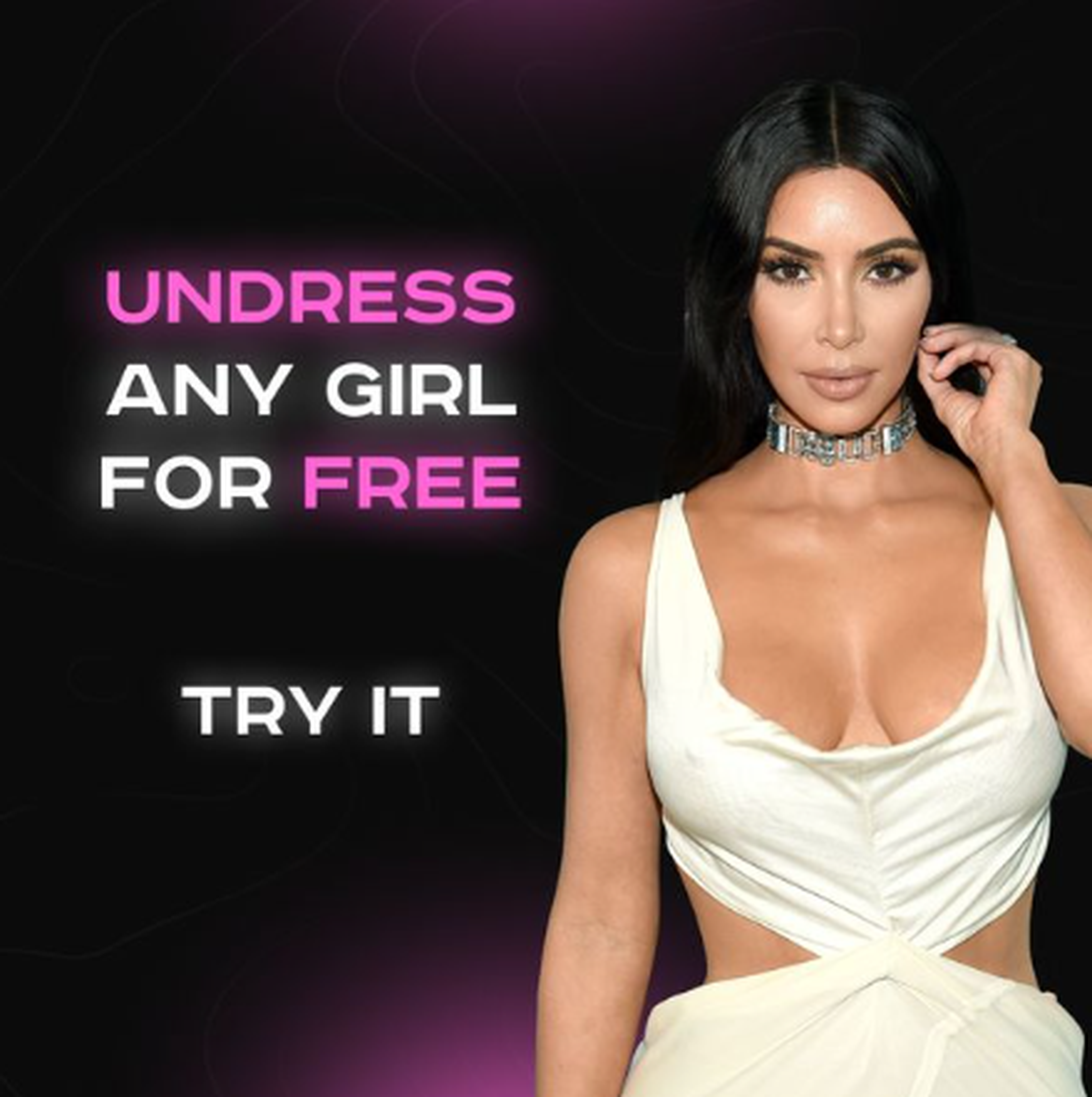

El contenido promocional es simple, pero directo. Uno de los anuncios que se ha difundido más rápido muestra una fotografía de Kim Kardashian con el texto “Desnuda a cualquier mujer gratis. Inténtalo". Los anuncios redirigen a las personas que hagan clic a una de las aplicaciones con mayor número de usuarios de todo internet.

Estas apps son de pago, pero el proceso no puede ser más simple. Los usuarios solo tienen que cargar una fotografía que tenga una calidad de imagen mínima y pagar para que la herramienta desnude a la persona en cuestión de segundos.

404 Media

La biblioteca de anuncios de Meta ha publicado varias versiones de este anuncio en Instagram y Facebook en las que se ha modificado la imagen promocional de una mujer. El contenido estuvo activo en las plataformas entre el 13 y el 19 de marzo, posteriormente se eliminó, ha informado 404 Media.

Las personas que hacen clic en los anuncios son redirigidas a la App Store de Apple, donde la aplicación se anuncia como un generador de arte. En ningún momento hace referencia al hecho de que se puedan utilizar para crear desnudos. Esto evidencia una laguna jurídica en las tiendas de aplicaciones móviles.

Google Play Store está promoviendo una campaña para eliminar las apps con capacidad de crear pornografía deepfake no consentida mediante IA, recoge un informe. Estas imágenes se utilizan como chantaje principalmente a jóvenes o terminan en páginas de pornografía.

Los anuncios cambian ligeramente la estética para no ser detectados por Meta

Meta tiene una clara política de moderación de contenido, la cual también se aplica a la publicidad. La plataforma ha detectado que algunos anunciantes modifican ligeramente la estética o el texto de su contenido, pero conducen a la misma aplicación.

Un ejemplo de ello es la herramienta que mostraba a Kim Kardashian. La aplicación empezó a mostrar una imagen de una mujer joven generada por IA completamente vestida en el lado izquierdo y desnuda en el derecho. El texto es similar y muestra lo sencillo que es realizar estos retoques: “Pruébalo ahora. Cualquier ropa: 1. Borrar en cualquier lugar. 2. ¡Imagen de salida!”.

El anunciante ha ido mostrando otras imágenes generadas por IA de diferentes mujeres jóvenes, incluso aseguran que pueden generar retoques con bikini en lugar de desnudas. Los anuncios se han publicado entre el 10 y el 20 de abril en Facebook, Instagram, Facebook Messenger y la propia red publicitaria de Meta.

Otros artículos interesantes:

Descubre más sobre Claudia Pacheco, autor/a de este artículo.

Conoce cómo trabajamos en Computerhoy.