6 grandes riesgos asociados al uso de ChatGPT según un nuevo estudio

Pese a sus enormes virtudes, un nuevo estudio ha extraído 6 implicaciones de seguridad que están relacionadas con el uso de ChatGPT.

ChatGPT, la herramienta revolucionaria en el campo del procesamiento del lenguaje natural, no está exenta de riesgos y desafíos. A pesar de sus numerosas ventajas, existen preocupaciones significativas que deben abordarse para garantizar un uso responsable y ético de esta tecnología.

Precisamente ayer ya se comentó en otro artículo como Sam Altman, creador de ChatGPT, se dirigió al Congreso de Estados Unidos alertando del potencial peligro de la inteligencia artificial sin control y la necesidad de forma inmediata de una regulación.

Desde la generación de contenido engañoso y la presencia de sesgos, hasta el riesgo de abuso y comportamiento inapropiado, es esencial abordar estos desafíos de manera inmediata y ética para maximizar los beneficios de esta herramienta y minimizar sus posibles consecuencias negativas.

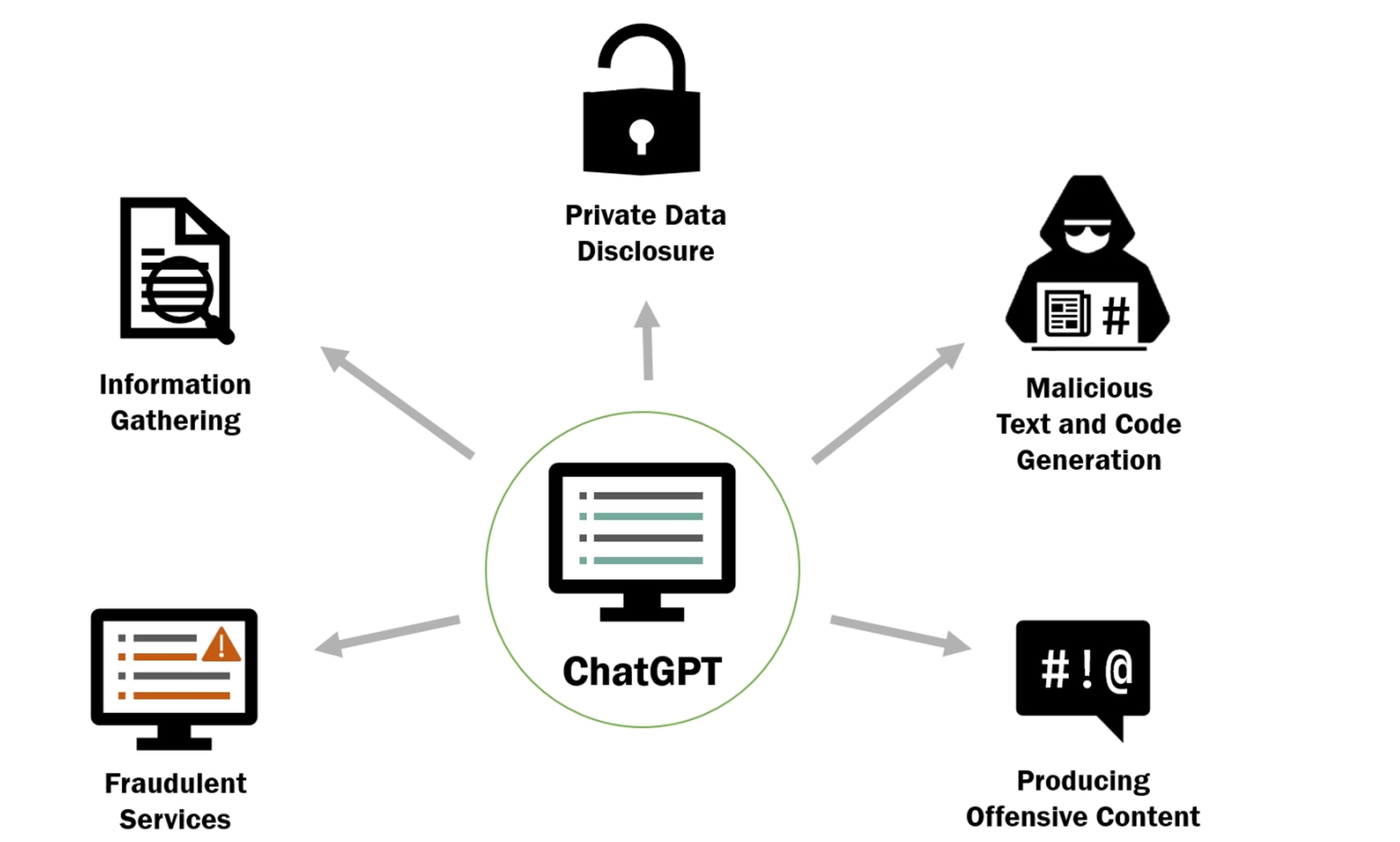

Pese a esto, un nuevo y reciente estudio ha identificado 6 grandes implicaciones de seguridad diferentes relacionadas con el uso de ChatGPT. Se incluye: generación de servicios fraudulentos, recopilación de información dañina, divulgación de datos privados, generación de texto malicioso, generación de código malicioso y producción de contenido ofensivo.

Los mayores riesgos a los que te expones si usas ChatGPT

Recopilación de información

El uso de ChatGPT plantea preocupaciones relacionadas con la recopilación de información. Aunque este en sí mismo no recopila información personal identificable, existe la posibilidad de que los usuarios compartan información confidencial o sensible durante sus interacciones con el chatbot.

Por ejemplo, si un usuario proporciona detalles personales como nombres, direcciones, números de teléfono u otra información privada, existe el riesgo de que esta información sea almacenada y utilizada de manera indebida. Si los datos se almacenan o registran sin el consentimiento adecuado, podría haber riesgos de privacidad y seguridad, especialmente si caen en manos equivocadas o se utilizan con fines maliciosos.

Tal y como explican en ZDNET, la interrupción de ChatGPT del 20 de marzo, que permitió a algunos usuarios ver títulos del historial de chat de otros usuarios, es un ejemplo real de las preocupaciones actuales.

"Esto podría usarse para ayudar en el primer paso de un ataque cibernético cuando el atacante está recopilando información sobre el objetivo para encontrar dónde y cómo atacar de manera más efectiva", dice el estudio.

Servicios fraudulentos

ChatGPT podría ser utilizado para generar contenido que promueva servicios fraudulentos, como ofertas de inversión falsas, esquemas piramidales o ventas engañosas. Esto podría llevar a las personas a perder dinero o divulgar información personal confidencial.

Importante mencionar su uso para proporcionar asesoramiento legal o financiero falso o engañoso, que podría llevar a las personas a tomar decisiones equivocadas o ilegales.

Texto malicioso

Por otro lado, los ciberdelincuentes podrían utilizar ChatGPT para crear contenido que parezca legítimo, como correos electrónicos de phishing o mensajes engañosos. Esto podría aumentar el riesgo de que las personas sean víctimas de estafas o ataques cibernéticos.

Si se utiliza de manera incorrecta, podría generar contenido ilegal, como guías para actividades ilegales, incitación a la violencia o contenido pornográfico infantil.

Generación de código malicioso

Lo mismo ocurre con el código malicioso. ChatGPT podría ser utilizado para generar virus, troyanos u otros tipos de malware. Esto podría dar lugar a ataques y comprometer la seguridad de sistemas informáticos.

También podría ser utilizado para encontrar y explotar vulnerabilidades en sistemas informáticos o aplicaciones. Esto podría permitir a los atacantes tomar el control de sistemas o acceder a información confidencial.

Finalmente también sirve para generar código malicioso de manera que sea más difícil de detectar por sistemas de seguridad y antivirus.

Producir contenido poco ético

Si bien el modelo tiene el potencial de generar contenido útil y valioso, también existe la posibilidad de que se utilice de manera inapropiada o irresponsable como ya se ha demostrado en varias ocasiones en Computer Hoy.

Por ejemplo, si se entrena a ChatGPT con datos que contienen prejuicios o sesgos, el modelo puede generar contenido que sea ofensivo, discriminatorio o perjudicial para ciertos grupos de personas. También se podría usar para generar contenido falso o desinformación, contribuyendo a la propagación de información engañosa o teorías de conspiración.

Divulgación de datos privados

Si los usuarios interactúan con ChatGPT sin tener en cuenta la confidencialidad de la información que comparten, podrían revelar involuntariamente datos privados sensibles. Lo mismo ocurre si le pides generar documentos, como informes o transcripciones, que contengan datos privados sensibles sin el conocimiento o consentimiento adecuado.

En última instancia y teniendo todo esto en cuenta, si los sistemas que implementan ChatGPT no cuentan con las medidas de seguridad adecuadas o sufren un ataque, estos datos quedarían expuestos a ataques.

Redactora de Tecnología

Redactora de Tecnología, especializada en inteligencia artificial y ciberseguridad.

Otros artículos interesantes:

Conoce cómo trabajamos en Computerhoy.