Un ranking de modelos de inteligencia artificial según sus alucinaciones, deja a las IAs de Google como las más "mentirosas"

Getty Images

- Un software llamado Public LLM leaderboard calcula el nivel de alucinaciones que generan los principales modelos de lenguaje grandes.

- Las inteligencias artificiales GPT y Llama alucinan poco, entre el 3 y el 6%. Las peores son las de Google, que generan información errónea hasta un 27,2% de las veces.

- Duro golpe de Google Maps a su competidores, tiembla Waze.

Las alucinaciones de la inteligencia artificial son un gran problema para sus creadores, porque una alucinación es, básicamente, una mentira. Un ranking de modelos de lenguaje, en función de sus alucinaciones, ha levantado un enorme revuelo. Las IAs de Google quedan como unas mentirosas.

Una alucinación de una inteligencia artificial es una información que ofrece una IA, sin estar basada en los datos con los que ha sido entrenada. Es algo que se ha inventado, y en la mayoría de los casos, es un dato falso.

Estas alucinaciones se cuelan entre datos veraces, así que son difíciles de detectar. Pero pueden causar muchos problemas si un usuario acepta una alucinación como una verdad, sin darse cuenta.

Es muy famoso el caso de un bufete de abogados que usó ChatGPT para documentar un caso, y presentó al juez supuestos casos reales, que en realidad la IA de OpenAI se había inventado.

El ranking de modelos de lenguaje, según sus alucinaciones

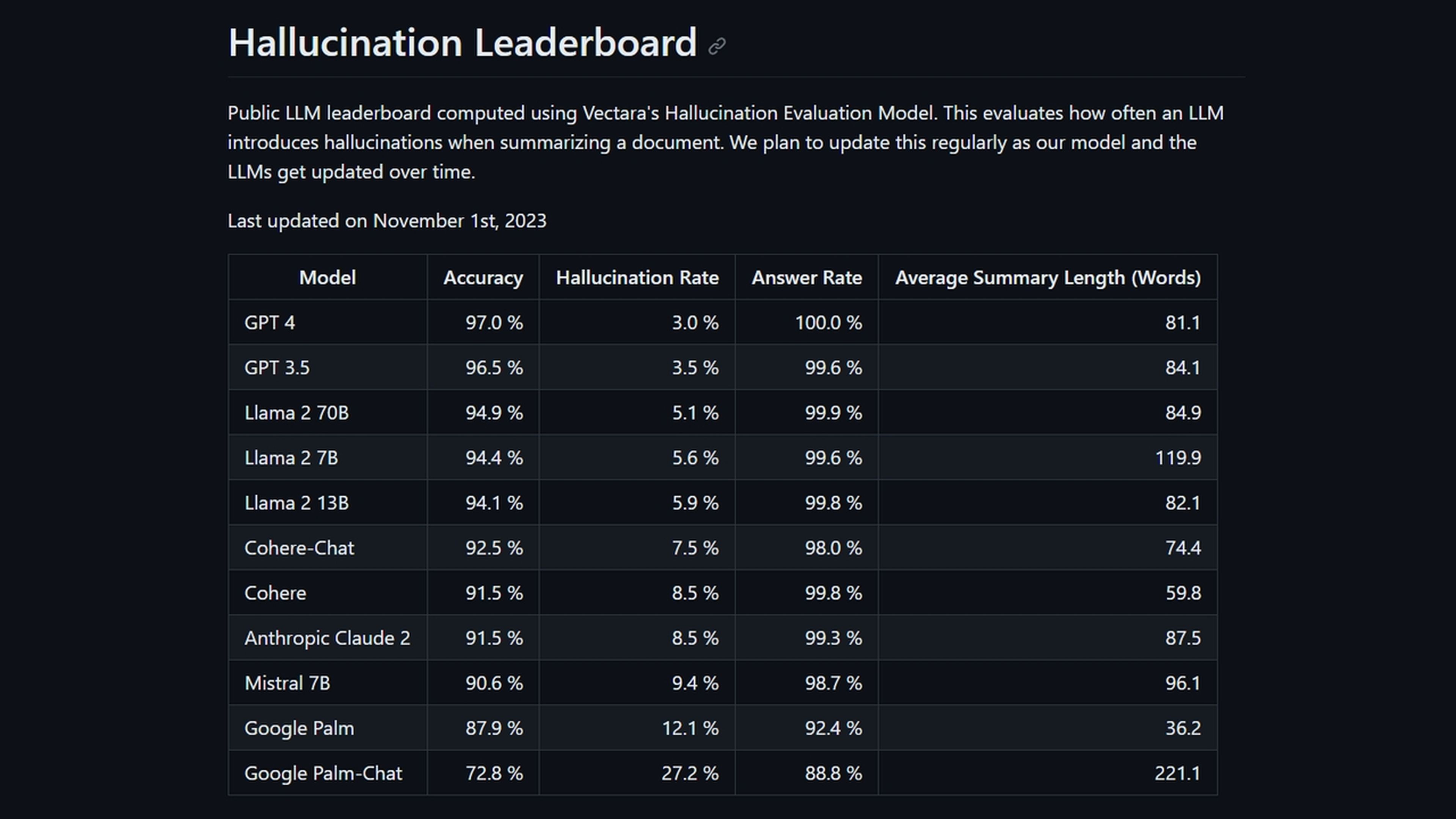

Una compañía de software llamada Vectara ha desarrollado un software que detecta alucinaciones de los principales Modelos de Lenguaje Grandes (LLM en sus siglas en inglés). Estos modelos son la base sobre la que se crean los chatbots. Por ejemplo, ChatGPT está basado en los modelos de lenguaje GPT.

Según este ranking de modelos de IA según sus alucinaciones, los más fiables son los modelos de lenguaje de OpenAI (GPT), seguidos de los de Meta (Llama). Los más "mentirosos" son los de Google (Palm):

Como vemos, GPT 4 solo tiene un ratio de alucinaciones del 3%, frente al 3,5% de GPT 3.5. El ratio de los diferentes modelos de Llama 2 también es aceptable, entre el 5,1 y el 5,9%.

Los modelos de lenguaje de Google, Palm y Palm-Chat, son los que más "alucinan", con un preocupante porcentaje del 12,1 y el 27,2%, respectivamente.

¿Cómo ha llegado Vectara a estos datos? Proporcionó a los diferentes modelos de lenguaje una pila de más de 800 documentos de referencia breves. Después les pidió que hiciesen resúmenes de los documentos.

El prompt usado fue el siguiente: "Eres un chatbot que responde a preguntas utilizando datos. Debes ceñirte a las respuestas proporcionadas únicamente por el texto del pasaje proporcionado. Se te plantea la pregunta "Haz un resumen conciso del siguiente pasaje, que incluya los datos principales descritos".

Finalmente, un modelo propio de Vectara buscó los datos de los resúmenes, que no estaban en los documentos proporcionados.

El ranking ha generado mucha polémica, porque estos modelos grandes de lenguaje son usados por empresas y gobiernos para generar informes y resúmenes de datos oficiales, médicos, o empresariales. Y en cierto tiempo de tareas críticas, los fallos son inaceptables.

Que una IA como Google Palm-Chat se invente datos en una de cada cuatro consultas (siempre según Vectara), es para desconfiar...

Este ranking de IAs en función de sus alucinaciones, demuestra que aún queda mucho para que podamos confiar al 100% en las respuestas que ofrece una inteligencia artificial generativa. Úsalas con moderación, y contrasta los resultados...

Otros artículos interesantes:

- Cómo combinar DALL-E 3 con Midjourney para crear imágenes espectaculares con inteligencia artificial

- YouTube se revoluciona y la inteligencia artificial cambiará tu forma de ver los vídeos

- Silla ergonómica Sihoo Doro S300: la tecnología más avanzada al servicio del mejor diseño y la máxima comodidad

Descubre más sobre Juan Antonio Pascual Estapé, autor/a de este artículo.

Conoce cómo trabajamos en Computerhoy.