¿Qué es una alucinación de la inteligencia artificial y por qué resulta tan peligrosa?

- Las alucinaciones en la inteligencia artificial están planteando grandes y numerosos riesgos debido a la generación de información o imágenes que no se basan en datos reales

- Es como si la IA se convirtiese en futuróloga cuando su uso debe basarse en hechos reales y contrastados.

- 25 aniversario de Computer Hoy: Inteligencia Artificial, todo lo que nos puede ofrecer en el futuro.

En la actualidad, la inteligencia artificial ha demostrado su poder para transformar industrias enteras y cambiar la forma en que se interactúa con la tecnología. Sin embargo, en este mundo de algoritmos y datos masivos, surge un fenómeno que despierta bastantes preguntas: las alucinaciones de la IA.

Imagina por un momento que una máquina, diseñada para procesar datos y tomar decisiones basadas en la lógica, pueda en ocasiones "ver" cosas que no existen o malinterpretar lo que está frente a sus sensores.

Parece sacado de la ciencia ficción, ¿verdad? Sin embargo, las alucinaciones de la IA son una realidad en constante estudio.

En este reportaje se hablarán de las raíces de este fenómeno, explorando cómo las mentes digitales procesan información, los algoritmos detrás de estas percepciones y las posibles implicaciones en la sociedad.

- ¿Qué es una alucinación de la inteligencia artificial?

- ¿Por qué ocurre este fenómeno?

- El gran error y potencial peligro de la inteligencia artificial

- Entonces, ¿cómo se puede hacer frente a este complejo problema?

¿Qué es una alucinación de la inteligencia artificial?

Las alucinaciones de la IA son errores en la percepción de las máquinas que hacen que interpreten datos o señales de manera incorrecta, creyendo que están experimentando algo que en realidad no está presente.

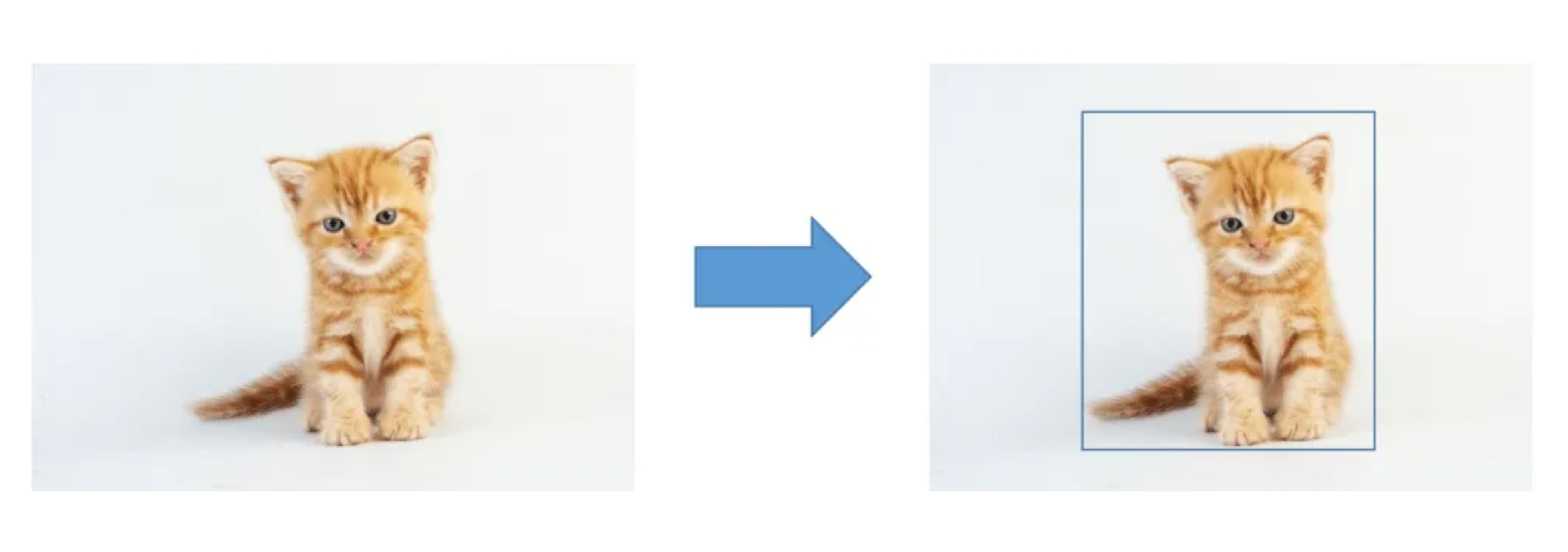

Un ejemplo sencillo sería una inteligencia artificial entrenada para identificar objetos en imágenes. Si esta IA comienza a detectar objetos que no están allí, como ver un elefante en una imagen de una playa donde no hay elefantes, estaría experimentando una alucinación de la IA.

Estas alucinaciones pueden ocurrir debido a diversos factores, como problemas en los datos de entrenamiento, errores en los algoritmos o limitaciones en los sensores de la máquina, y pueden tomar muchas formas diferentes, desde la creación de noticias falsas hasta afirmaciones o documentos falsos sobre personas, eventos o hechos científicos.

¿Por qué ocurre este fenómeno?

Las alucinaciones por IA pueden ocurrir debido a una serie de razones que involucran el proceso de entrenamiento y funcionamiento de estas herramientas:

- Datos de entrenamiento sesgados o insuficientes: una IA se entrena usando grandes cantidades de datos. Si estos contienen sesgos o no representan adecuadamente todas las situaciones posibles, la IA puede aprender patrones incorrectos.

Imagina que entrenas una IA para reconocer gatos, pero todos los gatos en los datos de entrenamiento son de una raza específica. La IA podría alucinar y pensar que todos los gatos deberían tener esa apariencia en particular.

themachinelearners

- Complejidad del mundo real: teniendo esto en cuenta, las IA a veces tienen dificultades para comprenderlo correctamente.

Por ejemplo, una IA que analiza imágenes podría confundirse al ver sombras o reflejos en lugar de objetos reales. Esto podría llevar a alucinaciones, donde la IA interpreta erróneamente estos elementos como objetos reales.

- Limitaciones en los algoritmos: los algoritmos utilizados pueden ser excelentes en tareas específicas, pero pueden fallar cuando se enfrentan a situaciones inusuales o complejas.

Por ejemplo, una IA de procesamiento de lenguaje natural podría alucinar al interpretar mal una pregunta ambigua.

- Interacciones con datos ruidosos: los datos reales pueden contener ruido o información incorrecta. Si una IA no está diseñada para manejar estos datos ruidosos, de forma adecuada podría generar alucinaciones al tratar de encontrar patrones en el ruido.

- Comprender el contexto: si una IA está diseñada para responder preguntas generales y se le hace una pregunta médica específica, podría alucinar al proporcionar una respuesta incorrecta debido a la falta de contexto.

El gran error y potencial peligro de la inteligencia artificial

Los desarrolladores han advertido contra los modelos y herramienta de IA que producen hechos totalmente falsos y responden a las preguntas con respuestas inventadas como si fueran verdad. Como puede poner en peligro la precisión, la fiabilidad y la confiabilidad de las aplicaciones, la alucinación es una barrera importante para el desarrollo y la implementación de sistemas de IA.

Por ejemplo, ChatGPT puede crear una figura histórica con una biografía completa y logros que nunca fueron reales. El problema es que en la era actual, donde un solo tuit puede llegar a millones de personas en segundos, la posibilidad de que esta información incorrecta se propague genera grandes dificultades.

Sin embargo, —y pese a que es un gran problema— hay otros sectores en los que interviene o se prevé que intervenga la IA que resultan aún más peligrosos como la medicina.

Getty

Por otro lado, si una IA que participa en los vehículos autónomos alucina y percibe objetos inexistentes en la carretera, como un peatón o un obstáculo, podría provocar maniobras bruscas o frenazos de repente, causando posibles accidentes de tráfico y poniendo en riesgo la vida de muchas personas.

Finalmente y por terminar con los ejemplos está su uso en la ciberseguridad. Si una herramienta basada en inteligencia artificial falla por este motivo y percibe amenazas que son falsas, generaría una alarma general que conduce a respuestas innecesarias y costosas.

Por ejemplo, un caso más o menos reciente hace referencia a la Super Bowl de febrero. Associated Press preguntó a Bing por el acontecimiento deportivo más importante de las últimas 24 horas, con la esperanza de que dijera algo sobre la estrella del baloncesto LeBron James.

Sin embargo, nada más lejos de la realidad. En lugar de eso, se limitó a dar una información falsa pero detallada sobre la próxima Super Bowl, días antes de que se celebrase. "Fue un partido emocionante entre los Philadelphia Eagles y los Kansas City Chiefs, dos de los mejores equipos de la NFL esta temporada", dijo Bing.

Entonces, ¿cómo se puede hacer frente a este complejo problema?

Para hacer frente a esta situación, se requiere un enfoque multifacético. En primer lugar, la supervisión humana desempeña un papel central en la detección temprana de alucinaciones por IA. Los expertos deben estar constantemente atentos al comportamiento de las IA y ser capaces de identificar cualquier problema que no se esté ajustando a la realidad.

Además, el entrenamiento de las IA desempeña un papel crucial en la prevención de alucinaciones. Es fundamental proporcionar a las IA un entrenamiento riguroso basado en conjuntos de datos de alta calidad que reflejen situaciones reales. Esto incluye casos de prueba que desafíen a la IA en escenarios complicados y poco comunes, lo que contribuye a reducir las alucinaciones.

Se están desarrollando algoritmos especializados para detectar alucinaciones por IA. Estos analizan el comportamiento y las respuestas de la IA en busca de indicios de alucinaciones.

Las auditorías y pruebas exhaustivas son esenciales en este proceso. Las auditorías pueden implicar la revisión de registros de decisiones y acciones de la IA para detectar alucinaciones pasadas. Las pruebas rigurosas, que incluyen casos de prueba desafiantes, evalúan el rendimiento y la capacidad de la IA para lidiar con situaciones complejas.

Para mitigar los riesgos, las IA pueden estar equipadas con mayores sistemas de seguridad. Estas medidas adicionales pueden evitar que la IA tome decisiones peligrosas en caso de alucinaciones. Por ejemplo, en sistemas de conducción autónoma, se pueden implementar sistemas de frenado automático de emergencia.

La colaboración entre la comunidad de investigación en IA y las autoridades reguladoras es esencial. Juntos pueden establecer estándares y pautas para el desarrollo seguro de IA. La regulación adecuada puede requerir pruebas de seguridad y evaluaciones de riesgos antes de implementar sistemas de IA en entornos críticos.

En conjunto, estos enfoques buscan minimizar los peligros asociados con las alucinaciones por IA y garantizar que la inteligencia artificial se utilice de manera segura y confiable en diversas aplicaciones. Resolver este problema es fundamental para aprovechar el potencial de la IA mientras se protege la integridad y la seguridad de las operaciones críticas.

Redactora de Tecnología

Redactora de Tecnología, especializada en inteligencia artificial y ciberseguridad.

Otros artículos interesantes:

Conoce cómo trabajamos en Computerhoy.