Así presencié cómo copiaban la voz de un CEO con inteligencia artificial para engañar a su propia empresa

Computer Hoy

- Pese a que en este caso simplemente era una demostración de cómo la IA ya puede usarse de forma fácil para copiar voces de personas, deja claro el peligro de esta tecnología.

- Y si no que se lo digan a un empleado que fue engañado con una voz clonada y transfirió 23,7 millones de euros.

Recogiendo una ponencia de la RootedCON 2024 realmente curiosa e ilustrativa de la realidad que actualmente se vive en todo el mundo si se habla de inteligencia artificial usada para hacer el mal, los deepfakes están ganando poco a poco una gran fama y no, no en positivo.

Estas imágenes, vídeos y voces generadas por IA pueden ser utilizadas para la propagación de desinformación, el engaño en campañas publicitarias o incluso en actividades delictivas. Y precisamente es el arte de la clonación de voz en la que la ponencia puso el foco.

Sin ir más lejos, hace algo más de un mes, saltó la noticia una noticia de Hong Kong que dejó al mundo empresarial en estado de alerta. Un empleado de una compañía financiera transfirió la cantidad de 23,7 millones de euros a lo que creía que era la filial de su empresa en el Reino Unido.

Sin embargo, este suceso no fue más que el resultado de un sofisticado fraude perpetrado con la ayuda de la tecnología deepfake, según ha informado la policía local. En este caso, los estafadores utilizaron audios y vídeos generados por inteligencia artificial para hacerse pasar por el director financiero y otros compañeros durante una videoconferencia.

El auge de la clonación de voz con inteligencia artificial ha abierto nuevas puertas para los estafadores en el mundo digital.

Cada vez más, los ciberdelincuentes se valen de herramientas basadas en IA para perpetrar fraudes complejos, como el uso de deepfakes para crear audios y vídeos falsos pero convincentes y es lo que Antonio Fernandes, hacker y responsable de ciberseguridad y Daniel Fernández Martínez, Security Manager en Telefónica Tech quisieron demostrar en su conferencia.

Computer Hoy

"La inteligencia artificial nos facilita tener cosas que de manera natural no podríamos tener y avanzar un poco nuestras capacidades"

Consiguieron de forma realmente sencilla el número de teléfono de Juan Antonio Calles, CEO de Zerolynx, para usar su voz y tratar de engañar a su propia empresa como si del anterior caso se tratase —lógicamente todo era una demostración y aunque estaban avisados explican que alguno cayó en la trampa—.

Tras conseguir esto, necesitaban recopilar su voz para luego usarla de forma ilegal generar una copia de ella usando inteligencia artificial. "¿Qué tienen los CEOs y la gente a la que le gusta vender su empresa? Pues que van a muchos pódcast, hacen muchas charlas y se intentan exponer públicamente", explicaban en la ponencia.

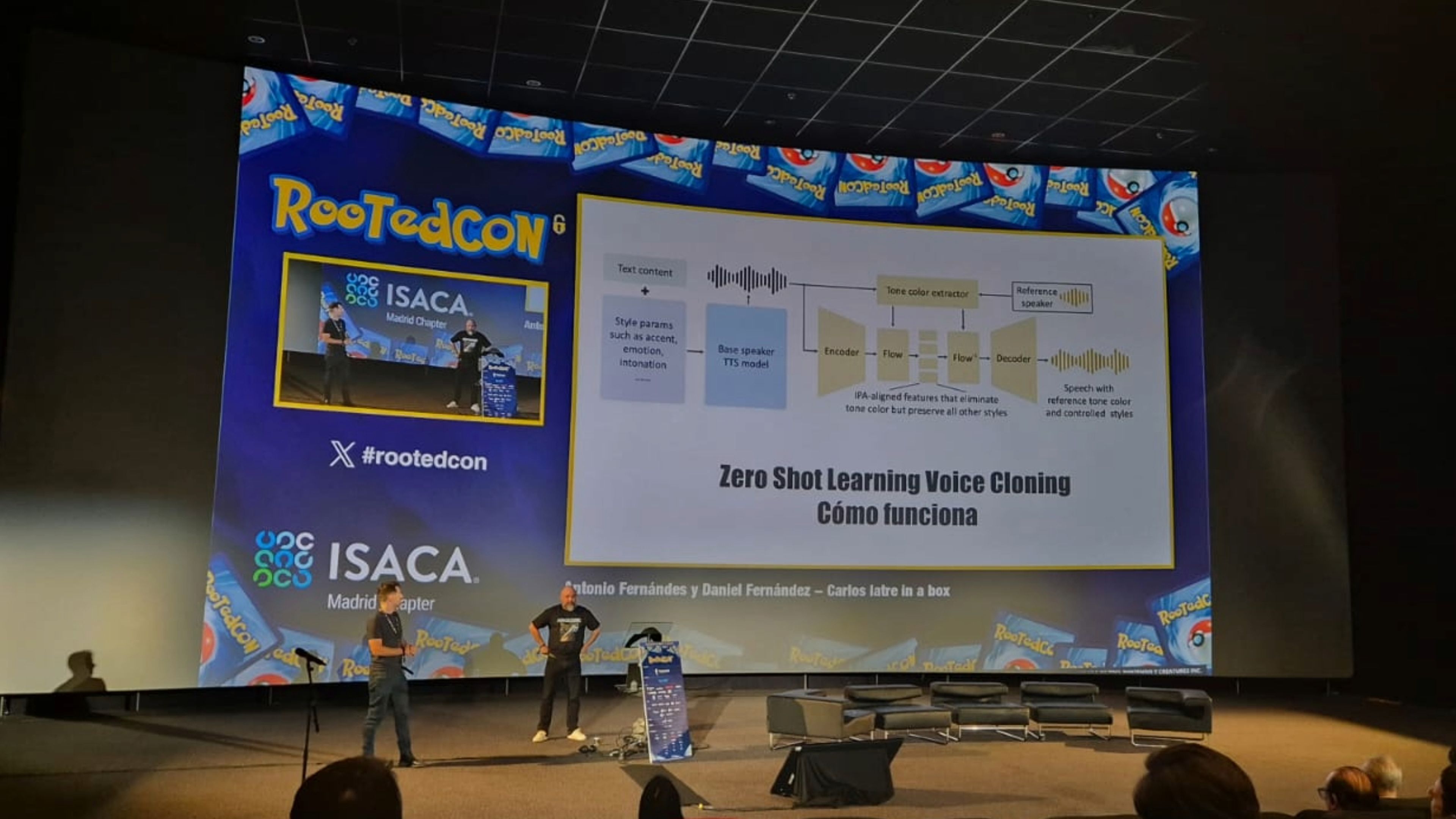

Con el uso de varias herramientas de libre acceso que cualquier puede encontrar en Internet como Whisper, de OpenAI, entre otras tantas. Con todo esto, al final "lo que se hace es extraer el timbre de la voz y con eso más el contenido y la emoción, podemos hacer que la voz final sea más alegre o más triste o que se pueda ver que transite algún sentimiento en la forma de comunicar las cosas", comentan.

Finalmente, personas del propio público pudieron en directo grabar su voz y que, de forma inmediata, se reprodujese con la de Juan Antonio Calles con una precisión bastante exacta y que, desde luego, en una llamada podría acabar colando.

Computer Hoy

La disponibilidad cada vez mayor de este tipo de herramientas que es cierto que requieren ciertos conocimientos, pero no demasiados, ha facilitado aún más la realización de estos ataques e incluso bandas de ciberdelincuentes ofrecen plataformas de clonación de voz listas para usar, lo que permite a otros llevar a cabo ataques sin necesidad de poseer conocimientos técnicos.

Estas plataformas automatizadas pueden generar voces falsas de famosos, políticos o personas influyentes, lo que las convierte en una herramienta peligrosa para difundir desinformación o llevar a cabo fraudes.

El caso de Hong Kong o esta prueba que realizaron de forma exitosa en la RootedCON es solo uno de los muchos ejemplos de cómo la tecnología deepfake está siendo utilizada para cometer fraudes a gran escala.

"El principal consejo ahora mismo es no obsesionarse con este tipo de amenazas y estar continuamente buscando voces 'deepfakes' donde no las hay. Es poco probable que con la tecnología actual se pueda crear una voz que no se pueda reconocer como artificial. Sin embargo, hay que ser conscientes de las amenazas que se ciernen y prepararse para el futuro. Los 'deepfakes' serán muy pronto una nueva realidad", explica Dmitry Anikin, científico de datos senior de Kaspersky.

Redactora de Tecnología

Redactora de Tecnología, especializada en inteligencia artificial y ciberseguridad.

Otros artículos interesantes:

- Lo que aconsejan los expertos si una IA intenta engañarte: clonar voces o usar 'deepfakes' para robar tus datos personales

- Falso amor, el reality español de Netflix que usa deepfakes para engañar a los concursantes

- Silla ergonómica Sihoo Doro S300: la tecnología más avanzada al servicio del mejor diseño y la máxima comodidad

Conoce cómo trabajamos en Computerhoy.