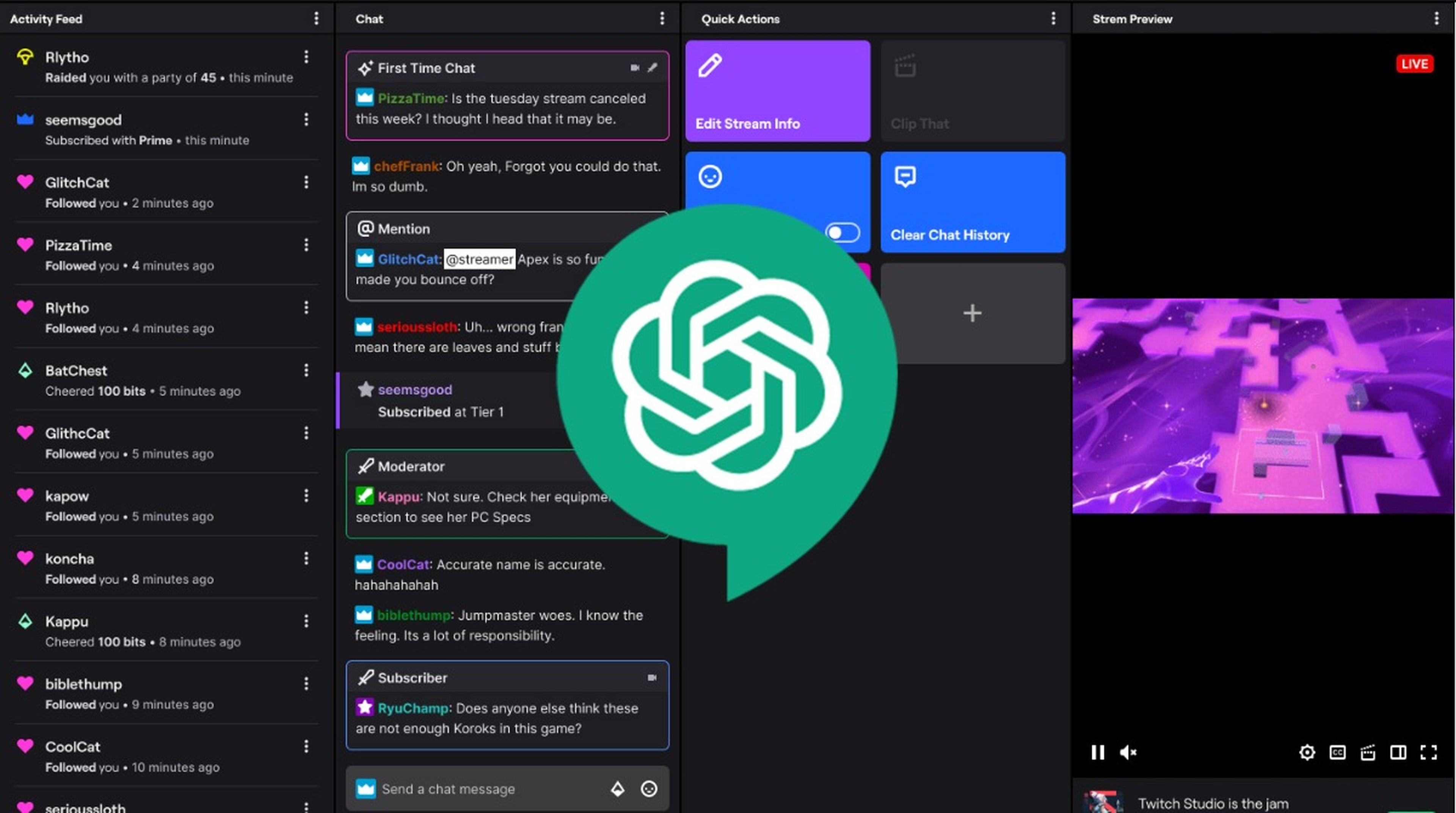

ChatGPT como moderador: ¿la IA regulando las redes sociales y plataformas de streaming?

Twitch

La inteligencia artificial posiblemente asuma un nuevo rol: el de moderador en plataformas. Con GPT-4 liderando el proyecto, se busca combatir el contenido perjudicial en línea y agilizar el cumplimiento de las políticas de las plataformas.

GPT-4, el potente modelo de lenguaje grande (LLM) basado en inteligencia artificial detrás de ChatGPT Plus —la versión de pago de ChatGPT—, podría estar en camino de asumir un nuevo papel crucial como moderador en línea, supervisando foros y redes sociales en busca de contenido perjudicial.

Esta perspectiva surge de una reciente publicación de blog de OpenAI, la empresa de detrás de este chatbot, que sugiere que esta medida podría dar a todos una gran herramienta para mejorar la visión que hay de plataformas como Facebook o incluso Twitch.

"La moderación de contenido juega un papel crucial en el mantenimiento de la salud de las plataformas digitales. Un sistema de moderación de contenido que usa GPT-4 da como resultado una iteración mucho más rápida de los cambios de política, lo que reduce el ciclo de meses a horas", explica OpenAI en su blog.

"Tradicionalmente, la carga de esta tarea ha recaído en los moderadores humanos que filtran grandes cantidades de contenido para filtrar material tóxico y dañino, con el apoyo de modelos de aprendizaje automático específicos verticales más pequeños. El proceso es intrínsecamente lento y puede generar estrés mental en los moderadores humanos", añaden.

¿ChatGPT moderando las redes sociales? ¿Adiós a un empleo humano?

El enfoque en la IA como moderador presenta varias ventajas, según OpenAI. Por un lado, el uso de GPT-4 podría permitir una acción más rápida en los cambios de política, reduciendo el tiempo necesario de meses a horas.

Además, esta IA podría comprender y aplicar las reglas y matices de la documentación de políticas en ocasiones tan extensa, adaptándose instantáneamente a las actualizaciones y resultando en una moderación muy perfeccionista y sobre todo precisa.

Para ilustrar este concepto, la publicación del blog de OpenAI ofrece un ejemplo. Los equipos de moderación podrían asignar etiquetas a contenido específico para indicar si cumple con las reglas de la plataforma. GPT-4 podría aplicar etiquetas por sí mismo a partir del mismo conjunto de datos, sin conocer las respuestas previas. Luego, los moderadores humanos podrían comparar ambas series de etiquetas, aprovechando las discrepancias para mejorar la claridad de las reglas.

A pesar de los potenciales beneficios, surgen algunas preguntas y problemas por el camino. Es cierto que la moderación actual está en manos de seres humanos, que se exponen a contenido multitudinario que deben moderar. La introducción de la IA en esta función podría mejorar las condiciones laborales de los moderadores humanos y aliviar la carga mental que conlleva el control de todo ese contenido.

Sin embargo, existe el gran problema de siempre con respecto a la IA: la pérdida de empleos en este proceso. Si GPT-4 reemplaza a moderadores humanos, es innegable que surjan preocupaciones sobre la pérdida de trabajo en lugar de la reasignación a otros roles.

Pese a que OpenAI no aborda este asunto en su publicación de forma explícita, lo que plantea dudas sobre si las grandes empresas adoptarán la IA solo como medida de ahorro de costes, sí que deja al final un mensaje relacionado.

"Al igual que con cualquier aplicación de IA, los resultados y la salida deberán monitorearse, validarse y refinarse cuidadosamente manteniendo a los humanos al tanto. Al reducir la participación humana en algunas partes del proceso de moderación que pueden ser manejadas por modelos de lenguaje, los recursos humanos pueden concentrarse más en abordar los casos extremos complejos más necesarios para el perfeccionamiento de políticas", finalizan.

A pesar de las incertidumbres, la idea de usar la IA para reducir el tortuoso trabajo de los moderadores y mejorar la seguridad de las plataformas digitales es bastante curiosa, al menos por el momento.

A medida que poco a poco se integre en algunas plataformas será interesante ver cómo realmente funciona la IA en este caso y si la ausencia de un humano resulta tan desastrosa en este caso en el que los matices y el contexto del lenguaje es realmente importante para saber si una persona debería o no abandonar el chat de la plataforma.

Redactora de Tecnología

Redactora de Tecnología, especializada en inteligencia artificial y ciberseguridad.

Otros artículos interesantes:

Conoce cómo trabajamos en Computerhoy.