Tus conversaciones en ChatGPT no son tan privadas como crees y estos hackers consiguen descifrarlas

- Parece que tus chats con ChatGPT no son tan privados como piensas y este grupo de hackers éticos ha conseguido burlar su seguridad y descifrar las conversaciones.

- Para protegerse de este tipo de ataques, es recomendable no usar una red WiFi pública y sobre todo evita compartir información confidencial con ChatGPT.

ChatGPT se ha convertido en una herramienta realmente útil para muchas personas que lo utilizan en su día para ayudarles con resúmenes, código o simplemente para hacer consultas. Sin embargo, una nueva investigación ha puesto sobre la mesa un tema ya debatido en otras ocasiones: ¿hasta qué punto tus conversaciones con ChatGPT son realmente seguras?

Si bien OpenAI, la empresa que se encuentra detrás, asegura que protege la privacidad de los usuarios, lo cierto es que existe la posibilidad de que algunos empleados de la compañía puedan acceder a las conversaciones con fines técnicos o de seguridad.

El problema es que también hay otras vías por las que las conversaciones podrían llegar a manos de terceros con no tan buenas intenciones como los ciberdelincuentes.

Un estudio del Laboratorio de Investigación de IA Ofensiva de la Universidad Ben-Gurion en Israel ha desvelado un método para interceptar y descifrar las respuestas de ChatGPT, incluso cuando estas aparentemente parecen estar protegidas. El ataque se conoce como Side-channel attack.

Laboratorio de Investigación de IA Ofensiva de la Universidad Ben-Gurion

Así funciona 'Side-channel attack', el ataque que podría comprometer tus conversaciones con ChatGPT

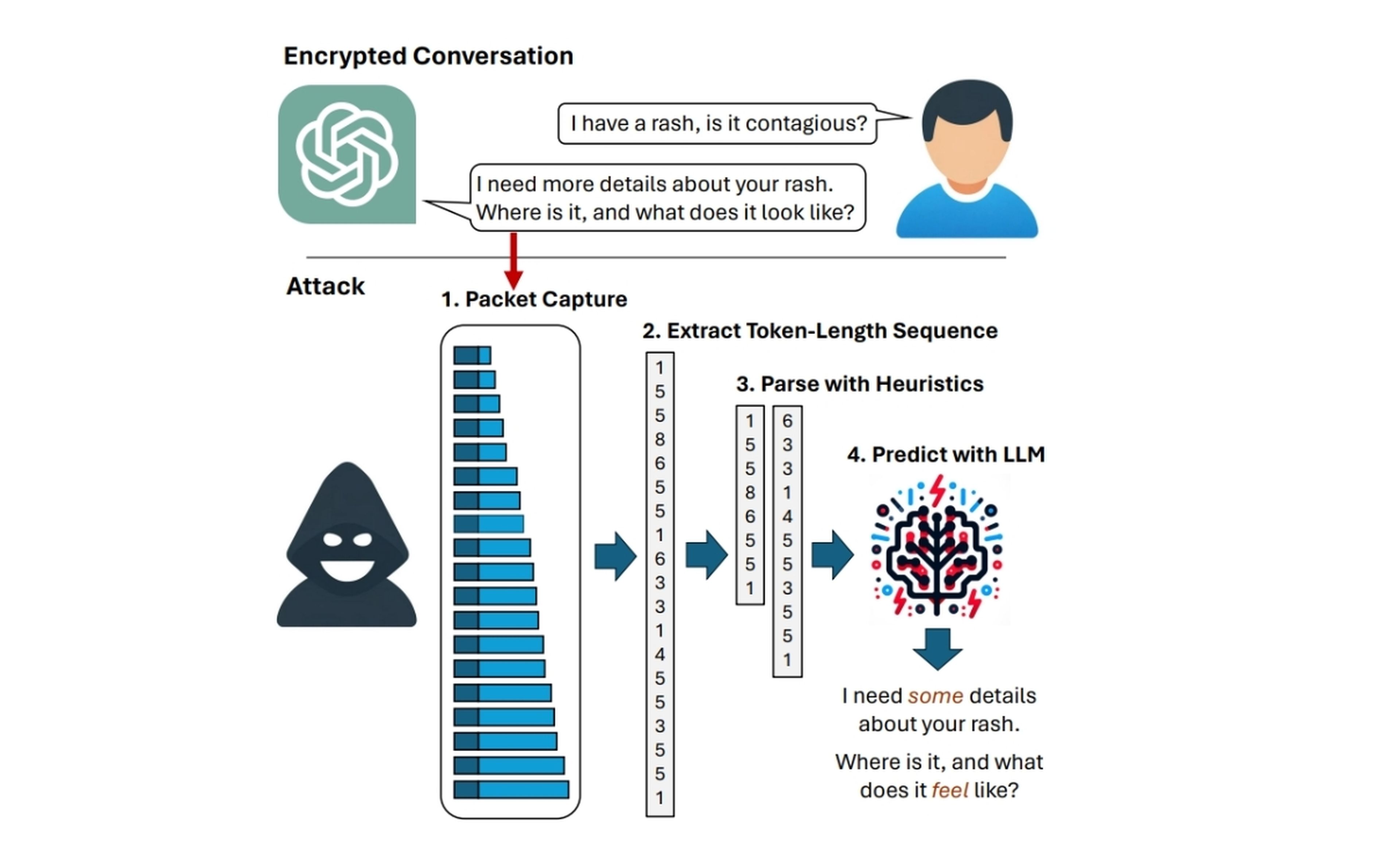

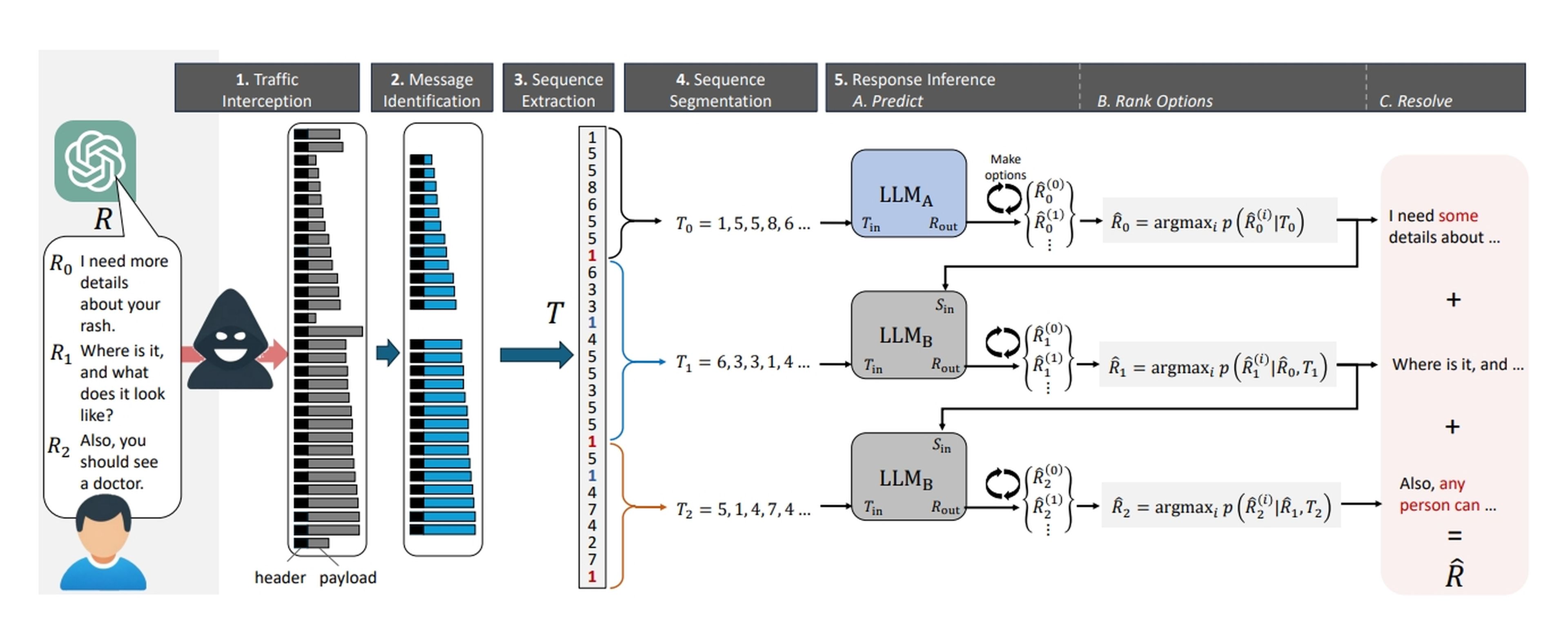

De forma simple, este ataque se basa en la interceptación y el análisis del tráfico de datos entre el usuario y los servidores de OpenAI. Se divide en cuatro pasos:

1. Interceptar el tráfico de la víctima: el atacante necesita interceptar el tráfico de datos que se envía entre el dispositivo del usuario y los servidores de OpenAI. Esto puede ser posible si el usuario está conectado a una red WiFi pública no segura o si el atacante ha logrado comprometer la seguridad del router del usuario.

2. Filtrar los paquetes para encontrar las respuestas de ChatGPT: una vez hecho el primer paso, el atacante debe filtrar los paquetes que contienen las respuestas de ChatGPT. Esto se puede hacer mediante técnicas de análisis de datos que buscan patrones específicos en los paquetes.

Laboratorio de Investigación de IA Ofensiva de la Universidad Ben-Gurion

3. Revelar la longitud de los tokens: las respuestas de ChatGPT se envían en forma de tokens, que son unidades de información que pueden representar una palabra, una frase o incluso un carácter. El atacante puede utilizar técnicas de análisis de paquetes para determinar la longitud de cada token.

4. Inferir la respuesta de ChatGPT utilizando un LLM: la longitud de los tokens da información sobre la respuesta de ChatGPT, por lo que el atacante puede utilizar un modelo de lenguaje grande (LLM) entrenado para predecir la respuesta de ChatGPT en función de la longitud de los tokens.

Tal y como explican, los investigadores en sus pruebas fueron capaces de inferir con un 55% de alta precisión estos tokens usando un LLM. Es importante también mencionar que este ataque no es exclusivo de ChatGPT y puede ser utilizado contra otros chatbots de IA como Copilot que utilizan un método similar para enviar sus respuestas.

Redactora de Tecnología

Redactora de Tecnología, especializada en inteligencia artificial y ciberseguridad.

Otros artículos interesantes:

Conoce cómo trabajamos en Computerhoy.