No tiene rival: el nuevo ChatGPT arrasa y deja tiritando otras IA como Gemini de Google

Computer Hoy

OpenAI y Google han desatado una batalla de titanes en el mundo de la inteligencia artificial con el lanzamiento de sus modelos insignia: GPT-4o y Gemini 1.5 Pro. Teniendo esto en cuenta, ya era hora de que se pusiesen a prueba.

Teniendo en cuenta la gran rivalidad que actualmente se está viviendo en el sector de la inteligencia artificial, parece que hay dos actores que a día de hoy luchan por la victoria: Google y OpenAI.

La compañía dirigida por Sam Altman han lanzado recientemente GPT-4o, un nuevo modelo que ha llegado para reivindicar su posición en lo más alto del ránking y llevar a ChatGPT a una posición inamovible.

Por otro lado, en el evento Google I/O 2024 se presentó el modelo Gemini 1.5 Pro que nutre Gemini Advanced, por lo que la lucha entre ambos no ha hecho más que empezar.

Tomando precisamente estos dos nuevos modelos, desde Beebom han querido ponerlos a prueba: "Ahora que hay dos modelos emblemáticos disponibles para los consumidores, comparemos ChatGPT 4o y Gemini 1.5 Pro y veamos cuál hace un mejor trabajo".

ChatGPT con GPT 4o vs. Gemini con Gemini 1.5 Pro: el ganador está bastante claro

Desde Beebom han querido evaluar ambos chatbots con sus respectivos nuevos modelos de lenguaje en hasta ocho tareas diferentes que van desde cálculos, reconocimiento de imágenes o incluso crear un juego. Spoiler: GPT 4o está a años luz de Gemini 1.5 Pro.

Comenzando con una prueba clásica de razonamiento, ChatGPT demostró una gran superioridad al destrozar a Gemini en la comprensión de preguntas complejas. Mientras que el modelo de Google tuvo dificultades para llegar a respuestas precisas, ChatGPT mostró una capacidad de razonamiento a otro nivel.

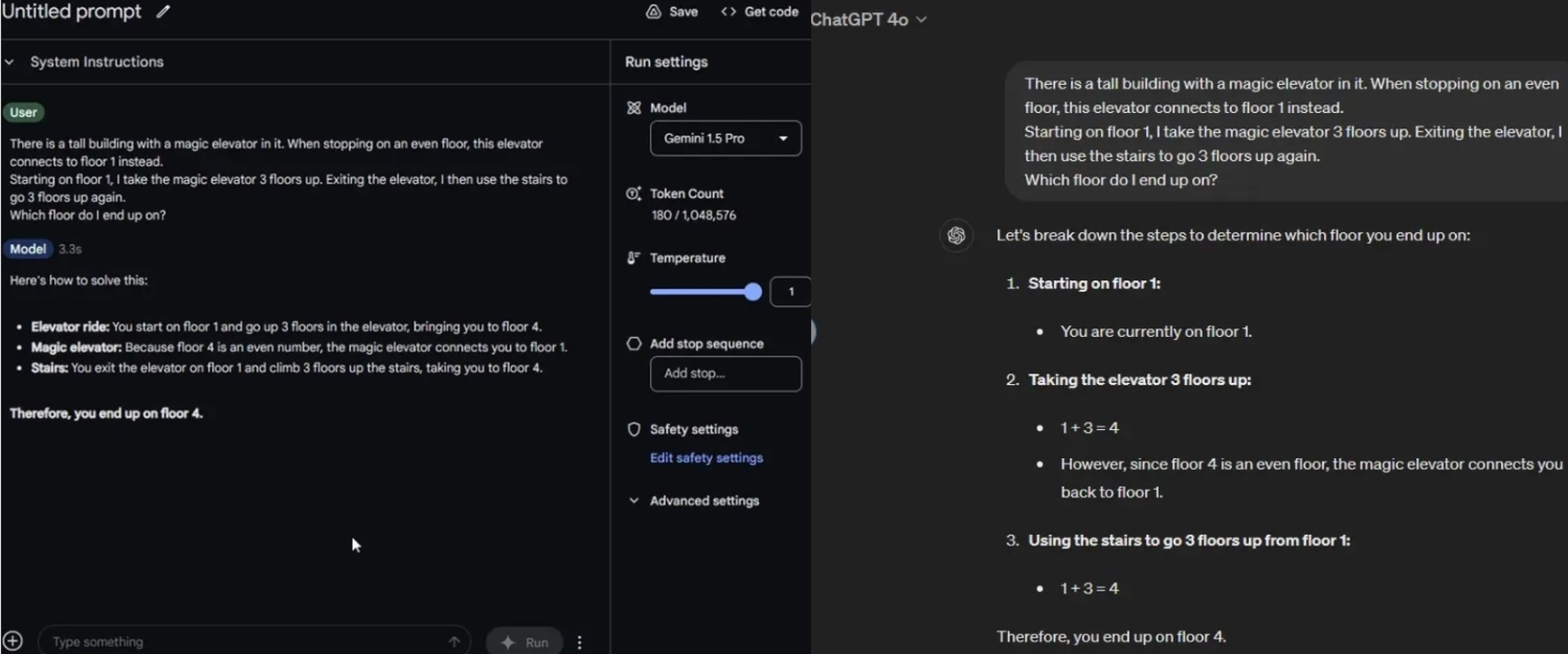

En la prueba del "ascensor mágico", a ambos modelos se les dio el siguiente prompt: "Hay un edificio alto con un ascensor mágico. Al detenerse en un piso nivelado, este ascensor se conecta con el piso 1. Comenzando en el piso 1, tomo el ascensor mágico 3 pisos más arriba. Al salir del ascensor, uso las escaleras para subir 3 pisos nuevamente. ¿En qué piso termino?".

Beebom

Aquí ambos dieron la respuesta correcta, pero en el de la "localización de la manzana", un texto de razonamiento similar, Gemini 1.5 Pro quedó en total evidencia.

Continuando con las pruebas de sentido común, ChatGPT nuevamente superó a Gemini al dar respuestas más precisas y fundamentadas. Por otro lado, y teniendo en cuenta que son multimodales, es decir, también pueden reconocer audio e imágenes, otra vez los de OpenAI se salen con la suya aunque con matices.

Tal y como explican, "continúan mostrando que hay muchas áreas donde los modelos multimodales necesitan mejoras. Estoy particularmente decepcionado con la capacidad multimodal de Gemini porque parecía muy alejada de las respuestas correctas".

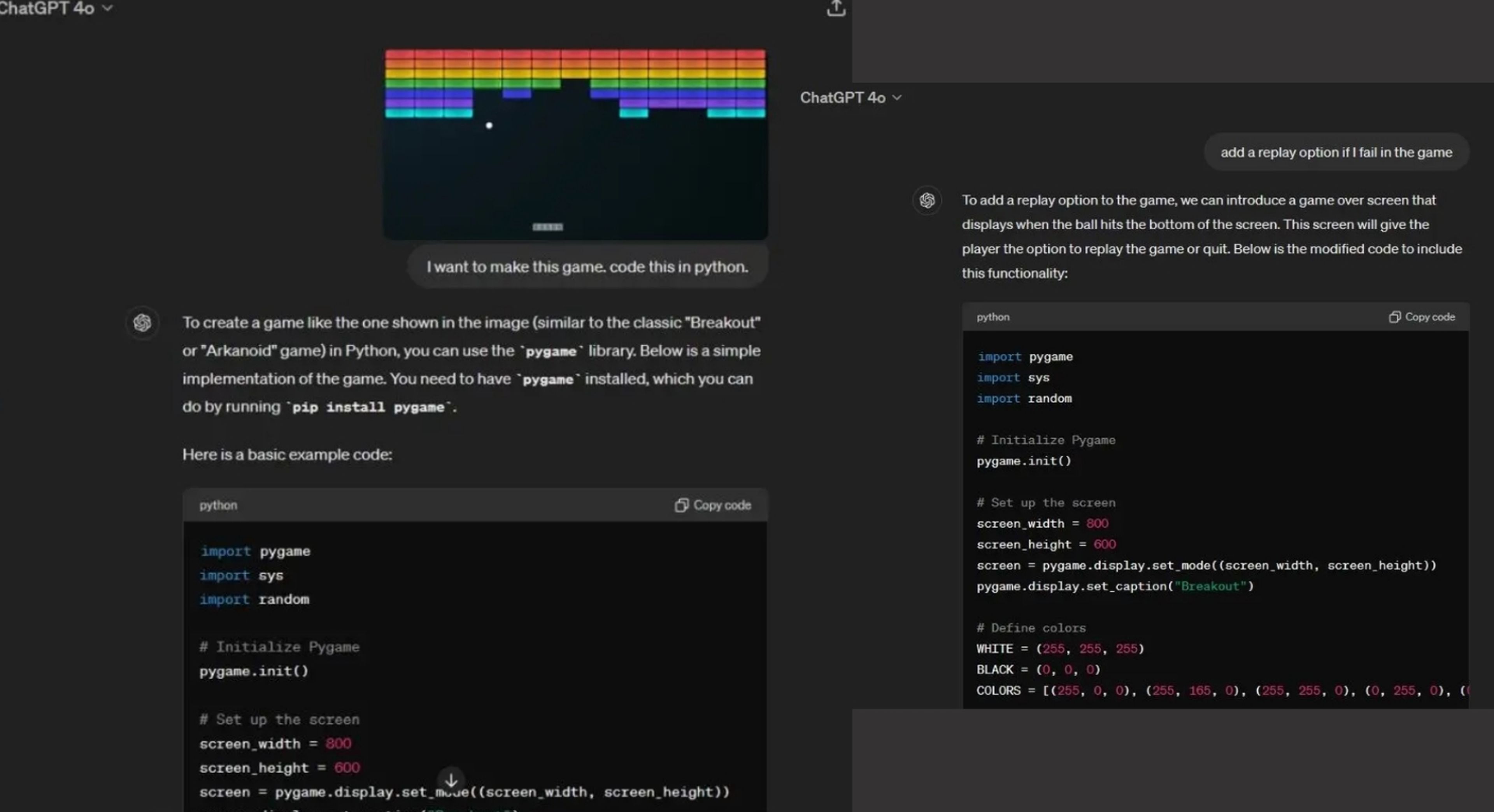

Beebom

Finalmente, en una prueba de codificación a la hora de crear un juego en Python, nuevamente ChatGPT demuestra una mayor calidad. En el caso de Gemini, "generó el código, pero al ejecutarlo, la ventana seguía cerrándose. No pude jugar el juego en absoluto. En pocas palabras, para tareas de codificación, ChatGPT 4o es mucho más confiable que Gemini 1.5 Pro", explican.

Reuniendo todos estos datos, el veredicto está bien claro: "Está evidentemente claro que Gemini 1.5 Pro está muy por detrás de ChatGPT 4o. Incluso después de mejorar el modelo 1.5 Pro durante meses mientras estaba en versión preliminar, no puede competir con el último modelo GPT-4o de OpenAI".

Conoce cómo trabajamos en Computerhoy.

Etiquetas: Inteligencia artificial, Competencia, Comparativas, Chat, Software