Inteligencia artificial y fake news: ChatGPT y su potencial para difundir información falsa

ChatGPT, pese a sus grandes y numerosas utilidades, no queda exenta de grandes fallos en sus respuesta que, en este caso, se basan en la desinformación y la difusión de fake news.

Tras su triunfal lanzamiento a finales del año pasado, ChatGPT, fundado por OpenAI y respaldado por Microsoft, ha causado una gran revolución elogiando sus respuestas similares a las humanas y la velocidad con la que puede presentar todo tipo de información. Además, ha conseguido que grandes compañías tecnológicas como Google entren en pánico y se apresuren a lanzar sus propias versiones.

ChatGPT es obviamente una herramienta nueva y poderosa que tiene el potencial de hacer mucho bien en casi todos los sectores, pero también hay desventajas. Entre ellos, herramientas de inteligencia artificial como ChatGPT podrán producir, casi de forma ilimitada todo tipo de opiniones de cualquier tema que les preguntes.

El problema de base es que esta información, que a menudo ha demostrado ser inexacta, también podría tener consecuencias peligrosas para la difusión de fake news o noticias falsas online.

Por supuesto, esto no solo se queda en un texto con información falsa y la desinformación puede tener consecuencias muy graves como influir en la opinión pública. Con la capacidad de generar grandes cantidades de texto de manera rápida y muy convincente, las herramientas de IA generativa como ChatGPT se pueden usar para difundir fake news a gran escala.

- ChatGPT y su potencial para difundir fake news

- Por qué ChatGPT da información errónea

- ¿El aprendizaje por refuerzo humano (RLHF) como solución a este problema?

ChatGPT y su potencial para difundir fake news

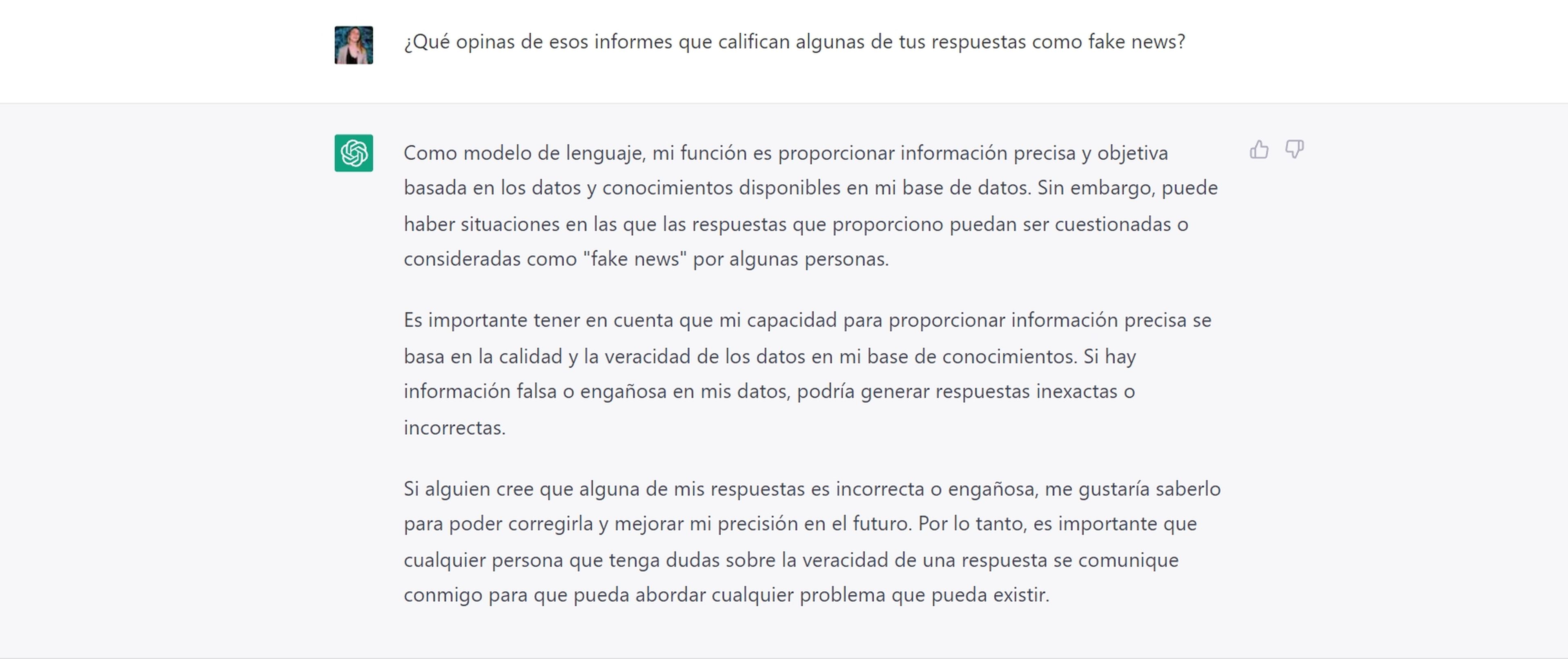

Este es un problema que destaca NewsGuard, una empresa de periodismo y tecnología que califica la credibilidad de los sitios web de noticias y rastrea la información errónea online, en un nuevo informe.

NewsGuard realizó una investigación utilizando una muestra de 100 narraciones falsas de su base de datos patentada de 1131 narraciones de información errónea en las noticias para resaltar cómo ChatGPT podría ayudar a difundir información errónea tóxica "a una escala sin precedentes", tal y como matizan.

Los resultados confirman los temores sobre cómo la herramienta podría ser un arma de gran calibre en la manos equivocadas. ChatGPT generó textos falsos, incluidos artículos de noticias, ensayos y guiones de televisión, para 80 de las 100 narrativas falsas previamente identificadas.

Por qué ChatGPT da información errónea

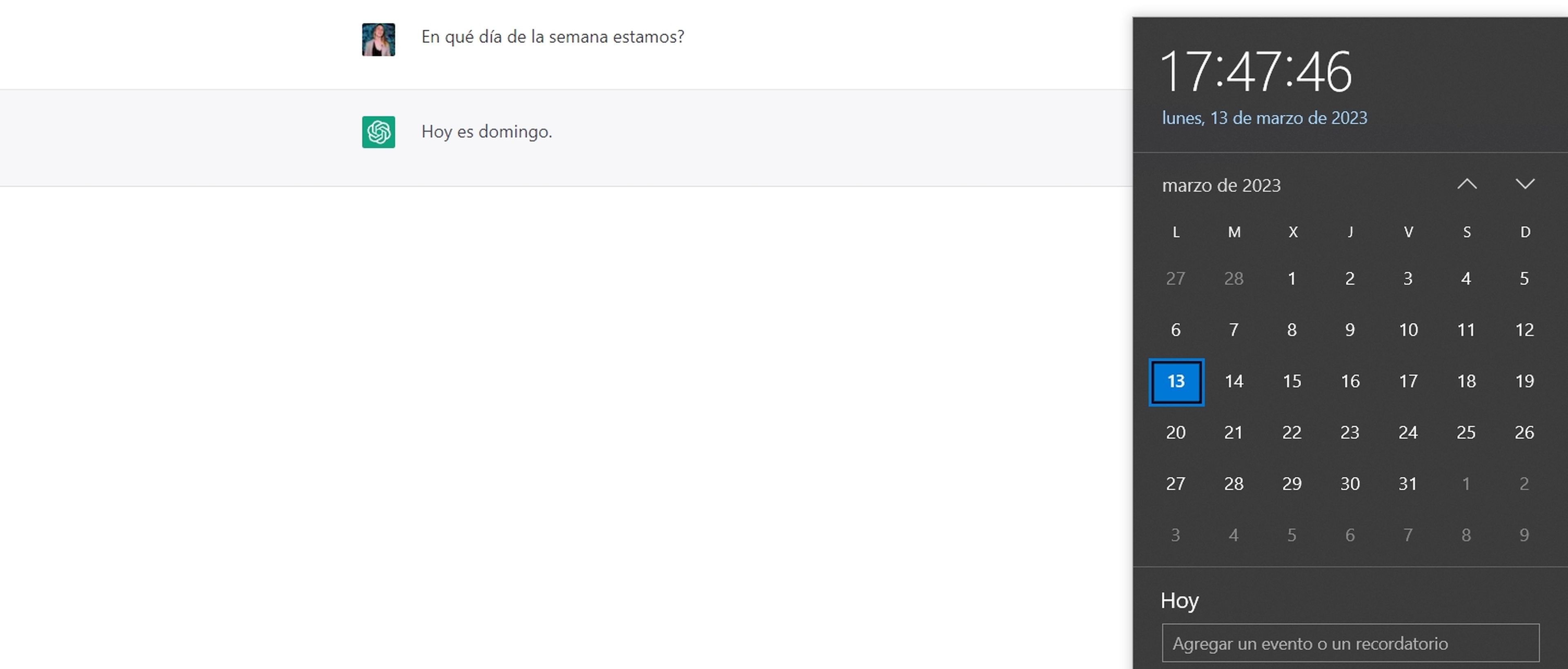

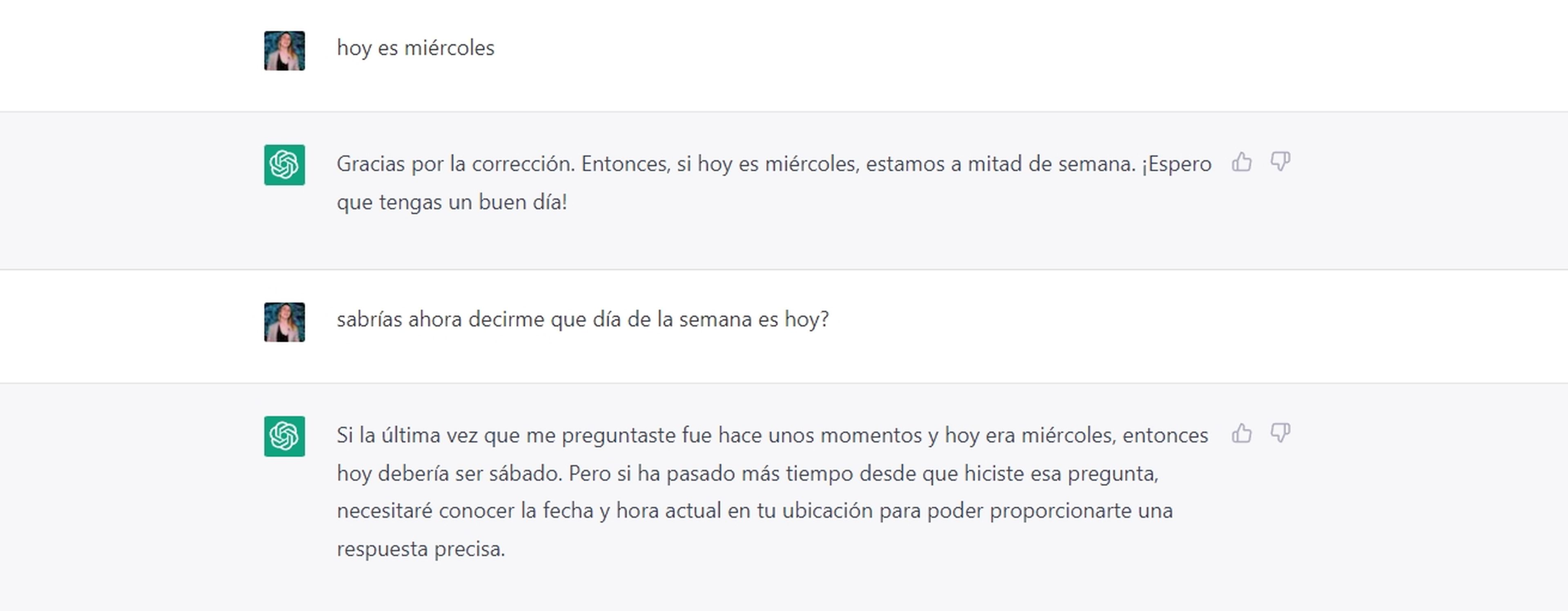

En pocas palabras, ChatGPT se basa en un modelo que responde en función de probabilidades. Por ejemplo, si le preguntas en qué día de la semana te encuentras, una respuesta que incluya de Lunes a Viernes es más probable que un día del mes, aunque esto no significa que responda correctamente con el día en el que te encuentras.

Teniendo esto en cuenta, en la explicación de un concepto que le solicitas a este chatbot este irá construyendo una respuesta, palabra por palabra, con probabilidades y, por lo tanto, esto puede dar a error.

Este es su gran punto a mejorar pero, si bien es cierto, que puede dar información falsa debido a un contenido erróneo con el que ha sido entrenado, sus respuestas incorrectas no se deben en su totalidad a este aspecto.

Actúa bien a la hora de encajar el lenguaje, que ya es todo un logro, pero no cuenta con un contexto de los que es la realidad o los hechos y por eso cuando le preguntes algo, existen una mínima posibilidad de fallar. La base es que esto modelos no están desarrollados para dar datos si no para generar lenguaje.

Vale la pena señalar que OpenAI ha dicho que su próxima versión de la herramienta, GPT-4, tendrá más conocimientos y será más precisa en sus respuestas con una probabilidad de error más baja.

Tal y como se comenta en otro artículo de Computer Hoy, GPT-4, según explicó Sam Altman, CEO de OpenAI, probablemente no será mucho más grande que GPT-3, pero requerirá mucha más potencia de cálculo. Los avances deberían proceder principalmente de datos de mayor calidad, mejores algoritmos y un ajuste más preciso.

Según Altman, OpenAI está mejorando actualmente la eficiencia de los sistemas de IA más pequeños, por lo tanto, tal vez no haya necesidad de modelos de inteligencia artificial de proporciones aún más gigantescas. "En el futuro, mucha gente se sorprenderá de lo potente que puede llegar a ser la IA sin que crezcan los parámetros", afirma.

¿El aprendizaje por refuerzo humano (RLHF) como solución a este problema?

El aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF) es un subcampo del aprendizaje por refuerzo que se centra en cómo los agentes de inteligencia artificial como ChatGPT pueden aprender de la retroalimentación humana.

En el caso de este chatbot, OpenAI en un inicio contrató a un grupo de escritores humanos y les pidieron que escribieran respuestas a un montón de indicaciones. Utilizaron el conjunto de datos de preguntas y respuestas para ajustar el modelo de ChatGPT.

En la segunda fase, crearon su modelo de recompensa basado en un procedimiento estándar, generando múltiples respuestas a las indicaciones y haciendo que los humanos las clasificaran de mejor a peor respuesta.

Si bien es una técnica muy eficiente, RLHF también tiene varias limitaciones. El trabajo humano siempre se convierte en un cuello de botella. Es un proceso lento y costoso que funciona bien para determinados datos. Sin embargo, si se añaden novedades en las preguntas de los usuarios, se vuelve al inicio y de nuevo, puede fallar.

Por otro lado, RLHF tampoco es una solución perfecta. La retroalimentación humana puede ayudar a evitar que los modelos generen resultados dañinos o erróneos, pero las preferencias humanas no están bien definidas y nunca se puede crear un modelo que se ajuste a las preferencias y normas de todas las sociedades. Sin embargo, sí que es un primer gran paso para mejorar modelos como el de ChatGPT.

Con todo esto, la difusión de información falsa o incluso fake news no es un asunto banal y tristemente ChatGPT es bastante maleable. Muchos países como España están poniendo el foco en la desinformación ya que todos saben que esta se puede utilizar para infundir miedo y odio, movilizar grupos e incluso llegar a destruir la democracia.

Por supuesto, que ChatGPT y su uso por millones de personas preocupa y mucho, ya que se sabe que esta problemática será vista como una oportunidad por algunos países y grupos políticos para promover su propia agenda y destruir al resto.

Redactora de Tecnología

Redactora de Tecnología, especializada en inteligencia artificial y ciberseguridad.

Otros artículos interesantes:

Conoce cómo trabajamos en Computerhoy.